Alibaba ha rilasciato più di 100 modelli di intelligenza artificiale open-source, tra cui Qwen 2.5 72B che batte altri modelli open-source nei benchmark matematici e di codifica.

Gran parte dell'attenzione dell'industria dell'intelligenza artificiale sui modelli open-source è stata rivolta agli sforzi di Meta con Llama 3, ma Qwen 2.5 di Alibaba ha colmato il divario in modo significativo. La famiglia di modelli Qwen 2.5, appena rilasciata, ha dimensioni che vanno da 0,5 a 72 miliardi di parametri, con modelli di base generalizzati e modelli focalizzati su compiti molto specifici.

Alibaba afferma che questi modelli sono dotati di "conoscenze migliorate e capacità più forti in matematica e codifica", con modelli specializzati che si concentrano su codifica, matematica e modalità multiple, tra cui linguaggio, audio e visione.

Alibaba Cloud ha anche annunciato un aggiornamento del suo modello di punta proprietario Qwen-Max, che non ha rilasciato come open-source. I benchmark del Qwen 2.5 Max sembrano buoni, ma è il modello Qwen 2.5 72B che ha generato la maggior parte dell'entusiasmo tra i fan dell'open-source.

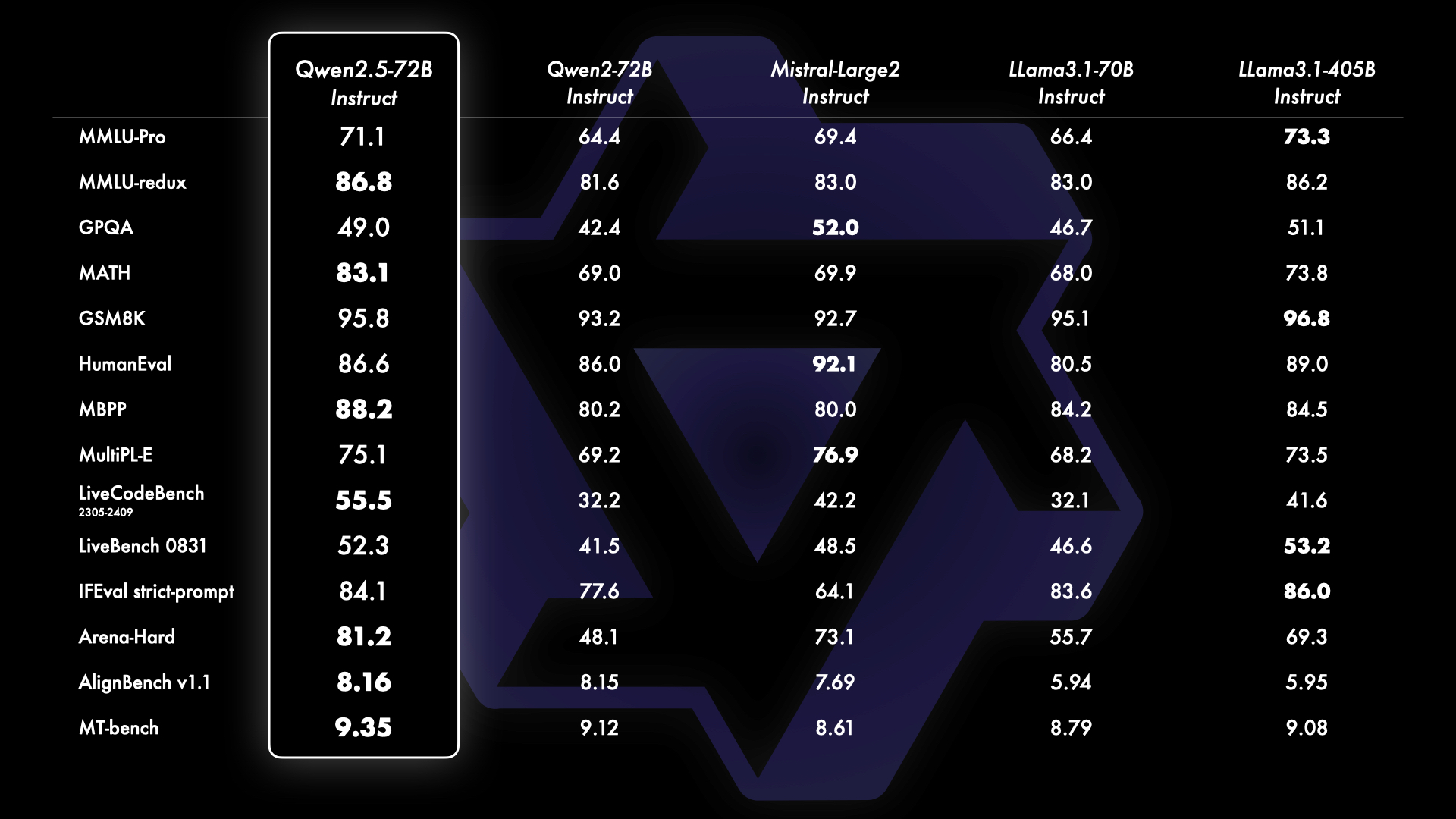

I benchmark mostrano che Qwen 2.5 72B batte l'ammiraglia Meta, molto più grande. Lama 3.1 405B modello su diversi fronti, soprattutto in matematica e codifica. Anche il divario tra i modelli open-source e quelli proprietari, come quelli di OpenAI e Google, si sta riducendo rapidamente.

I primi utilizzatori di Qwen 2.5 72B mostrano che il modello è appena inferiore a Sonnet 3.5 e persino superiore a Sonnet 3.5. OpenAImodelli o1 nella codifica.

L'open source Qwen 2.5 batte i modelli o1 sulla codifica 🤯🤯🤯

Qwen 2.5 ottiene punteggi superiori ai modelli o1 per quanto riguarda la codifica su Livebench AI

Qwen è appena al di sotto di Sonnet 3.5, e per una modalità open-source è fantastico!!!

o1 è bravo in alcune operazioni di codifica, ma è terribile nei problemi di completamento del codice e... pic.twitter.com/iazam61eP9

- Bindu Reddy (@bindureddy) 20 settembre 2024

Alibaba afferma che tutti i nuovi modelli sono stati addestrati sul suo set di dati su larga scala che comprende fino a 18 trilioni di token. I modelli Qwen 2.5 hanno una finestra di contesto fino a 128k e possono generare output fino a 8k token.

Il passaggio a modelli gratuiti più piccoli, più capaci e open-source avrà probabilmente un impatto più ampio su molti utenti rispetto a modelli più avanzati come o1. Le funzionalità edge e on-device di questi modelli significano che si può ottenere molto da un modello gratuito in esecuzione sul proprio laptop.

Il modello più piccolo Qwen 2.5 offre una codifica di livello GPT-4 a una frazione del costo, o addirittura gratis se si dispone di un laptop decente per eseguirlo localmente.

A casa abbiamo il GPT-4 per la codifica! Ho cercato OpenAI?ref_src=twsrc%5Etfw”>@OpenAI I risultati di GPT-4 0613 per vari benchmark sono stati confrontati con quelli di @Alibaba_Qwen 2,5 Codificatore 7B. 👀

> 15 mesi dopo il rilascio di GPT-0613, abbiamo un LLM aperto sotto Apache 2.0, che funziona altrettanto bene. 🤯

> Prezzo GPT-4... pic.twitter.com/2szw5kwTe5

- Philipp Schmid (@_philschmid) 22 settembre 2024

Oltre agli LLM, Alibaba ha rilasciato un aggiornamento significativo del suo modello di linguaggio di visione con l'introduzione di Qwen2-VL. Qwen2-VL è in grado di comprendere video di oltre 20 minuti e supporta le risposte a domande basate su video.

È stato progettato per essere integrato in telefoni cellulari, automobili e robot per consentire l'automazione di operazioni che richiedono una comprensione visiva.

Alibaba ha anche presentato un nuovo modello text-to-video come parte del suo generatore di immagini, la grande famiglia di modelli Tongyi Wanxiang. Tongyi Wanxiang AI Video è in grado di produrre contenuti video di qualità cinematografica e animazioni 3D con vari stili artistici sulla base di suggerimenti testuali.

Le demo sembrano impressionanti e lo strumento è gratuito, anche se è necessario un numero di cellulare cinese per poterlo utilizzare. iscriviti qui. Sora avrà una seria concorrenza quando, o se, OpenAI lo rilascerà.