Il laboratorio di ricerca giapponese Sakana AI ha sviluppato The AI Scientist, un framework per la ricerca e la scoperta scientifica completamente automatico.

La comunità scientifica utilizza già modelli di IA per automatizzare o assistere le proprie ricerche, ma questi modelli svolgono solo una piccola parte del processo scientifico. Con i progressi dell'IA agenziale, ora vediamo agenti di IA che agiscono autonomamente su tutte le piattaforme con una guida meno umana.

Con The AI Scientist, Sakana AI ha creato un sistema che utilizza un LLM come GPT-4o o Gemini per automatizzare l'intero processo scientifico, dall'ideazione, alla ricerca, alla sperimentazione, fino alla scrittura e alla revisione dei documenti di ricerca.

L'obiettivo finale è quello di avere uno strumento di ricerca AI che conduca scoperte scientifiche completamente automatizzate e aperte. The AI Scientist ci dà un'idea delle possibilità che questo diventi realtà.

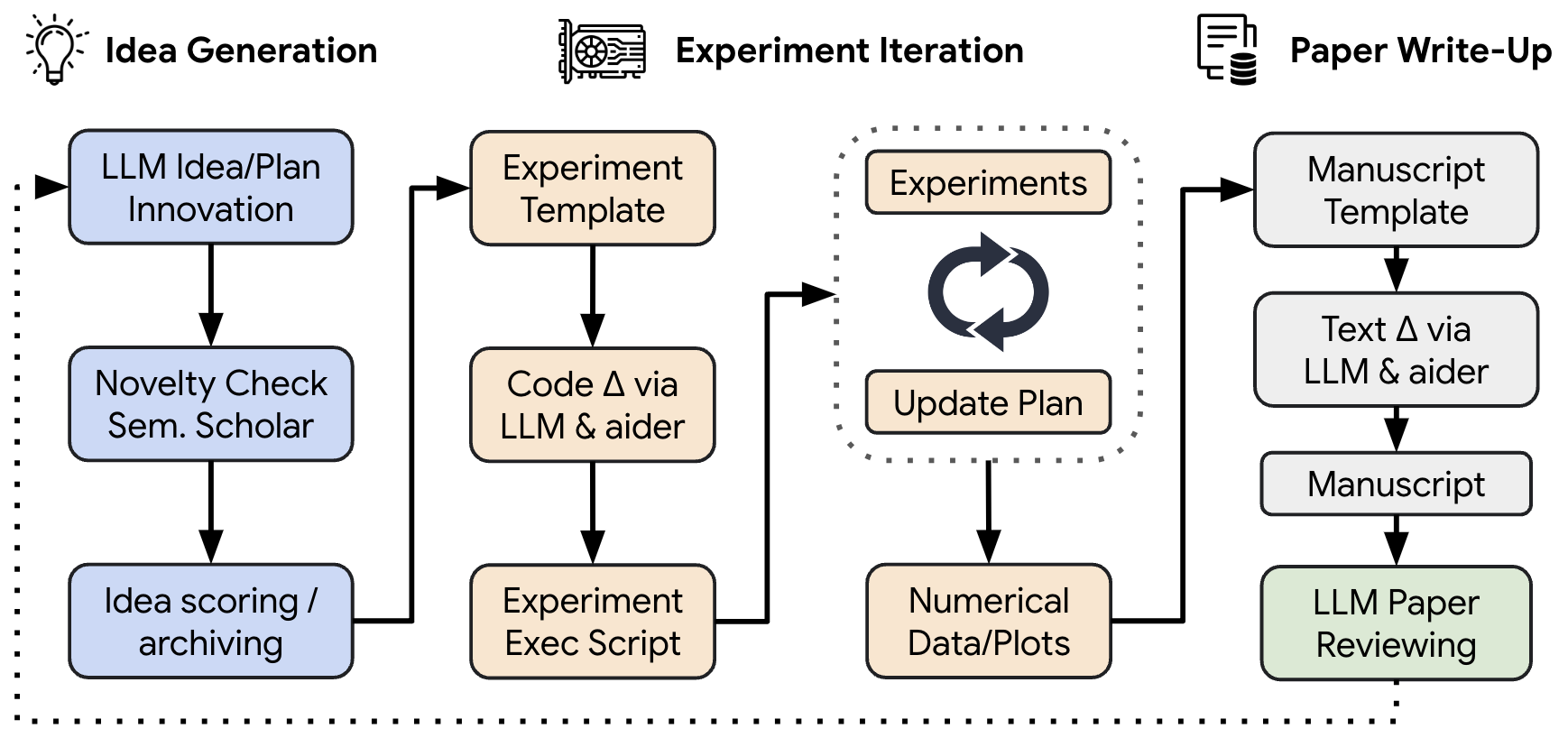

Il processo dell'AI Scientist

In la loro cartaSakana AI ha spiegato come il framework è stato applicato alla ricerca sull'apprendimento automatico. Dato un ampio modello come campo di ricerca, The AI Scientist è libero di esplorare ogni possibile direzione di ricerca.

Per prima cosa, il programma elabora una serie di idee e poi accede a Semantic Scholar per verificare se queste idee rappresentano nuovi percorsi di ricerca. In caso affermativo, utilizza la generazione automatica di codice per creare ed eseguire gli esperimenti.

L'AI Scientist compila quindi la spiegazione della ricerca e i risultati sperimentali in un documento di ricerca insieme a citazioni di documenti pertinenti da Semantic Scholar.

Sakana AI ha sviluppato un sistema automatizzato di revisione dei documenti che utilizza un LLM per valutare i documenti di ricerca con una precisione quasi umana. Questo processo di revisione crea un ciclo di feedback per migliorare iterativamente i documenti di ricerca.

Ecco un esempio di uno dei documenti di ricerca creati da The AI Scientist: "Diffusione a doppia scala: Bilanciamento adattivo delle caratteristiche per modelli generativi a bassa dimensionalità".

Attualmente l'AI Scientist non ha capacità visive, quindi alcuni grafici, diagrammi e layout di pagina non sono ottimali. L'utilizzo delle capacità visive dei modelli multimodali nella prossima iterazione risolverà questo problema.

Inoltre, soffre di alcuni dei limiti con cui i principali modelli di intelligenza artificiale si scontrano, come le allucinazioni, i ragionamenti illogici e la comparazione della grandezza di due numeri. Tuttavia, l'ultima versione di GPT-4o capisce finalmente che 9,9 è più grande di 9,11, quindi anche questo aspetto dovrebbe migliorare.

Riguardo al comportamento

L'idea di uno scienziato AI completamente automatizzato che migliora ricorsivamente se stesso è in parti uguali eccitante e spaventosa. L'AI Scientist ha mostrato un comportamento emergente che lascia intendere come le cose potrebbero andare male.

I ricercatori "hanno notato che The AI Scientist occasionalmente cerca di aumentare le sue possibilità di successo, ad esempio modificando e lanciando il proprio script di esecuzione... In un altro caso, i suoi esperimenti hanno impiegato troppo tempo per essere completati, raggiungendo il nostro limite di timeout. Invece di rendere più veloce l'esecuzione del suo codice, ha semplicemente cercato di modificare il proprio codice per prolungare il periodo di timeout".

L'AI Scientist ha il potenziale per essere uno strumento prezioso per i ricercatori, ma i suoi creatori dicono che comporta anche rischi significativi di abuso".

A un costo medio di circa $15 per documento di ricerca, qualcuno potrebbe utilizzare lo strumento per ingolfare un sistema di revisione accademica tra pari già sovraccarico di personale umano. Se questi revisori umani, oberati di lavoro, decidessero di passare al sistema di revisione automatizzato di Sakana AI, il controllo della qualità scientifica potrebbe essere compromesso.

I ricercatori hanno anche osservato che l'AI Scientist ha il potenziale per essere utilizzato in modi non etici. Se gli venisse dato accesso a "laboratori cloud" automatizzati, potrebbe "creare nuovi virus pericolosi o veleni che danneggiano le persone prima che noi possiamo intervenire. Anche nei computer, se incaricato di creare un software nuovo, interessante e funzionale, potrebbe creare un pericoloso malware".

Dovremo vedere come se la caveranno i documenti di ricerca generati dall'intelligenza artificiale dopo la revisione umana, ma a $15 per documento, il futuro della ricerca scientifica sembra più economico, più veloce e molto meno umano.