Quando ChatGPT fornisce la risposta giusta alla richiesta, ragiona sulla richiesta o ricorda semplicemente la risposta dai suoi dati di addestramento?

I ricercatori del Computer Science and Artificial Intelligence Laboratory (CSAIL) del MIT hanno progettato una serie di test per verificare se i modelli di intelligenza artificiale "pensano" o hanno solo una buona memoria.

Quando si chiede a un modello di intelligenza artificiale di risolvere un problema matematico come "Quanto fa 27+62?", il modello risponde rapidamente con la risposta corretta: 89. Come possiamo dire se il modello comprende l'aritmetica sottostante o se ha semplicemente visto il problema nei suoi dati di addestramento?

In la loro cartaI ricercatori hanno testato GPT-4, GPT-3.5 Turbo, Claude 1.3 e PaLM2 per vedere se erano in grado di "generalizzare non solo a istanze non viste di compiti noti, ma anche a nuovi compiti".

Hanno progettato una serie di 11 compiti che differivano leggermente dai compiti standard in cui i LLM generalmente ottengono buoni risultati.

I LLM dovrebbero ottenere le stesse prestazioni con i "compiti controfattuali" se utilizzano procedure di risoluzione dei compiti generali e trasferibili.

Se un LLM "capisce" la matematica, allora dovrebbe fornire la risposta corretta a un problema matematico in base 10 e nella raramente utilizzata base 9, per esempio.

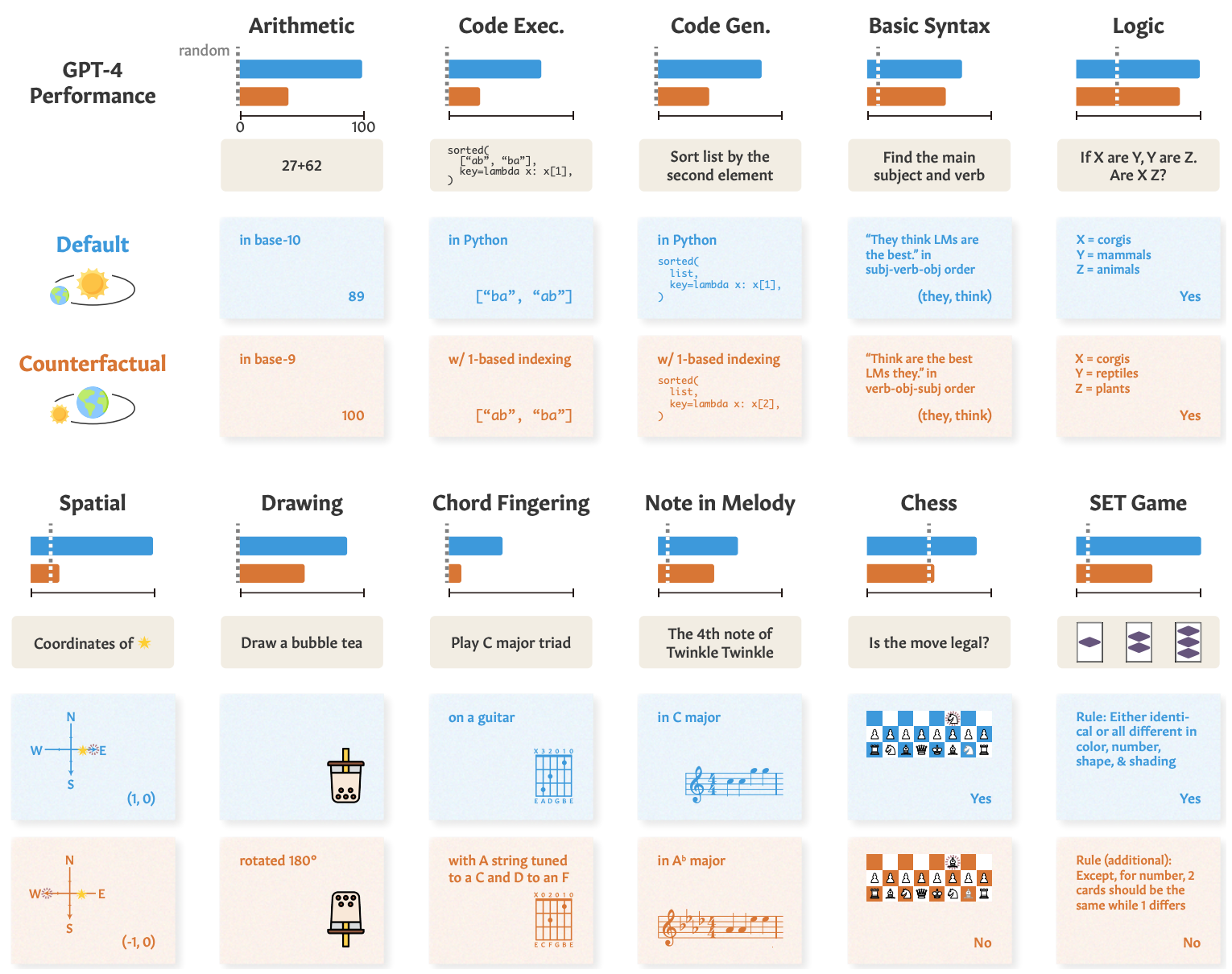

Ecco alcuni esempi di attività e di prestazioni del GPT-4.

Le prestazioni del GPT-4 nei test standard (linea blu) sono buone, ma le sue abilità matematiche, di ragionamento logico, spaziale e di altro tipo (linea arancione) peggiorano significativamente quando il compito viene leggermente modificato.

Gli altri modelli hanno mostrato un degrado simile, con il GPT-4 in testa.

Nonostante il degrado, le prestazioni nei compiti controfattuali erano ancora migliori del caso. I modelli di intelligenza artificiale cercano di ragionare su questi compiti, ma non sono molto bravi.

I risultati mostrano che le impressionanti prestazioni dei modelli di intelligenza artificiale in compiti come gli esami universitari si basano su un eccellente richiamo dei dati di formazione, non sul ragionamento. Ciò evidenzia ulteriormente che i modelli di intelligenza artificiale non possono generalizzarsi a compiti inediti,

Zhaofeng Wu, dottorando in ingegneria elettrica e informatica del MIT, affiliato al CSAIL e autore principale del lavoro, ha dichiarato: "Abbiamo scoperto un aspetto affascinante dei modelli linguistici di grandi dimensioni: eccellono in scenari familiari, quasi come un sentiero ben battuto, ma faticano quando il terreno diventa sconosciuto". Questa intuizione è fondamentale per migliorare l'adattabilità di questi modelli e ampliare i loro orizzonti applicativi".

Abbiamo visto una dimostrazione simile di questa incapacità di generalizzare quando abbiamo esplorato quanto siano scadenti i modelli di intelligenza artificiale a risolvere un puzzle semplificato di attraversamento del fiume.

I ricercatori hanno concluso che, quando gli sviluppatori analizzano i loro modelli, dovrebbero "considerare l'abilità astratta del compito come distaccata dalla prestazione osservata del compito".

L'approccio "train-to-test" può far avanzare un modello nei benchmark, ma non offre una vera misura di come il modello si comporterà quando gli verrà presentato un nuovo compito su cui ragionare.

I ricercatori suggeriscono che parte del problema è che questi modelli sono addestrati solo su testi di forma superficiale.

Se i LLM sono esposti a dati contestualizzati e a rappresentazioni semantiche più reali, potrebbero essere in grado di generalizzare quando vengono presentate variazioni del compito.