Il CEO di NVIDIA Jensen Huang ha utilizzato il discorso di apertura del keynote dell'evento Computex 2024 di Taiwan per svelare le tecnologie di nuova generazione e la roadmap che l'azienda perseguirà per diventare la principale piattaforma hardware di AI.

Il tema del suo discorso era "Accelerare tutto" e Huang ha presentato nuovi chip, reti AI più veloci e un'ambiziosa roadmap di sviluppo. Dai PC con intelligenza artificiale alle fabbriche di intelligenza artificiale di massa, NVIDIA vuole essere l'abilitatore di ciò che verrà con l'intelligenza artificiale.

"Il futuro dell'informatica è accelerato", ha dichiarato Huang. "Con le nostre innovazioni nel campo dell'intelligenza artificiale e dell'elaborazione accelerata, stiamo superando i limiti del possibile e guidando la prossima ondata di progresso tecnologico".

Ecco un rapido sguardo ad alcuni degli annunci:

Nuovi chip

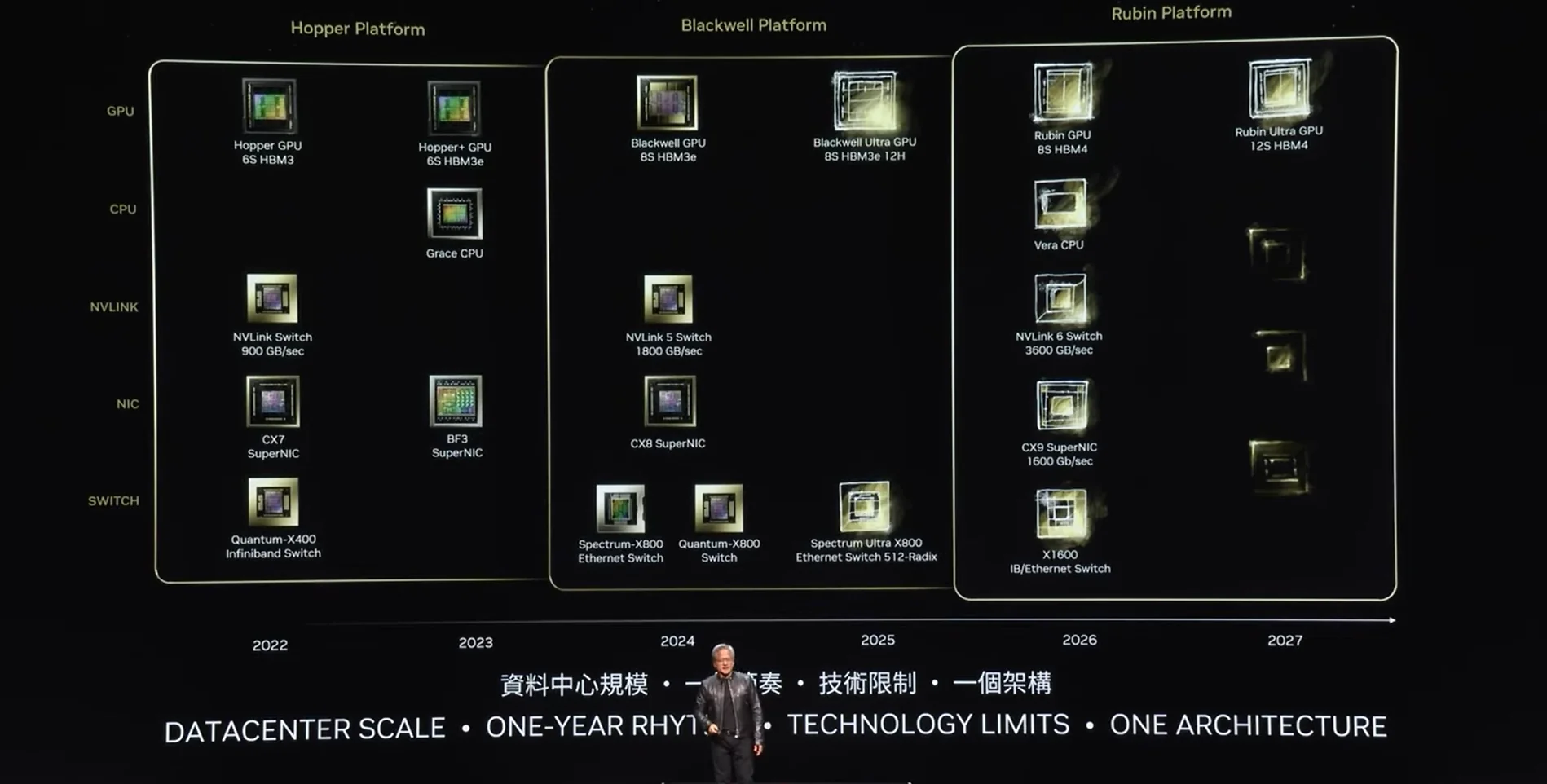

Le GPU Blackwell sono appena uscite dalla linea di produzione, ma Huang ha dichiarato che possiamo già aspettarci una GPU Blackwell Ultra aggiornata nel corso dell'anno. Ha dichiarato che la roadmap di sviluppo di NVIDIA prevede il rilascio di una nuova famiglia di chip ogni anno.

"La nostra azienda ha un ritmo di un anno. La nostra filosofia di base è molto semplice: costruire l'intera scala del data center, disaggregare e vendere le parti a un ritmo annuale e spingere tutto ai limiti della tecnologia", ha spiegato Huang.

Huang ha annunciato che nel 2026 la sua piattaforma Rubin succederà alla famiglia di GPU Blackwell.

Fabbriche di intelligenza artificiale

Huang ha nominato diverse aziende di computing che costruiranno "fabbriche di intelligenza artificiale" in grado di fornire sistemi di intelligenza artificiale in cloud, on-premise, embedded ed edge utilizzando le GPU e il networking di NVIDIA.

Huang ha dichiarato: "La prossima rivoluzione industriale è iniziata. Aziende e paesi stanno collaborando con NVIDIA per spostare i data center tradizionali da un trilione di dollari verso il computing accelerato e costruire un nuovo tipo di data center - le fabbriche di AI - per produrre una nuova merce: l'intelligenza artificiale."

NVIDIA MGX (Modular Server Reference Architecture) è un progetto per la costruzione di server per data center che si concentra sull'elaborazione accelerata. Utilizza un approccio standardizzato per la costruzione di server che utilizzano prodotti NVIDIA, il che rende molto più semplice la realizzazione di queste fabbriche di intelligenza artificiale.

NVIDIA Spectrum-X

NVIDIA utilizza NVLink per spostare i dati tra le GPU, ma lo spostamento dei dati tra i pod delle GPU all'interno o tra i data center rappresenta un'ulteriore sfida.

NVIDIA Spectrum-X è la prima piattaforma di rete Ethernet al mondo progettata specificamente per migliorare le prestazioni dei carichi di lavoro AI. Naturalmente, NVIDIA Spectrum-X è ottimizzato per l'hardware di NVIDIA.

NVIDIA afferma che Spectrum-X accelera le prestazioni delle reti di intelligenza artificiale generativa di 1,6 volte rispetto ai tessuti Ethernet tradizionali.

La scorsa settimana abbiamo riportato la notizia che le aziende informatiche delle Big Tech stanno lavorando per sviluppare una standard di rete AI accelerato aperto senza il contributo di NVIDIA.

Tuttavia, Huang ha dichiarato che Spectrum-X è già stato adottato da aziende come Dell Technologies, Hewlett Packard Enterprise e Lenovo.

NIM

NVIDIA NIM, acronimo di NVIDIA Inference Microservices, è una serie di strumenti progettati per semplificare e accelerare l'implementazione di modelli di intelligenza artificiale generativa.

Prima di poter utilizzare un modello di intelligenza artificiale, gli sviluppatori devono distribuirlo. Invece di dover armeggiare con i dettagli di questo processo, i NIM NVIDIA semplificano la distribuzione containerizzando automaticamente i modelli di intelligenza artificiale e ottimizzandoli per l'hardware NVIDIA.

È come la differenza tra comprare, tagliare e assemblare tutti gli ingredienti per un pasto e mettere in forno un piatto pronto.

Huang ha annunciato che la NIM Llama 3 è ora disponibile come download gratuito per gli sviluppatori. Huang ha anche presentato il NIM Nvidia Ace, che include un modello Digital Human in grado di generare modelli umani AI con pelle realistica.

È possibile guardare l'intero keynote per vedere ulteriori dettagli sui PC e i laptop dotati di AI RTX, sulla piattaforma robotica Isaac ROS 3.0 di Nividia e sul modo in cui le fabbriche stanno utilizzando la tecnologia NVIDIA per creare gemelli digitali delle loro fabbriche per addestrare i robot.