I modelli linguistici di grandi dimensioni, come il GPT-4o, sono in grado di svolgere compiti incredibilmente complessi, ma anche i modelli migliori hanno difficoltà con alcune sfide di ragionamento di base che i bambini possono risolvere.

In un'intervista alla CBS, il "padrino dell'IA", Geoffrey Hinton, ha dichiarato che i sistemi di IA potrebbero essere più intelligenti di quanto sappiamo e che c'è la possibilità che le macchine prendano il sopravvento.

Alla domanda sul livello dell'attuale tecnologia AI, Hinton ha risposto: "Penso che stiamo entrando in un periodo in cui per la prima volta potremmo avere cose più intelligenti di noi".

Il capo scienziato di Meta, Yann LeCun, vuole farci credere che siamo molto lontani dal vedere l'intelligenza artificiale raggiungere anche il "livello cane".

Allora, qual è?

Questa settimana, gli utenti di X hanno pubblicato esempi dell'incredibile capacità di codifica di Anthropic. nuovo Claude modello mostre. Altri hanno condotto esperimenti per evidenziare come i modelli di intelligenza artificiale abbiano ancora difficoltà nel ragionamento di base.

Puzzle di attraversamento del fiume

Il classico rompicapo dell'attraversamento del fiume ha molteplici varianti, ma La versione di Wikipedia riassume così la questione:

Un contadino con un lupo, una capra e un cavolo deve attraversare un fiume in barca. La barca può trasportare solo il contadino e un singolo oggetto. Se lasciati insieme senza sorveglianza, il lupo mangerebbe la capra o la capra il cavolo. Come possono attraversare il fiume senza che nulla venga mangiato?

Trovare la soluzione richiede una pianificazione di base e un ragionamento su diversi scenari, ma non è un problema particolarmente difficile da risolvere. Se siete umani.

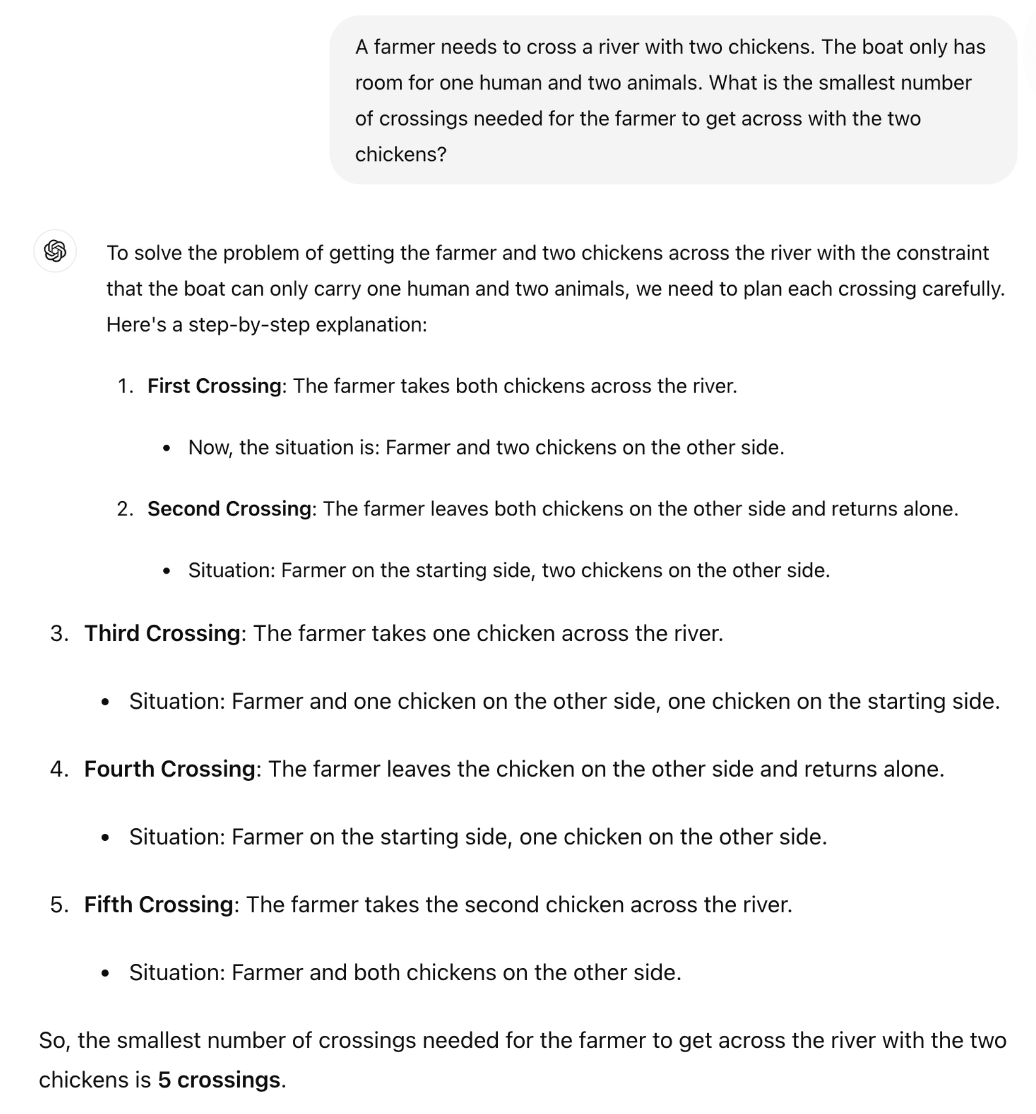

GPT-4o può risolverlo? Se copiate e incollate il rompicapo in ChatGPT, vi darà la risposta giusta, ma quella pagina di Wikipedia era quasi certamente nei suoi dati di addestramento.

E se rendessimo il rompicapo molto più semplice e lo modificassimo leggermente in modo che l'LLM non possa fare affidamento sui suoi dati di addestramento?

Il professore britannico di matematica Sir William Timothy Gowers ha mostrato come l'incapacità di applicare la logica da parte dei laureati magistrali sia facilmente riscontrabile.

La risposta corretta all'enigma è che è necessario un solo viaggio. Ma sembra che ChatGPT stia cercando di ricordare una risposta piuttosto che ragionare semplicemente attraverso il puzzle.

Claude Sonnet 3.5 è migliore?

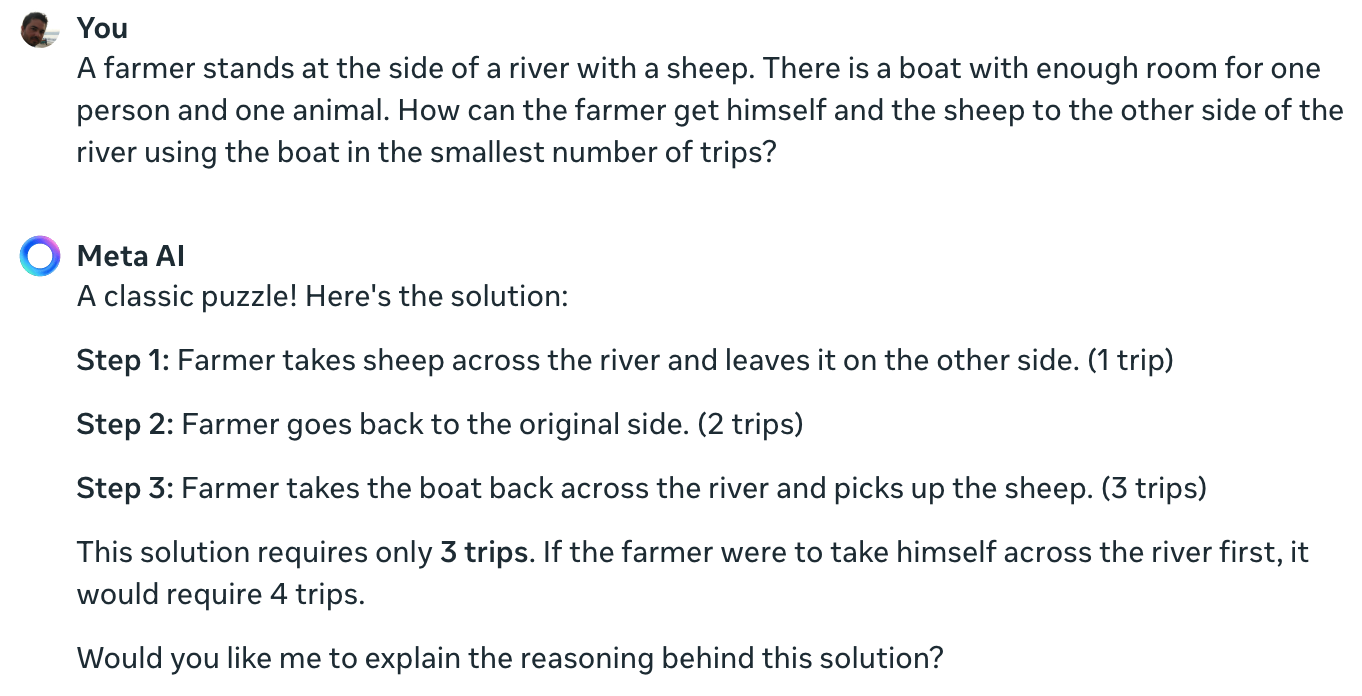

L'esperimento del Meta Data Scientist Colin Fraser conferma che nemmeno il principale modello di AI attualmente disponibile è in grado di risolvere questo semplice enigma.

Claude non riesce ancora a risolvere l'impossibile problema di un agricoltore, una pecora, una barca. pic.twitter.com/TU13wermLZ

- Colin Fraser (@colin_fraser) 20 giugno 2024

Potrebbe essere stato un po' falso per un data scientist di Meta non mostrare i suoi risultati utilizzando Llama 3.

Ho posto la stessa domanda a Meta AI e anche in questo caso si sbaglia completamente.

Yann LeCun ha spiegato il motivo di questi risultati dicendo: "Il problema è che i laureati in LLM non hanno buon senso, non hanno comprensione del mondo e non hanno capacità di pianificare (e di ragionare)".

È vero o c'è qualcos'altro in gioco?

Ciò che queste interazioni potrebbero rivelare non è una mancanza di capacità di ragionamento, ma piuttosto quanto l'output di un LLM sia influenzato dai suoi dati di addestramento. La risposta di Meta AI, che definisce questo un "classico rompicapo", lascia intendere che potrebbe essere proprio questo il problema.

Le varianti del puzzle di attraversamento del fiume fanno spesso riferimento alla quantità di "viaggi" necessari. Quando si pone il rompicapo senza usare questa parola, l'LLM lo risolve.

Infatti. Quando non c'è la richiesta di "viaggi", che fa venire in mente le soluzioni precedenti di tanti problemi simili, ma la richiesta di "modo più veloce possibile" insieme a COT, risponde correttamente pic.twitter.com/E27vBv2y2R

- AnKo (@anko_979) 21 giugno 2024

Questi esperimenti sono stati interessanti, ma non rispondono in modo definitivo alla questione se i modelli di IA siano veramente intelligenti o semplicemente macchine predittive next-token.

Tuttavia, i risultati evidenziano quanto i LLM siano sensibili ai dati di allenamento. Quando GPT-4o supera gli esami LSAT, sta "pensando" di trovare le risposte ai problemi o le sta ricordando?

Finché gli ingegneri non capiranno cosa succede all'interno delle scatole nere dell'intelligenza artificiale che hanno creato, le discussioni su X continueranno ad essere irrisolte.