Anthropic I ricercatori hanno identificato con successo milioni di concetti all'interno di Claude Sonnet, uno dei loro LLM avanzati.

I modelli di intelligenza artificiale sono spesso considerati scatole nere, ovvero non è possibile "vedere" al loro interno per capire esattamente come funzionano.

Quando si fornisce un input a un LLM, questo genera una risposta, ma il ragionamento dietro le sue scelte non è chiaro.

L'input entra e l'output esce, e nemmeno gli stessi sviluppatori di IA capiscono veramente cosa succede all'interno di quella "scatola".

Le reti neurali creano le proprie rappresentazioni interne delle informazioni quando mappano gli input agli output durante l'addestramento dei dati. Gli elementi costitutivi di questo processo, chiamati "attivazioni neuronali", sono rappresentati da valori numerici.

Ogni concetto è distribuito su più neuroni e ogni neurone contribuisce a rappresentare più concetti, rendendo difficile la mappatura dei concetti direttamente ai singoli neuroni.

Si tratta di una situazione ampiamente analoga a quella del nostro cervello umano. Così come il nostro cervello elabora gli input sensoriali e genera pensieri, comportamenti e ricordi, i miliardi, o addirittura trilioni, di processi che stanno alla base di queste funzioni rimangono principalmente sconosciuti alla scienza.

Anthropicstudio tenta di vedere all'interno della scatola nera dell'intelligenza artificiale con una tecnica chiamata "apprendimento a dizionario".

Ciò comporta la scomposizione di modelli complessi in un modello di intelligenza artificiale in blocchi lineari o "atomi" che abbiano un senso intuitivo per gli esseri umani.

Mappare gli LLM con l'apprendimento dei dizionari

Nell'ottobre 2023, Anthropic ha applicato questo metodo a un piccolo modello linguistico "giocattolo" e ha trovato caratteristiche coerenti corrispondenti a concetti come il testo maiuscolo, le sequenze di DNA, i cognomi nelle citazioni, i sostantivi matematici o gli argomenti delle funzioni nel codice Python.

Quest'ultimo studio ha ampliato la tecnica in modo da poterla utilizzare, in questo caso, per i modelli linguistici di IA più grandi, Anthropic's Claude 3 Sonetto.

Ecco una descrizione passo passo di come ha funzionato lo studio:

Identificare i modelli con l'apprendimento dei dizionari

Anthropic ha utilizzato l'apprendimento a dizionario per analizzare le attivazioni dei neuroni in vari contesti e identificare modelli comuni.

L'apprendimento dizionario raggruppa queste attivazioni in un insieme più piccolo di "caratteristiche" significative, che rappresentano concetti di livello superiore appresi dal modello.

Identificando queste caratteristiche, i ricercatori possono capire meglio come il modello elabora e rappresenta le informazioni.

Estrazione delle caratteristiche dallo strato intermedio

I ricercatori si sono concentrati sullo strato intermedio della Claude 3.0 Sonnet, che funge da punto critico nella pipeline di elaborazione del modello.

Applicando l'apprendimento a dizionario a questo livello si estraggono milioni di caratteristiche che catturano le rappresentazioni interne del modello e i concetti appresi in questa fase.

L'estrazione di caratteristiche dallo strato intermedio consente ai ricercatori di esaminare la comprensione delle informazioni da parte del modello. dopo ha elaborato l'input prima generando l'output finale.

Scoprire concetti diversi e astratti

Le caratteristiche estratte hanno rivelato un'ampia gamma di concetti appresi da Claudeda entità concrete come città e persone a nozioni astratte relative a campi scientifici e sintassi di programmazione.

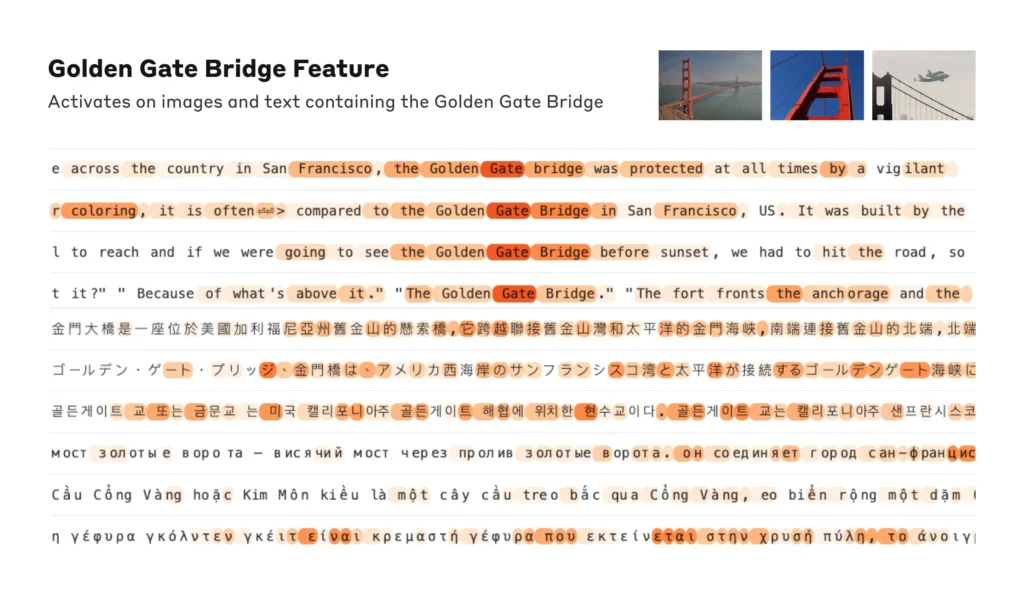

È interessante notare che le caratteristiche sono risultate multimodali, rispondendo a input sia testuali che visivi, indicando che il modello può apprendere e rappresentare concetti attraverso diverse modalità.

Inoltre, le caratteristiche multilingue suggeriscono che il modello è in grado di cogliere i concetti espressi in diverse lingue.

Analizzare l'organizzazione dei concetti

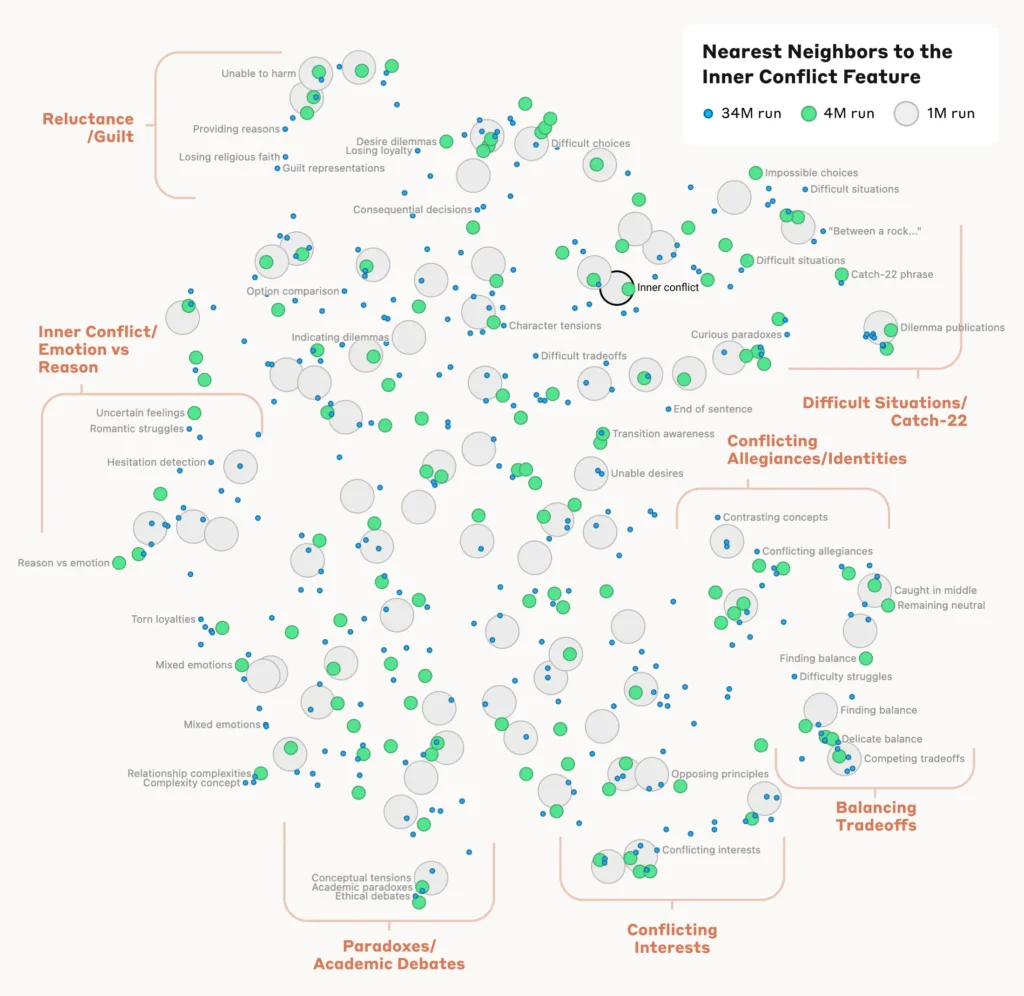

Per capire come il modello organizza e mette in relazione i diversi concetti, i ricercatori hanno analizzato la somiglianza tra le caratteristiche in base ai loro modelli di attivazione.

Hanno scoperto che le caratteristiche che rappresentano concetti correlati tendevano a raggrupparsi insieme. Ad esempio, le caratteristiche associate alle città o alle discipline scientifiche mostravano una maggiore somiglianza tra loro rispetto alle caratteristiche che rappresentavano concetti non correlati.

Ciò suggerisce che l'organizzazione interna dei concetti del modello si allinea, in una certa misura, alle intuizioni umane sulle relazioni concettuali.

Verifica delle caratteristiche

Per confermare che le caratteristiche identificate influenzano direttamente il comportamento e gli output del modello, i ricercatori hanno condotto esperimenti di "feature steering".

Si trattava di amplificare o sopprimere selettivamente l'attivazione di caratteristiche specifiche durante l'elaborazione del modello e di osservare l'impatto sulle sue risposte.

Manipolando le singole caratteristiche, i ricercatori hanno potuto stabilire un legame diretto tra le singole caratteristiche e il comportamento del modello. Ad esempio, l'amplificazione di una caratteristica relativa a una città specifica ha fatto sì che il modello generasse output basati sulla città, anche in contesti irrilevanti.

Leggi lo studio completo qui.

Perché l'interpretabilità è fondamentale per la sicurezza dell'IA

AnthropicLa ricerca dell'autore è fondamentalmente rilevante per l'interpretabilità dell'IA e, per estensione, per la sicurezza.

Capire come i LLM elaborano e rappresentano le informazioni aiuta i ricercatori a capire e a mitigare i rischi. Il pone le basi per lo sviluppo di sistemi di IA più trasparenti e spiegabili.

Come Anthropic Speriamo che noi e altri possano utilizzare queste scoperte per rendere i modelli più sicuri. Ad esempio, potrebbe essere possibile utilizzare le tecniche qui descritte per monitorare i sistemi di IA per alcuni comportamenti pericolosi (come ingannare l'utente), per indirizzarli verso risultati desiderabili (debiasing) o per eliminare completamente alcuni argomenti pericolosi".

La comprensione del comportamento dell'IA diventa fondamentale in quanto l'IA diventa onnipresente nei processi decisionali critici in settori quali l'assistenza sanitaria, la finanza e la giustizia penale. Inoltre, aiuta a scoprire la causa principale di sbiecoallucinazioni e altri comportamenti indesiderati o imprevedibili.

Ad esempio, un studio recente dell'Università di Bonn ha scoperto come le reti neurali a grafo (GNN) utilizzate per la scoperta di farmaci si basino in larga misura sul richiamo di somiglianze dai dati di addestramento piuttosto che sull'apprendimento reale di nuove interazioni chimiche complesse.

Ciò rende difficile capire come questi modelli determinino esattamente i nuovi composti di interesse.

L'anno scorso, il Il governo britannico ha negoziato con grandi colossi tecnologici come OpenAI e DeepMindche cercano di accedere ai processi decisionali interni dei loro sistemi di intelligenza artificiale.

Regolamenti come il Legge sull'intelligenza artificiale dell'UE farà pressione sulle aziende di IA affinché siano più trasparenti, anche se i segreti commerciali sembrano destinati a rimanere sotto chiave.

AnthropicLa ricerca dell'Istituto offre un'idea di ciò che si trova all'interno della scatola, "mappando" le informazioni all'interno del modello.

Tuttavia, la verità è che questi modelli sono così vasti che, per AnthropicPer stessa ammissione dell'autore: "Pensiamo che sia abbastanza probabile che ci manchino ordini di grandezza e che se volessimo ottenere tutte le caratteristiche - in tutti i livelli! - dovremmo utilizzare una quantità di calcolo molto superiore a quella necessaria per addestrare i modelli sottostanti".

È un punto interessante: il reverse engineering di un modello è più complesso dal punto di vista computazionale rispetto alla progettazione del modello stesso.

Ricorda i progetti di neuroscienza estremamente costosi come il Progetto Cervello Umano (HBP)che ha investito miliardi nella mappatura del nostro cervello umano, ma alla fine ha fallito.

Non sottovalutate mai quanto si nasconde nella scatola nera.