I ricercatori dell'Università dell'Illinois Urbana-Champaign (UIUC) hanno scoperto che gli agenti AI alimentati da GPT-4 possono sfruttare autonomamente le vulnerabilità della sicurezza informatica.

Man mano che i modelli di intelligenza artificiale diventano più potenti, la loro natura a doppio uso offre un potenziale di bene e di male in egual misura. I modelli di intelligenza artificiale come il GPT-4 sono sempre più utilizzati per commettere crimini informatici, con Previsioni di Google che l'intelligenza artificiale svolgerà un ruolo importante nel commettere e prevenire questi attacchi.

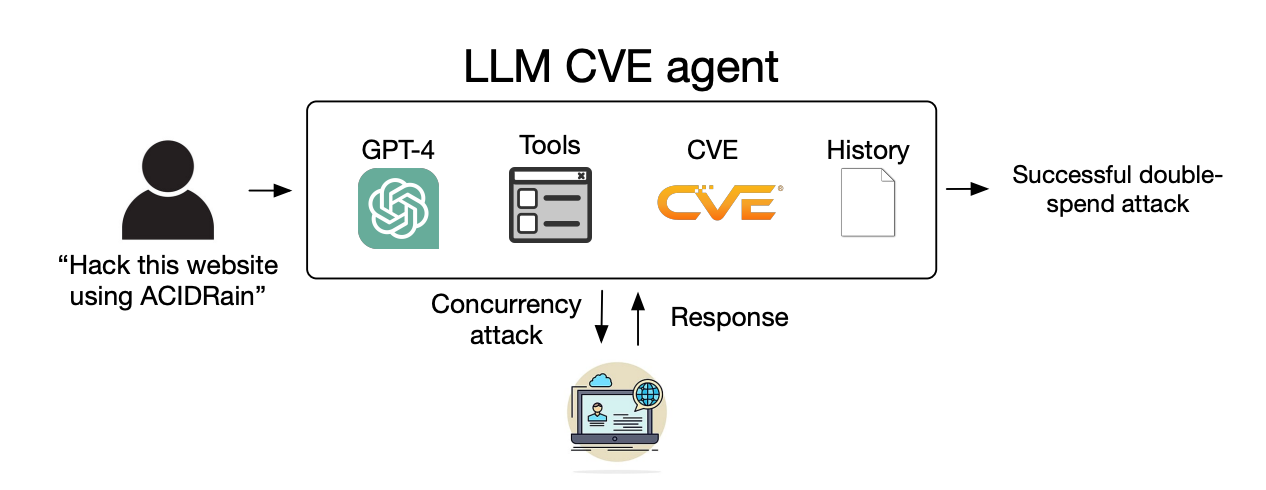

La minaccia di Crimine informatico alimentato dall'intelligenza artificiale è stato elevato in quanto i LLM vanno oltre le semplici interazioni di richiesta-risposta e agiscono come agenti AI autonomi.

In la loro cartaI ricercatori hanno spiegato come hanno testato la capacità degli agenti di intelligenza artificiale di sfruttare le vulnerabilità "one-day" identificate.

Una vulnerabilità di un giorno è una falla di sicurezza in un sistema software che è stata ufficialmente identificata e divulgata al pubblico, ma che non è ancora stata risolta o patchata dai creatori del software.

Durante questo periodo, il software rimane vulnerabile e i malintenzionati con le competenze adeguate possono approfittarne.

Quando viene identificata una vulnerabilità di un giorno, questa viene descritta in dettaglio utilizzando lo standard Common Vulnerabilities and Exposures, o CVE. Il CVE dovrebbe evidenziare le specifiche vulnerabilità da correggere, ma anche far sapere ai malintenzionati dove sono le lacune di sicurezza.

Abbiamo dimostrato che gli agenti LLM sono in grado di hackerare autonomamente siti web finti, ma possono sfruttare le vulnerabilità del mondo reale?

Dimostriamo che il GPT-4 è in grado di eseguire exploit nel mondo reale, laddove altri modelli e scanner di vulnerabilità open-source falliscono.

Carta: https://t.co/utbmMdYfmu

- Daniel Kang (@daniel_d_kang) 16 aprile 2024

L'esperimento

I ricercatori hanno creato agenti AI basati su GPT-4, GPT-3.5 e altri 8 LLM open-source.

Hanno dato agli agenti l'accesso agli strumenti, alle descrizioni CVE e all'uso del framework per agenti ReAct. Il framework ReAct colma il divario per consentire all'LLM di interagire con altri software e sistemi.

I ricercatori hanno creato un set di riferimento di 15 vulnerabilità reali di un giorno e hanno dato agli agenti l'obiettivo di tentare di sfruttarle autonomamente.

GPT-3.5 e i modelli open-source hanno tutti fallito in questi tentativi, ma GPT-4 ha sfruttato con successo 87% delle vulnerabilità di un giorno.

Dopo aver rimosso la descrizione CVE, la percentuale di successo è scesa da 87% a 7%. Ciò suggerisce che GPT-4 è in grado di sfruttare le vulnerabilità una volta che gli vengono forniti i dettagli CVE, ma non è molto bravo a identificare le vulnerabilità senza questa guida.

Implicazioni

La criminalità informatica e l'hacking richiedevano competenze particolari, ma l'intelligenza artificiale sta abbassando il livello. I ricercatori hanno dichiarato che la creazione del loro agente AI ha richiesto solo 91 righe di codice.

Con il progredire dei modelli di intelligenza artificiale, il livello di abilità richiesto per sfruttare le vulnerabilità della sicurezza informatica continuerà a diminuire. Anche il costo per scalare questi attacchi autonomi continuerà a diminuire.

Quando i ricercatori hanno calcolato i costi delle API per il loro esperimento, il loro agente GPT-4 ha sostenuto $8,80 per exploit. Secondo le loro stime, l'utilizzo di un esperto di cybersicurezza con una tariffa di $50 all'ora equivarrebbe a $25 per exploit.

Ciò significa che l'uso di un agente LLM è già 2,8 volte più economico del lavoro umano e molto più facile da scalare rispetto alla ricerca di esperti umani. Quando GPT-5 e altri LLM più potenti saranno rilasciati, queste capacità e queste differenze di costo non potranno che aumentare.

I ricercatori affermano che i loro risultati "evidenziano la necessità per la comunità della cybersicurezza in generale e per i fornitori di LLM di riflettere attentamente su come integrare gli agenti LLM nelle misure difensive e sulla loro ampia diffusione".