I ricercatori hanno pubblicato uno studio che confronta l'accuratezza e la qualità dei riassunti prodotti dai LLM. Claude 3 Opus si è comportato particolarmente bene, ma gli esseri umani sono ancora in vantaggio.

I modelli di intelligenza artificiale sono estremamente utili per riassumere documenti lunghi quando non si ha il tempo o la voglia di leggerli.

Il lusso di avere finestre di contesto crescenti ci permette di sollecitare i modelli con documenti più lunghi, il che mette a dura prova la loro capacità di ottenere sempre i fatti nel riassunto.

I ricercatori dell'Università del Massachusetts Amherst, di Adobe, dell'Allen Institute for AI e dell'Università di Princeton, ha pubblicato uno studio che ha cercato di capire quanto siano bravi i modelli di intelligenza artificiale a riassumere contenuti lunghi come un libro (>100k token).

FAVOLE

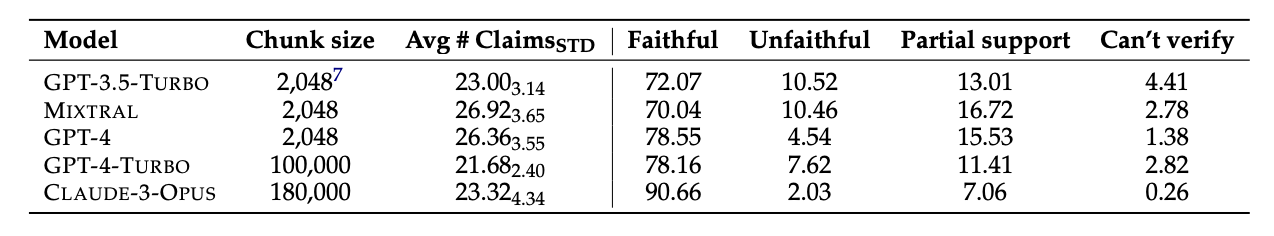

Hanno selezionato 26 libri pubblicati nel 2023 e nel 2024 e hanno fatto riassumere i testi a diversi LLM. Le date di pubblicazione recenti sono state scelte per evitare una potenziale contaminazione dei dati nei dati di addestramento originali dei modelli.

Una volta che i modelli hanno prodotto i riassunti, hanno usato il GPT-4 per estrarre da essi le affermazioni decontestualizzate. I ricercatori hanno poi assunto degli annotatori umani che avevano letto i libri e hanno chiesto loro di verificare le affermazioni.

I dati ottenuti sono stati raccolti in un set di dati chiamato "Faithfulness Annotations for Book-Length Summarization" (FABLES). FABLES contiene 3.158 annotazioni di fedeltà a livello di affermazione in 26 testi narrativi.

I risultati del test hanno dimostrato che Claude 3 Opus è "il riassunto più fedele di un libro con un margine significativo", con oltre 90% di affermazioni verificate come fedeli o accurate.

Il GPT-4 è arrivato lontano, con solo 78% delle sue affermazioni verificate come fedeli dagli annotatori umani.

La parte difficile

I modelli sottoposti al test sembravano avere difficoltà con le stesse cose. La maggior parte dei fatti sbagliati dai modelli riguardava eventi o stati di personaggi e relazioni.

Il documento osserva che "la maggior parte di queste affermazioni può essere invalidata solo attraverso un ragionamento multi-hop sulle prove, evidenziando la complessità del compito e la sua differenza rispetto alle impostazioni di verifica dei fatti esistenti".

I LLM hanno anche spesso tralasciato informazioni critiche nei loro riassunti. Inoltre, hanno enfatizzato eccessivamente i contenuti verso la fine dei libri, tralasciando quelli importanti più vicini all'inizio.

L'intelligenza artificiale sostituirà gli annotatori umani?

Gli annotatori umani o i fact-checker sono costosi. I ricercatori hanno speso $5.200 per far verificare agli annotatori umani le affermazioni contenute nei riassunti dell'IA.

Un modello di intelligenza artificiale avrebbe potuto fare il lavoro per meno? Semplice recupero dei fatti è qualcosa che Claude 3 sa fare bene, ma le sue prestazioni nella verifica di affermazioni che richiedono una comprensione più approfondita del contenuto sono meno consistenti.

Quando sono state presentate le affermazioni estratte e si è chiesto loro di verificarle, tutti i modelli di intelligenza artificiale sono stati inferiori agli annotatori umani. In particolare, si sono comportati male nell'identificare le affermazioni infedeli.

Anche se Claude 3 Opus è risultato il miglior verificatore di richieste di risarcimento con una certa distanza, i ricercatori hanno concluso che "in definitiva ha prestazioni troppo scarse per essere un auto-rating affidabile".

Quando si tratta di comprendere le sfumature, le complesse relazioni umane, i punti della trama e le motivazioni dei personaggi in una lunga narrazione, sembra che gli umani siano ancora in vantaggio per ora.