L'esercito degli Stati Uniti si sta cimentando nell'integrazione di chatbot AI nella pianificazione strategica, anche se all'interno di una simulazione di gioco di guerra basata sul popolare videogioco Starcraft II.

Questo studio, guidato dal Laboratorio di Ricerca dell'Esercito degli Stati Uniti, analizza le strategie di campo di battaglia GPT-4 Turbo e GPT-4 Vision di OpenAI.

Questo fa parte del progetto OpenAI collaborazione con il Dipartimento della Difesa (DOD) a seguito dell'istituzione del task force sull'IA generativa l'anno scorso.

L'uso dell'IA sul campo di battaglia è dibattiti accesi, con un recente studio analogo sul wargaming con l'intelligenza artificiale che i LLM come il GPT-3.5 e il GPT-4 tendono a inasprire le tattiche diplomatiche, talvolta sfociando in una guerra nucleare.

Questa nuova ricerca dell'esercito americano ha utilizzato Starcraft II per simulare uno scenario di battaglia che coinvolge un numero limitato di unità militari.

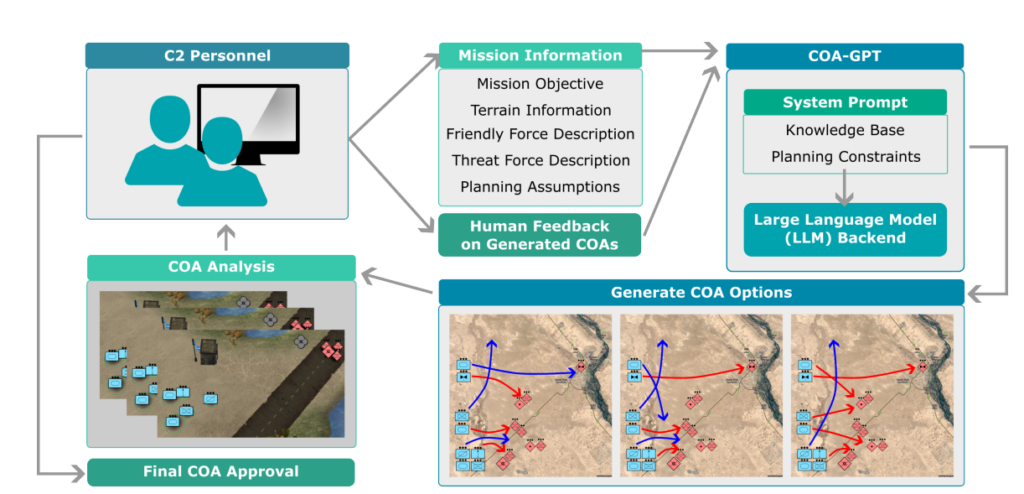

I ricercatori hanno soprannominato questo sistema "COA-GPT", dove COA sta per il termine militare "Corsi d'azione", che descrive essenzialmente le tattiche militari.

Il COA-GPT ha assunto il ruolo di assistente del comandante militare, con il compito di elaborare strategie per annientare le forze nemiche e catturare i punti strategici.

I ricercatori osservano che la COA tradizionale è notoriamente lenta e richiede molto lavoro. Il COA-GPT prende decisioni in pochi secondi, integrando il feedback umano nel processo di apprendimento dell'IA.

Il COA-GPT eccelle sugli altri metodi, ma ha un costo

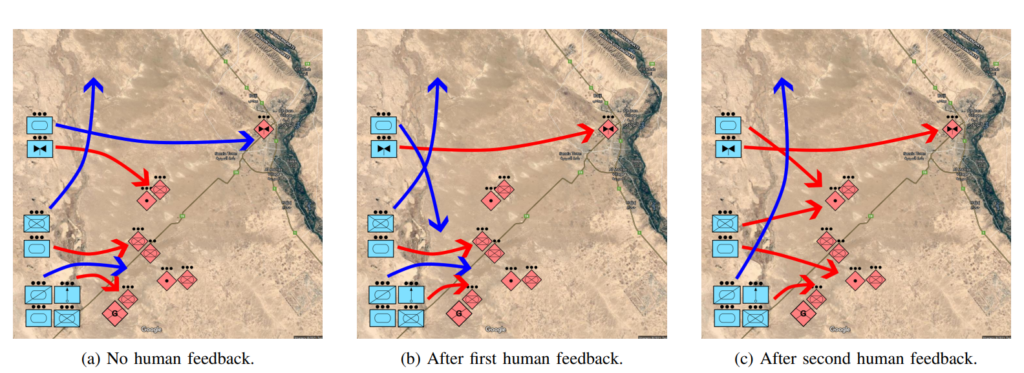

Il COA-GPT ha dimostrato prestazioni superiori ai metodi esistenti, superandoli nella generazione di COA strategiche, e in grado di adattarsi al feedback in tempo reale.

Tuttavia, c'erano dei difetti. In particolare, il COA-GPT ha subito un numero maggiore di perdite nel raggiungimento degli obiettivi della missione.

Lo studio afferma: "Osserviamo che il COA-GPT e il COA-GPT-V, anche se potenziati con il feedback umano, mostrano un numero maggiore di vittime delle forze amiche rispetto ad altre linee di base".

Questo scoraggia i ricercatori? Apparentemente no.

Lo studio afferma: "In conclusione, il COA-GPT rappresenta un approccio trasformativo nelle operazioni C2 militari, che facilita un processo decisionale più rapido e agile e mantiene un vantaggio strategico nella guerra moderna".

È preoccupante che un sistema di intelligenza artificiale che ha causato un numero maggiore di vittime inutili rispetto alla linea di base sia definito come un "approccio trasformativo".

Il Dipartimento della Difesa ha già individuato altre strade per esplorare gli usi militari dell'IA, ma le preoccupazioni sulla disponibilità della tecnologia e sulle implicazioni etiche incombono.

Ad esempio, chi è responsabile quando i militari Le applicazioni dell'intelligenza artificiale vanno male? Gli sviluppatori? Il responsabile? O qualcuno più in basso nella catena?

I sistemi di guerra con intelligenza artificiale sono già stati impiegati nei conflitti in Ucraina e in Palestina-Israele, ma queste questioni rimangono in gran parte non testate.

Speriamo che rimanga così.