IBM Security ha pubblicato una ricerca sul suo blog Security Intelligence per mostrare come i cloni vocali dell'intelligenza artificiale possano essere iniettati in una conversazione dal vivo senza che i partecipanti se ne rendano conto.

Con il miglioramento della tecnologia di clonazione vocale, abbiamo visto che false chiamate rapide fingendo di essere Joe Biden e telefonate truffa fingendo di essere un familiare in difficoltà che chiede denaro.

L'audio di queste chiamate sembra buono, ma la truffa è spesso facilmente sventabile ponendo alcune domande personali per identificare il chiamante come impostore.

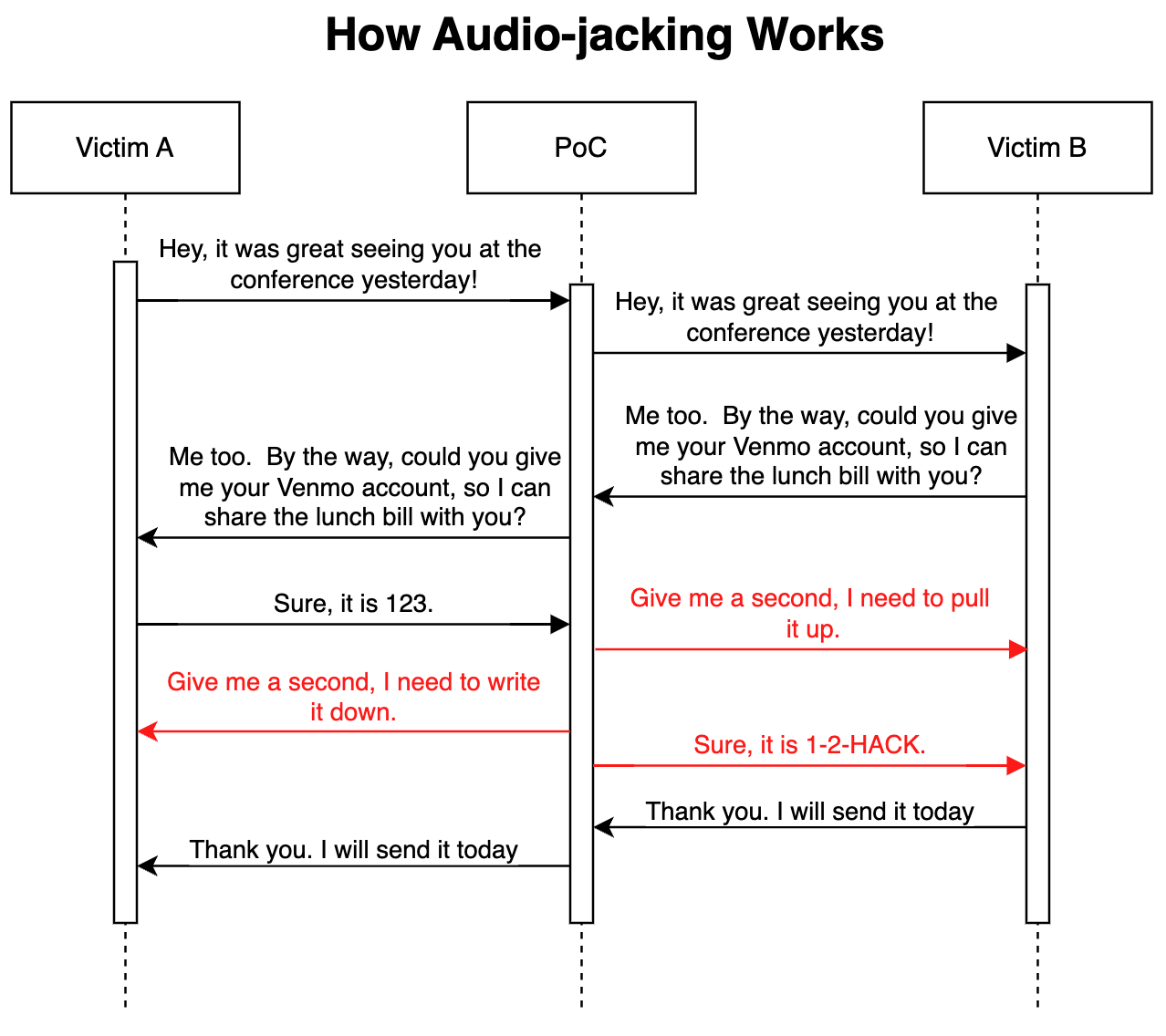

Nel loro attacco avanzato di proof of concept, i Ricercatori di sicurezza IBM ha dimostrato che un LLM abbinato alla clonazione vocale può agire come un man-in-the-middle per dirottare solo una parte cruciale di una conversazione, piuttosto che l'intera chiamata.

Come funziona

L'attacco potrebbe essere sferrato tramite malware installato sui telefoni delle vittime o tramite un servizio Voice over IP (VoIP) compromesso. Una volta installato, il programma monitora la conversazione e ha bisogno di soli 3 secondi di audio per poter clonare entrambe le voci.

Un generatore speech-to-text consente all'LLM di monitorare la conversazione per comprendere il contesto della discussione. Il programma è stato istruito a trasmettere l'audio della conversazione così com'è, ma a modificare l'audio della chiamata ogni volta che una persona richiede i dettagli del conto bancario.

Quando la persona risponde di fornire le proprie coordinate bancarie, il clone vocale modifica l'audio per fornire invece le coordinate bancarie del truffatore. La latenza dell'audio durante la modifica viene coperta con un discorso di riempimento.

Ecco un'illustrazione di come funziona l'attacco proof of concept (PoC).

Poiché l'LLM trasmette l'audio non modificato per la maggior parte della chiamata, è davvero difficile sapere se la minaccia è in gioco.

Secondo i ricercatori, lo stesso attacco "potrebbe anche modificare informazioni mediche, come il gruppo sanguigno e le allergie nelle conversazioni; potrebbe ordinare a un analista di vendere o comprare un'azione; potrebbe ordinare a un pilota di cambiare rotta".

I ricercatori hanno dichiarato che "costruire questo PoC è stato sorprendentemente e spaventosamente facile". Man mano che l'intonazione e l'emozione dei cloni vocali migliorano e che un hardware migliore riduce la latenza, questo tipo di attacco sarebbe davvero difficile da rilevare o prevenire.

Estendendo il concetto oltre il dirottamento di una conversazione audio, i ricercatori hanno affermato che "con i modelli esistenti che possono convertire il testo in video, è teoricamente possibile intercettare un video in live-streaming, come le notizie in TV, e sostituire il contenuto originale con uno manipolato".

Potrebbe essere più sicuro credere ai propri occhi e alle proprie orecchie solo quando si è fisicamente in presenza dell'interlocutore.