Lo screening dei pazienti per trovare i partecipanti adatti agli studi clinici è un'attività ad alta intensità di lavoro, costosa e soggetta a errori, ma l'intelligenza artificiale potrebbe presto risolvere il problema.

Un team di ricercatori del Brigham and Women's Hospital, della Harvard Medical School e del Mass General Brigham Personalized Medicine ha condotto uno studio per verificare se un modello di intelligenza artificiale potesse elaborare le cartelle cliniche per trovare candidati idonei alla sperimentazione clinica.

Hanno utilizzato GPT-4V, il LLM di OpenAI con elaborazione delle immagini, abilitato dalla Retrieval-Augmented Generation (RAG) per elaborare le cartelle cliniche elettroniche (EHR) e le note cliniche dei potenziali candidati.

I LLM sono preaddestrati a un set di dati fisso e possono rispondere solo a domande basate su tali dati. La RAG è una tecnica che consente a un LLM di recuperare dati da fonti esterne, come Internet o i documenti interni di un'organizzazione.

Quando si selezionano i partecipanti a uno studio clinico, la loro idoneità è determinata da un elenco di criteri di inclusione ed esclusione. Di solito, il personale addestrato passa al setaccio le cartelle cliniche elettroniche di centinaia o migliaia di pazienti per trovare quelli che corrispondono ai criteri.

I ricercatori hanno raccolto i dati di uno studio che mirava a reclutare pazienti con insufficienza cardiaca sintomatica. Hanno utilizzato questi dati per verificare se il GPT-4V con RAG potesse svolgere il lavoro in modo più efficiente rispetto al personale dello studio, pur mantenendo l'accuratezza.

I dati strutturati presenti nelle cartelle cliniche dei potenziali candidati potrebbero essere utilizzati per determinare 5 criteri di inclusione su 6 e 5 criteri di esclusione su 17 per lo studio clinico. Questa è la parte più semplice.

I restanti 13 criteri dovevano essere determinati interrogando i dati non strutturati delle note cliniche di ciascun paziente, la parte più laboriosa che i ricercatori speravano potesse essere svolta dall'intelligenza artificiale.

🔍Can @Microsoft @Azure @OpenAI's #GPT4 di un essere umano per lo screening delle sperimentazioni cliniche? Ci siamo posti questa domanda nel nostro studio più recente e sono estremamente entusiasta di condividere i nostri risultati in preprint:https://t.co/lhOPKCcudP

L'integrazione della GPT4 negli studi clinici non è...- Ozan Unlu (@OzanUnluMD) 9 febbraio 2024

Risultati

I ricercatori hanno innanzitutto ottenuto le valutazioni strutturate completate dal personale dello studio e le note cliniche degli ultimi due anni.

Hanno sviluppato un flusso di lavoro per un sistema di risposta alle domande basato sulle note cliniche e alimentato dall'architettura RAG e dal GPT-4V e lo hanno chiamato RECTIFIER (RAG-Enabled Clinical Trial Infrastructure for Inclusion Exclusion Review).

Le note di 100 pazienti sono state utilizzate come set di dati di sviluppo, 282 pazienti come set di dati di validazione e 1894 pazienti come set di test.

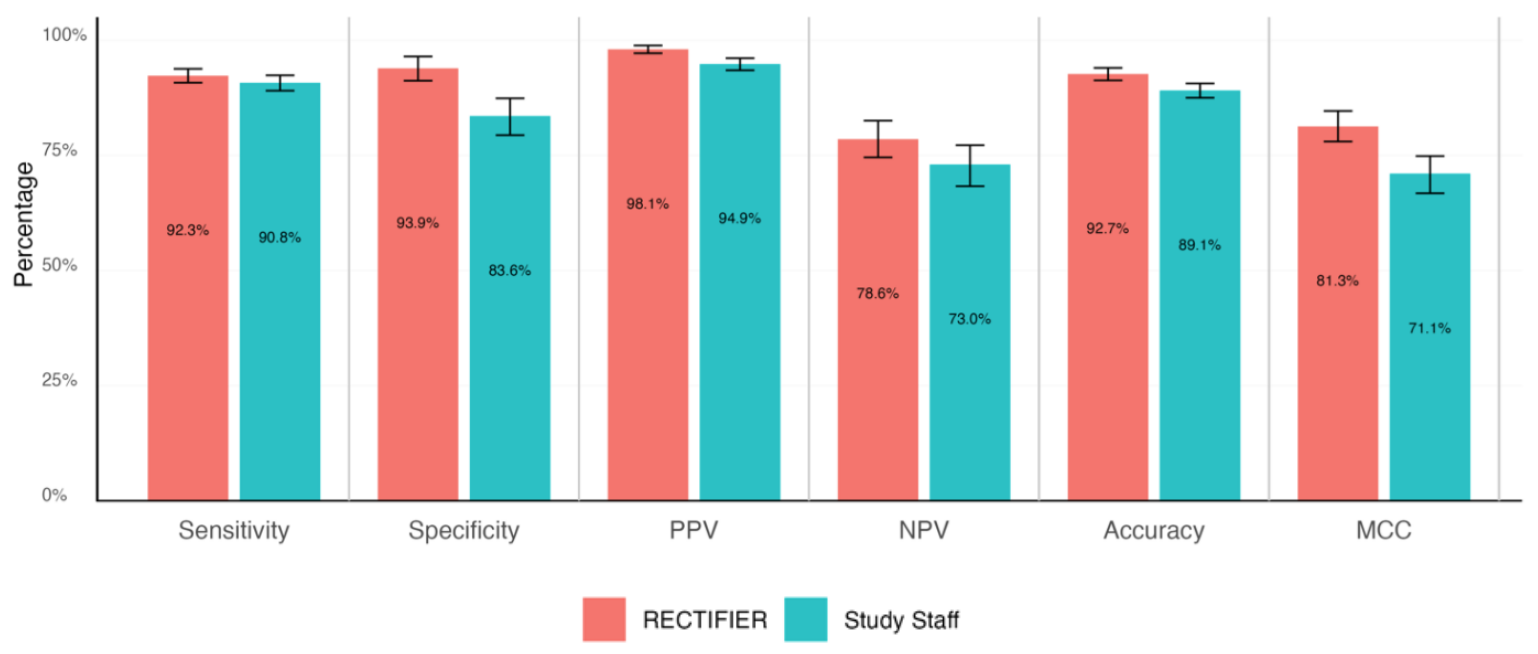

Un medico esperto ha completato una revisione in cieco delle cartelle cliniche dei pazienti per rispondere alle domande di idoneità e determinare le risposte "gold standard". Queste sono state poi confrontate con le risposte del personale dello studio e di RECTIFIER in base ai seguenti criteri:

- Sensibilità - La capacità di un test di identificare correttamente i pazienti eleggibili allo studio (veri positivi).

- Specificità - La capacità di un test di identificare correttamente i pazienti non eleggibili allo studio (veri negativi).

- Accuratezza - La percentuale complessiva di classificazioni corrette (sia i veri positivi che i veri negativi).

- Coefficiente di correlazione di Matthews (MCC) - Una metrica utilizzata per misurare la capacità del modello di selezionare o escludere una persona. Un valore pari a 0 equivale al lancio di una moneta, mentre un valore pari a 1 rappresenta l'azzeccamento del 100% delle volte.

RECTIFIER ha ottenuto risultati altrettanto buoni, e in alcuni casi migliori, rispetto al personale dello studio. Il risultato più significativo dello studio è stato probabilmente il confronto dei costi.

Sebbene non sia stata fornita alcuna cifra per la remunerazione del personale dello studio, essa deve essere stata notevolmente superiore al costo dell'uso del GPT-4V, che variava tra $0,02 e $0,10 per paziente. L'utilizzo dell'intelligenza artificiale per valutare un pool di 1.000 potenziali candidati richiederebbe pochi minuti e costerebbe circa $100.

I ricercatori hanno concluso che l'utilizzo di un modello di intelligenza artificiale come il GPT-4V con il RAG può mantenere o migliorare l'accuratezza nell'identificazione dei candidati agli studi clinici, e farlo in modo più efficiente e molto più economico rispetto all'impiego di personale umano.

I ricercatori hanno sottolineato la necessità di essere cauti nell'affidare l'assistenza medica a sistemi automatizzati, ma sembra che l'IA possa fare un lavoro migliore di quello che possiamo fare noi, se adeguatamente indirizzata.