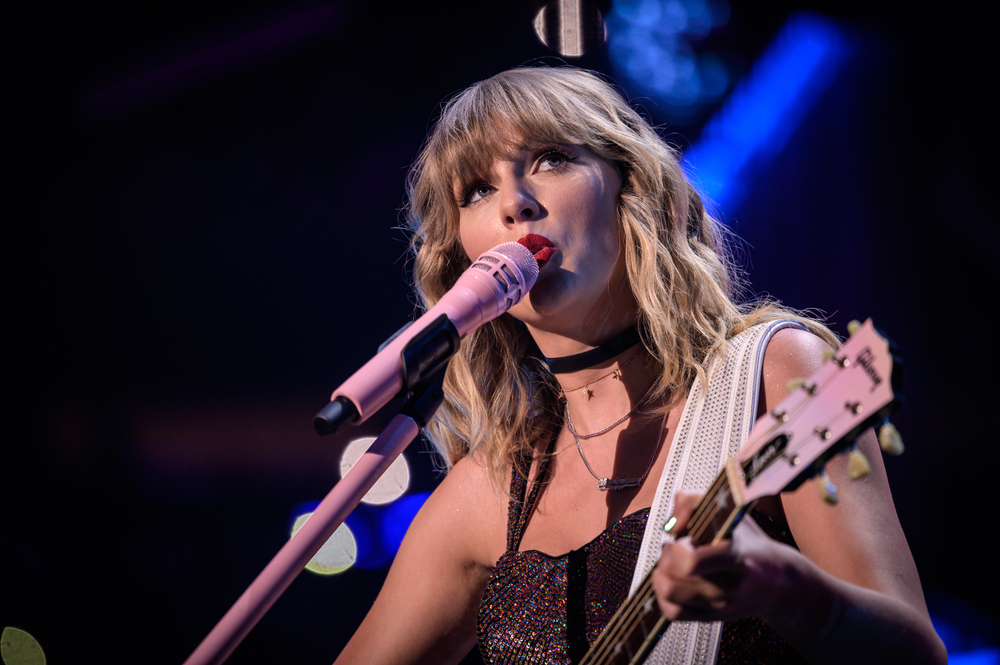

Immagini esplicite della popstar Taylor Swift, generate dall'intelligenza artificiale, sono state recentemente diffuse sui social media, scatenando un'ondata di polemiche.

Nonostante le rigide regole contro tali contenuti, queste immagini non consensuali ritraevano la Swift in posizioni sessualmente esplicite e sono rimaste attive per 19 ore, accumulando oltre 27 milioni di visualizzazioni e 260.000 like prima che l'account di pubblicazione venisse sospeso.

L'incidente contribuisce ad alimentare una serie di interrogativi sull'efficacia delle politiche sui social media nei confronti di disinformazione falsa e profonda.

Si può fermare? Apparentemente no. Allora come possiamo combatterlo? I servizi di rilevamento dell'intelligenza artificiale (simili ai fact checker) e le "note della comunità", allegate ai post su X, sono due possibili soluzioni, ma entrambe hanno i loro difetti.

Le immagini esplicite di Taylor Swift sono state diffuse principalmente sulla piattaforma di social media X ma hanno trovato spazio anche su altre piattaforme di social media, tra cui Facebook, dimostrando come i contenuti controversi dell'IA si diffondano a macchia d'olio.

Un portavoce di Meta ha risposto all'incidente, dichiarando: "Questo contenuto viola le nostre politiche e lo stiamo rimuovendo dalle nostre piattaforme e prendendo provvedimenti contro gli account che lo hanno pubblicato. Stiamo continuando a monitorare e se identificheremo altri contenuti in violazione li rimuoveremo e prenderemo provvedimenti adeguati".

Milioni di utenti si sono riversati su Reddit per discutere le ramificazioni e gli impatti di questo e di altri recenti incidenti virali di deep fake, tra cui una foto della Torre Eiffel in fiamme.

Sta girando un video su TikTok, visto milioni di volte, che sostiene che la Torre Eiffel sia in fiamme. La Torre Eiffel non è in fiamme. pic.twitter.com/IxlsKOqOsI

- Alistair Coleman (@alistaircoleman) 22 gennaio 2024

Sebbene molti percepiscano queste immagini come palesemente false, non possiamo dare per scontata la consapevolezza del grande pubblico.

Un commentatore su Reddit ha commentato l'incidente di Taylor Swift: "Ora so quante persone non sanno cosa sono i deepfakes", sottintendendo una scarsa consapevolezza del problema.

Gli esperti del settore hanno discusso il problema con l'ex dirigente di Stabilità Ed Newton-Rex, sostenendo che l'atteggiamento aggressivo delle aziende tecnologiche e lo scarso coinvolgimento dei decisori contribuiscono al problema.

I deepfake espliciti e non consensuali dell'IA sono il risultato di tutta una serie di mancanze.

- La cultura dell'IA generativa "da spedire il più velocemente possibile", a prescindere dalle conseguenze.

- Ignoranza intenzionale all'interno delle aziende di IA in merito all'utilizzo dei loro modelli

- Un totale disprezzo per la fiducia e...- Ed Newton-Rex (@ednewtonrex) 26 gennaio 2024

Ben Decker di Memetica, un'agenzia di investigazioni digitali, ha commentato la mancanza di controllo sull'impatto dell'IA: "Questo è un esempio lampante dei modi in cui l'IA viene scatenata per molte ragioni nefaste senza che vi siano sufficienti guardrail per proteggere la pubblica piazza".

Ha inoltre evidenziato le carenze delle strategie di monitoraggio dei contenuti delle aziende di social media.

Secondo quanto riportato, Taylor Swift starebbe valutando la possibilità di intraprendere un'azione legale contro il sito di falsi porno che ospita le immagini.

Ci sono stati numerosi episodi simili di falsi espliciti in profondità, che hanno coinvolto soprattutto donne e bambini, a volte con il intento di corrompere le persone, chiamato anche "sexploitation".

Le immagini AI di abusi sessuali su minori sono l'impatto più oscuro e preoccupante della tecnologia di generazione di immagini. Un uomo statunitense è stato recentemente condannato a 40 anni in carcere per il possesso di tali immagini.

Sulla scia di questo e di altri incidenti simili, sono aumentate le richieste di una legislazione che affronti questa forma di abuso dell'IA.

Il rappresentante degli Stati Uniti Joe Morelle ha definito "spaventosa" la diffusione dei deepfakes della Swift, invocando un'azione legale urgente. Ha osservato: "Quello che è successo a Taylor Swift non è una novità", sottolineando l'impatto sproporzionato di tali contenuti sulle donne.

La disinformazione "deep fake" è stata ampiamente discussa anche a il Forum economico mondiale di Davos con l'aumento timori sulla possibilità che i contenuti manipolati possano influenzare i mercati azionari, le elezioni e l'opinione pubblica.

Gli sforzi per combattere i falsi profondi sono in corso, con startup e giganti tecnologici che sviluppano tecnologie di rilevamento.

Intel, ad esempio, ha lanciato un prodotto in grado di rilevare i video falsi con una precisione di 96%.

Tuttavia, per il momento la sfida rimane in gran parte insormontabile, dato che la tecnologia si sta rapidamente evolvendo e diffondendo su Internet.