Mistral AI è una startup francese che sta conquistando le prime pagine dei giornali con i suoi modelli open-source leggeri. Insieme all'attenzione è arrivata una nuova tranche di finanziamenti: questa settimana si è assicurata investimenti per 385 milioni di euro, pari a $414 milioni di euro.

Il secondo round di finanziamento dell'azienda è stato guidato dalle società di venture capital Andreessen Horowitz e Lightspeed Venture Partners.

La discussione sui modelli open-source rispetto a quelli proprietari è in corso e Mistral AI è decisamente dalla parte dell'open-source.

Aziende come OpenAI sono state criticati per la loro paura sulla sicurezza dei modelli open-source e molti sostengono che si tratti di un caso di Big Tech che cerca di mantenere la propria egemonia.

Mistral AI afferma che, formando i propri modelli, "rilasciandoli apertamente e promuovendo i contributi della comunità, possiamo costruire un'alternativa credibile all'emergente oligopolio dell'IA. I modelli generativi a peso aperto giocheranno un ruolo fondamentale nell'imminente rivoluzione dell'IA".

Diversi grandi investitori hanno confermato la loro fiducia in questa strategia. Il finanziamento che Mistral AI si è assicurata questa settimana fa sì che la società sia valutata $2 miliardi. Si tratta di un aumento di 7 volte della valutazione nei sei mesi successivi al lancio dell'azienda.

Mixtral 8x7B

A settembre è stato rilasciato Mistral 7B, il piccolo ma potente LLM di Mistral AI che ha battuto o eguagliato i modelli open-source più grandi come Lama di Meta 2 34B.

I modelli proprietari GPT di OpenAI sono giustamente considerati il gold standard per il confronto delle prestazioni dei modelli. Con il nuovo modello di Mistral AI, Mixtral 8x7BL'azienda si è assicurata un significativo diritto di vanto a questo proposito.

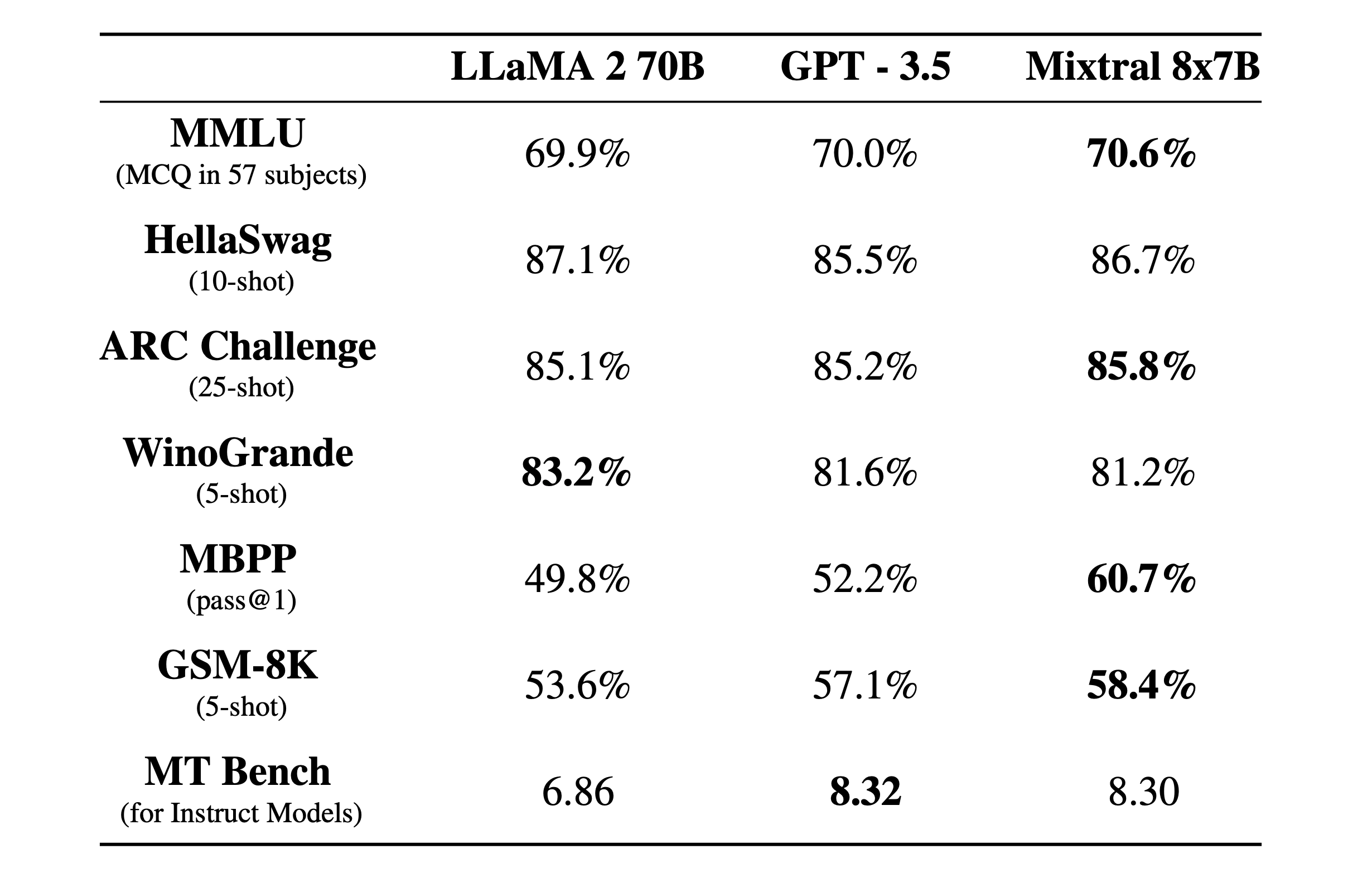

Mixtral 8x7B è un Miscela rada di esperti con una finestra di contesto di 32k. Ecco come si è comportata nei test di benchmark rispetto a Llama 2 e GPT-3.5.

I test di benchmark sono un buon modo per farsi un'idea della capacità di un modello di svolgere diverse funzioni. I test di cui sopra sono stati:

- MMLU (MCQ in 57 materie): Sta per Domande a scelta multipla in 57 materie.

- HellaSwag (10 colpi): Valuta la capacità dell'IA di prevedere la fine di uno scenario dopo aver ricevuto 10 esempi.

- ARC Challenge (25 colpi): Mette alla prova la comprensione di concetti e ragionamenti scientifici da parte dell'IA, dopo averle fornito 25 esempi da cui imparare prima di essere messa alla prova.

- WinoGrande (5 colpi): Prova il ragionamento di buon senso basato sulla risoluzione di ambiguità nelle frasi, con 5 esempi da cui l'intelligenza artificiale può imparare.

- MBPP (pass@1): Verifica la capacità di un modello di intelligenza artificiale di generare snippet di codice Python corretti. La metrica pass@1 misura la percentuale di problemi in cui il primo completamento del modello è stato corretto.

- GSM-8K (5 colpi): Il benchmark Grade School Math 8K verifica la capacità di un'intelligenza artificiale di risolvere problemi di matematica al livello previsto per la scuola elementare, dopo che le sono stati forniti 5 esempi.

- MT Bench (per modelli istruttivi): Machine Translation Benchmark for Instruct Models misura la capacità di un'intelligenza artificiale di seguire le istruzioni nel contesto dei compiti di traduzione.

Ciò che è ancora più impressionante dei risultati dei test di benchmark è quanto Mixtral 8x7B sia piccolo ed efficiente. Questo modello potrebbe essere eseguito localmente su un laptop decente con circa 32 GB di RAM.

Con molti più soldi a disposizione, possiamo aspettarci sviluppi interessanti da Mistral AI.