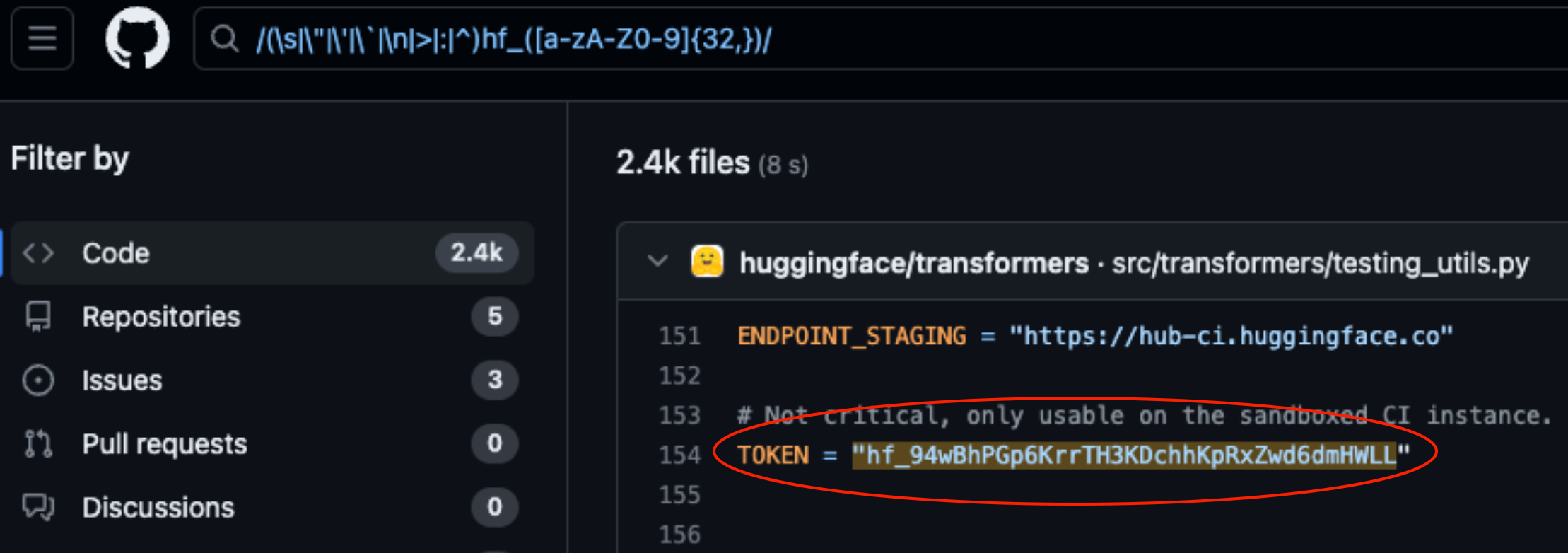

Lasso Security ha esposto le vulnerabilità di sicurezza su HuggingFace e GitHub dopo aver trovato 1681 token API esposti e codificati nel codice memorizzato sulle piattaforme.

HuggingFace e GitHub sono due dei repository più diffusi in cui gli sviluppatori possono fornire l'accesso ai loro modelli di intelligenza artificiale e al codice. Considerateli come cartelle nel cloud gestite dalle organizzazioni che li possiedono.

HuggingFace e GitHub consentono agli utenti di interagire facilmente con centinaia di migliaia di modelli di intelligenza artificiale e set di dati tramite API. Inoltre, le organizzazioni che possiedono i modelli e i set di dati possono utilizzare l'accesso alle API per leggere, creare, modificare ed eliminare repository o file.

Le autorizzazioni associate al token API determinano il livello di accesso dell'utente. Lazo trovato che, scavando un po', sono riusciti a trovare molti token nel codice memorizzato nei repository delle piattaforme.

Dei 1681 token validi trovati, 655 token di utenti avevano i permessi di scrittura, 77 dei quali avevano i permessi completi per l'account.

Perché è un problema?

Pensate a un token API come a una chiave della porta di casa. Può essere comodo lasciare la chiave sotto lo zerbino, ma se qualcuno la trova può accedere alla vostra casa.

Quando gli sviluppatori scrivono un pezzo di codice che deve interagire con il loro modello di intelligenza artificiale o con il set di dati, a volte diventano un po' pigri. Possono codificare i token nel codice invece di utilizzare metodi più sicuri per gestirli.

Alcuni dei token trovati da Lasso davano loro i permessi di lettura e scrittura completi di Meta Lama 2, BigScience Workshop e EleutherAI. Tutte queste organizzazioni hanno modelli di IA che sono stati scaricati milioni di volte.

Se i cattivi fossero stati Lasso, avrebbero potuto modificare i modelli o i set di dati nei repository esposti. Immaginatevi se qualcuno avesse aggiunto del codice subdolo nel repository di Meta e poi lo avesse fatto scaricare a milioni di persone.

Quando Meta, Google, Microsoft e altri hanno saputo dei token API esposti, li hanno rapidamente revocati.

Il furto di modelli, l'avvelenamento dei dati di addestramento e la combinazione di set di dati di terze parti e modelli pre-addestrati sono tutti grandi rischi per le aziende di IA. Gli sviluppatori che lasciano casualmente i token API esposti nel codice non fanno altro che facilitare lo sfruttamento di questi rischi da parte di malintenzionati.

C'è da chiedersi se gli ingegneri di Lasso siano stati i primi a trovare queste vulnerabilità.

Se criminali informatici avrebbero sicuramente mantenuto il massimo silenzio mentre aprivano la porta d'ingresso.