I modelli linguistici multimodali di grandi dimensioni (MLLM) come il GPT-4V sono molto bravi ad analizzare e descrivere le immagini, ma a volte hanno delle allucinazioni e sbagliano. Un nuovo approccio chiamato Woodpecker potrebbe risolvere il problema.

Se si chiede a un MLLM di descrivere una foto, di solito è in grado di individuare gli oggetti e di descrivere accuratamente la scena. Tuttavia, come nel caso delle risposte alle richieste di testo, il modello a volte fa delle ipotesi basate su elementi o concetti che compaiono spesso insieme.

Di conseguenza, un MLLM potrebbe descrivere una foto di una vetrina e dire che ci sono persone nella scena, quando in realtà non ce ne sono.

La correzione delle allucinazioni nei LLM basati sul testo è in corso, ma diventa molto più semplice quando il modello è collegato a Internet. Il LLM è in grado di generare una risposta testuale a una richiesta, di verificarne la veridicità sulla base di dati Internet pertinenti e di autocorreggersi, se necessario.

Gli scienziati dello YouTu Lab di Tencent e dell'Università di Scienza e Tecnologia della Cina hanno adottato questo approccio e lo hanno tradotto in una soluzione visiva chiamata Woodpecker.

In parole povere, Woodpecker costruisce un corpo di conoscenze a partire dall'immagine e poi un LLM può usarlo come riferimento per correggere la descrizione iniziale generata dal MLLM.

Ecco una breve descrizione del funzionamento:

- Un LLM come GPT-3.5 Turbo analizza la descrizione generata dal MLLM ed estrae concetti chiave come oggetti, quantità e attributi. Ad esempio, nella frase "L'uomo indossa un cappello nero", vengono estratti gli oggetti "uomo" e "cappello".

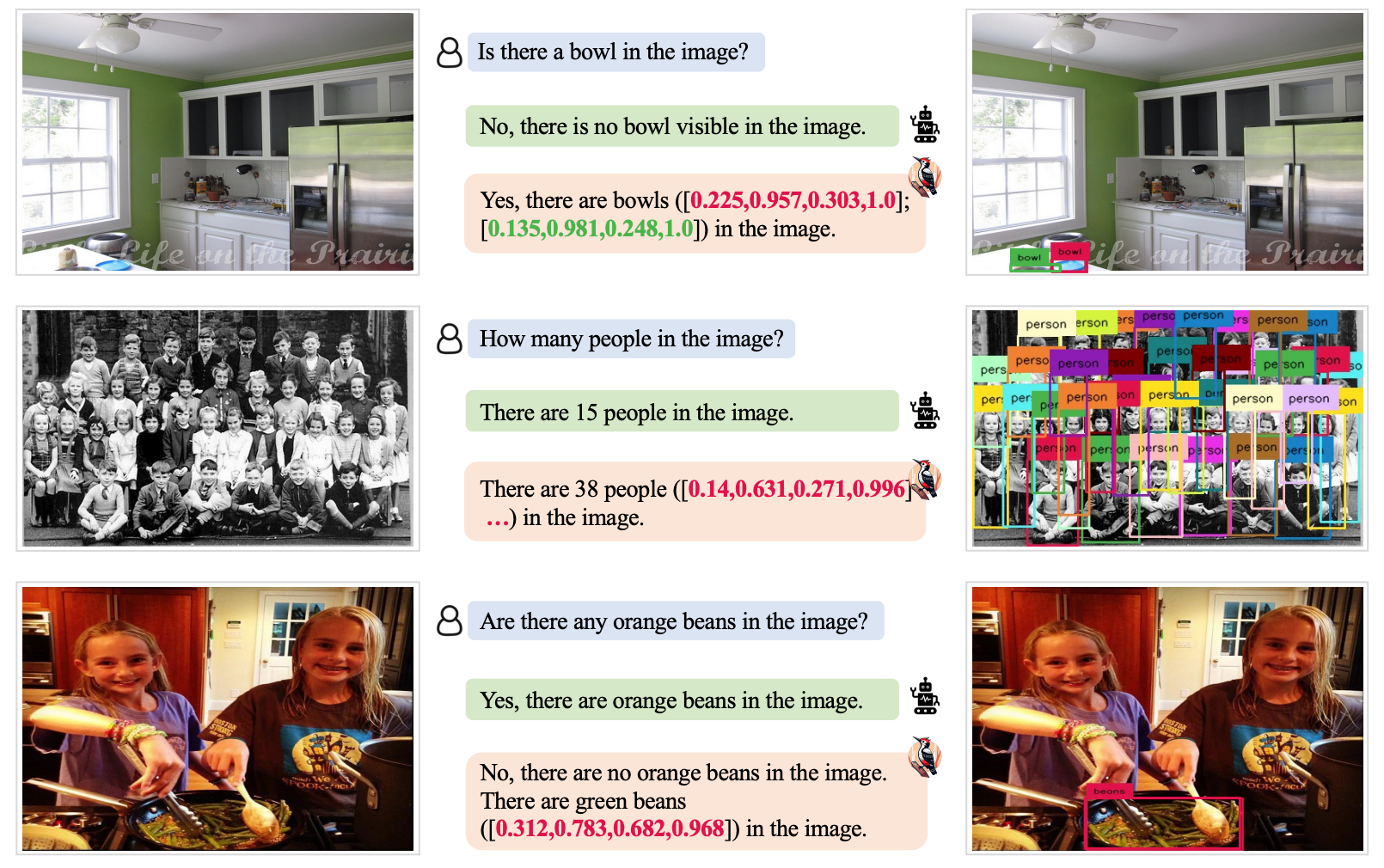

- Un LLM viene quindi invitato a generare domande relative a questi concetti, come "C'è un uomo nell'immagine?" o "Cosa indossa l'uomo?".

- Queste domande vengono inviate come prompt a un modello di Visual Question Answering (VQA). Grounding DINO esegue il rilevamento e il conteggio degli oggetti, mentre BLIP-2-FlanT5 VQA risponde alle domande relative agli attributi dopo aver analizzato l'immagine.

- Un LLM combina le risposte alle domande in una base di conoscenza visiva dell'immagine.

- Un LLM utilizza questo corpus di conoscenze di riferimento per correggere eventuali allucinazioni nella descrizione del MLLM originale e aggiungere dettagli che gli sono sfuggiti.

I ricercatori hanno chiamato il loro approccio Picchio in riferimento al modo in cui l'uccello raccoglie gli insetti dagli alberi.

I risultati dei test hanno mostrato che Woodpecker ha ottenuto un miglioramento dell'accuratezza di 30,66% per MiniGPT4 e di 24,33% per i modelli mPLUG-Owl.

La natura generica dei modelli richiesti in questo approccio significa che l'approccio Woodpecker potrebbe essere facilmente integrato in vari MLLM.

Se OpenAI integrerà Woodpecker in ChatGPT, potremmo assistere a un netto miglioramento delle già notevoli prestazioni visive. Una riduzione dell'allucinazione MLLM potrebbe anche migliorare il processo decisionale automatizzato dei sistemi che utilizzano descrizioni visive come input.