I ricercatori dell'Università di Chicago hanno sviluppato un nuovo strumento per "avvelenare" i modelli di IA quando le aziende di IA includono immagini nei loro set di dati senza consenso.

Aziende come OpenAI e Meta hanno dovuto affrontare critiche e cause legali per il fatto di aver raschiato in massa i contenuti online per addestrare i loro modelli. Per essere efficaci, i generatori di testo-immagine come DALL-E o Midjourney devono essere addestrati su grandi quantità di dati visivi.

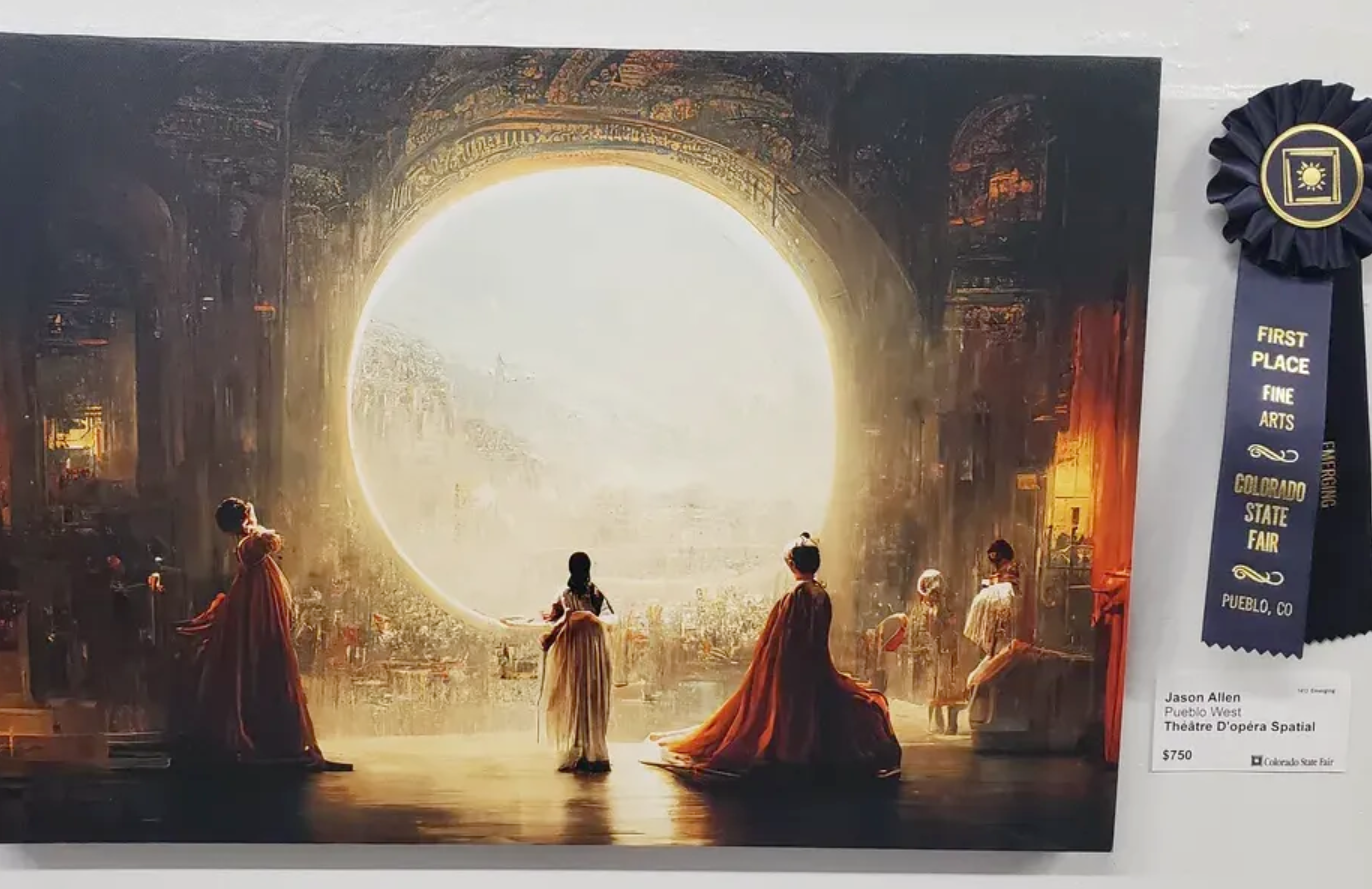

Un certo numero di artisti si sono lamentati del fatto che questi generatori di immagini sono ora in grado di produrre immagini nel loro stile dopo aver fatto uno scraping della loro arte senza consenso.

Il i ricercatori hanno creato Nightshade, uno strumento che incorpora pixel invisibili in un'immagine e che successivamente la rende "velenosa" per i modelli di intelligenza artificiale.

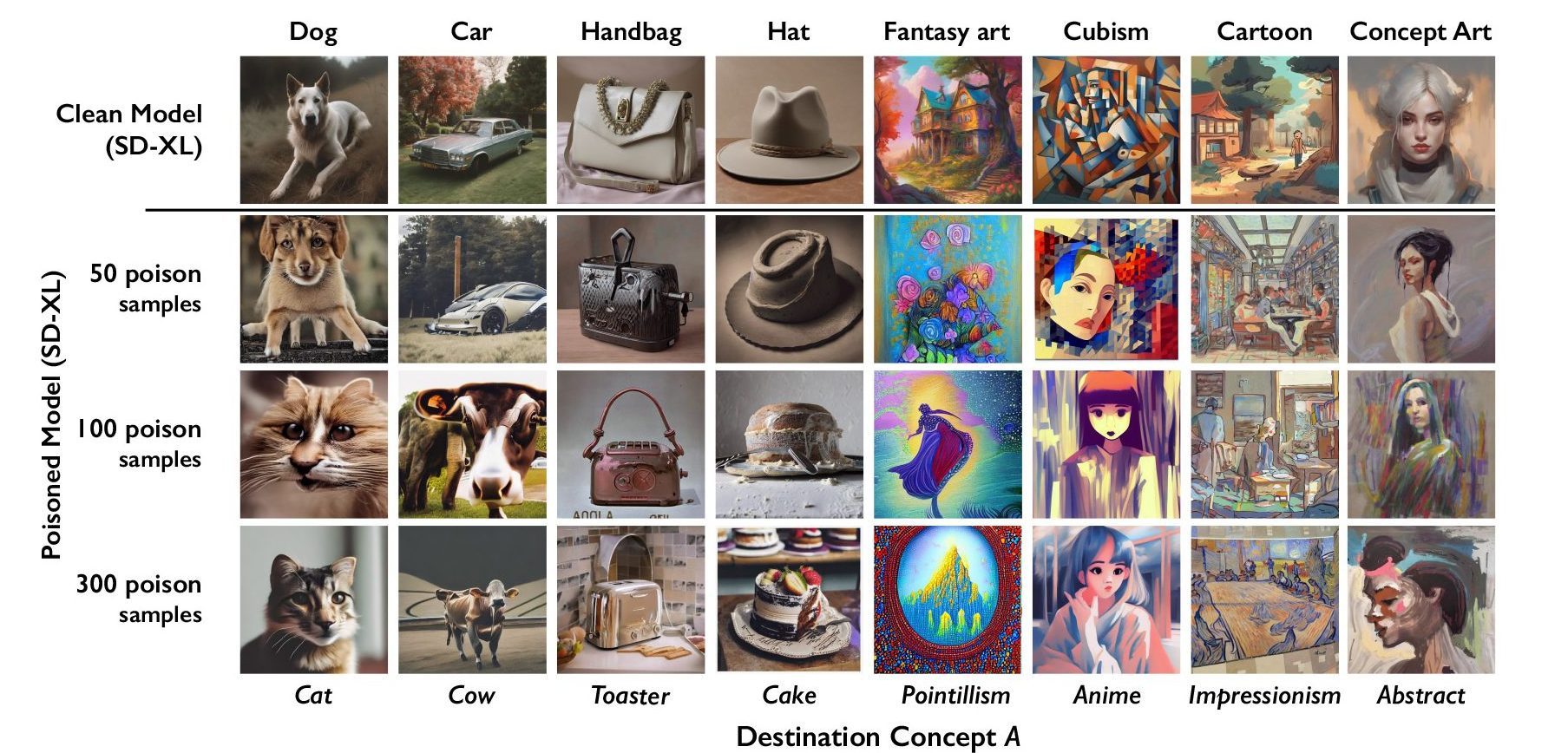

L'intelligenza artificiale generativa si basa su dati correttamente etichettati. Se un modello di IA viene addestrato su migliaia di immagini di gatti e le immagini sono tutte etichettate come "gatto", allora sa come dovrebbe essere un gatto quando gli si chiede di generare un'immagine di un gatto.

Nightshade inserisce nell'immagine dei dati che ne alterano la classificazione. Per esempio, l'immagine di un castello avvelenato da Nightshade verrebbe classificata come un vecchio camion. I ricercatori hanno scoperto che l'utilizzo di appena 100 immagini mirate a un singolo prompt era efficace per corrompere un modello.

Nightshade è una cattiva notizia per i generatori di immagini AI

Un modello affetto da dati avvelenati potrebbe essere indotto a pensare che le immagini di torte siano cappelli o che i tostapane siano borse. Oltre a corrompere la parola specifica presa di mira da Nightshade, la corruzione infetta anche concetti più ampi. Quindi, la corruzione dell'etichetta "cane" si estenderebbe anche a termini come "cucciolo".

Se un numero sufficiente di artisti iniziasse a usare Nightshade, le aziende potrebbero essere molto più attente a ottenere il consenso prima di acquisire le immagini.

Il team di ricerca incorporerà Nightshade nello strumento Glaze, anch'esso sviluppato. Glaze etichetta erroneamente lo stile di un'immagine. Ad esempio, un artista che vuole proteggere lo stile della sua opera può usare Glaze per etichettarla come "impressionista" quando in realtà è "pop art".

Il fatto che strumenti come Nightshade funzionino in modo così efficace mette in evidenza una vulnerabilità nei generatori di testo-immagine che potrebbero essere sfruttati da soggetti malintenzionati.

Aziende come OpenAI e Stability AI affermano che rispetteranno le norme di legge. opt-out per il "do not scrape che i siti web possono aggiungere ai loro file robots.txt. Se le immagini avvelenate da Nightshade non vengono raschiate, i modelli non ne risentono.

Tuttavia, i malintenzionati potrebbero avvelenare una grande quantità di immagini e renderle disponibili per lo scraping con l'intento di danneggiare i modelli di intelligenza artificiale. L'unico modo per ovviare a questo problema è quello di migliorare i rilevatori di etichette o di recensione umana.

Nightshade farà sentire gli artisti un po' più sicuri nel mettere online i loro contenuti, ma potrebbe causare seri problemi ai generatori di immagini AI.