Il modo esatto in cui il nostro cervello elabora e formula il linguaggio è ancora in gran parte un mistero. I ricercatori di Meta AI hanno trovato un nuovo modo per misurare le onde cerebrali e decodificare le parole ad esse associate.

Per le persone con capacità motorie fortemente limitate, come i malati di SLA, è particolarmente difficile comunicare. È difficile immaginare la frustrazione di una persona come Stephen Hawking che costruisce faticosamente una frase con i movimenti degli occhi o contraendo un muscolo della guancia.

Sono state fatte molte ricerche per decodificare il parlato dall'attività cerebralema i risultati migliori dipendono dall'invasività impianti cervello-computer.

I ricercatori di Meta AI hanno utilizzato la magnetoencefalografia (MEG) e l'elettroencefalografia (EEG) per registrare le onde cerebrali di 175 volontari mentre ascoltavano brevi storie e frasi isolate.

Hanno utilizzato un modello vocale pre-addestrato e l'apprendimento contrastivo per identificare quali modelli di onde cerebrali erano associati a parole specifiche che i soggetti stavano ascoltando.

Decodificare la percezione del parlato da registrazioni cerebrali non invasive,

guidato dall'unico e solo @honualx

è appena uscito nell'ultimo numero di Nature Machine Intelligence:- documento ad accesso libero: https://t.co/1jtpTezQzM

- codice di formazione completo: https://t.co/Al2alBxeUC pic.twitter.com/imLxRjRQ6h- Jean-Rémi King (@JeanRemiKing) 5 ottobre 2023

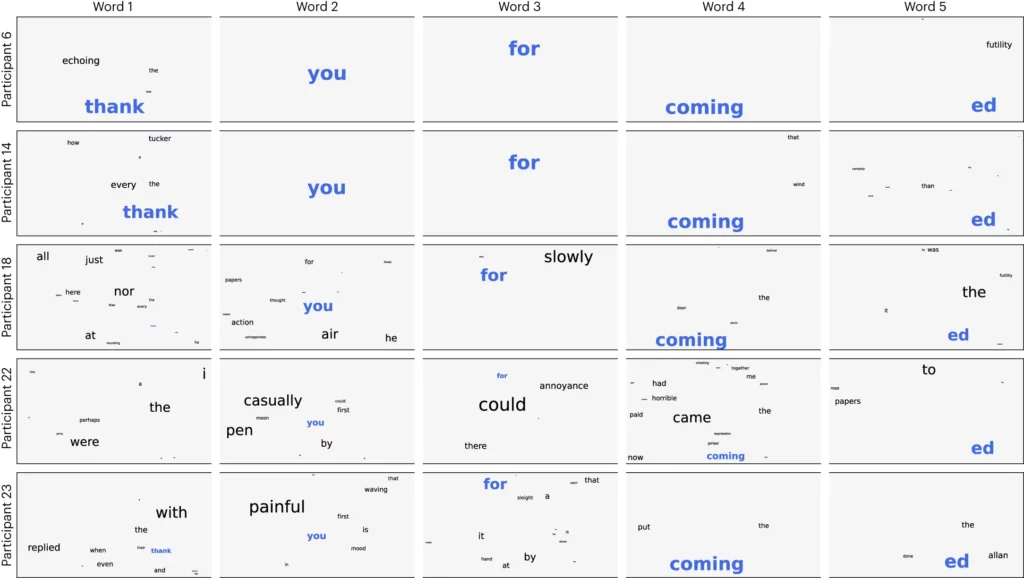

I ricercatori hanno suddiviso l'audio in segmenti di 3 secondi e poi hanno testato il loro modello per vedere se era in grado di identificare correttamente quale dei 1.500 segmenti il volontario stava ascoltando. Il modello ha previsto una sorta di nuvola di parole, con la parola più probabile a cui è stato dato il maggior peso.

Hanno ottenuto una precisione media di 41% e una precisione di 95,9% con i partecipanti migliori.

La ricerca dimostra che è possibile farsi un'idea abbastanza precisa del discorso che una persona sta ascoltando, ma ora il processo deve essere invertito per essere utile. Dobbiamo misurare le loro onde cerebrali e sapere a quale parola stanno pensando.

Il documento suggerisce di addestrare una rete neurale mentre i soggetti producono parole parlando o scrivendo. Questo modello generale potrebbe poi essere utilizzato per dare un senso alle onde cerebrali e alle parole associate che un malato di SLA stava pensando.

I ricercatori sono stati in grado di identificare segmenti di discorso da un insieme limitato e predeterminato. Per una comunicazione corretta, bisognerebbe essere in grado di identificare molte più parole. L'uso di un'intelligenza artificiale generativa per prevedere la parola successiva più probabile che una persona sta cercando di dire potrebbe aiutare in questo senso.

Anche se il processo non è invasivo, è comunque necessario essere collegati a un sistema di Dispositivo MEG. Purtroppo, i risultati delle misurazioni EEG non sono stati eccellenti.

La ricerca promette che l'intelligenza artificiale potrebbe essere utilizzata per aiutare le persone senza voce, come i malati di SLA, a comunicare. L'uso di un modello pre-addestrato ha anche evitato la necessità di un addestramento più minuzioso, parola per parola.

Meta AI ha reso pubblici il modello e i dati, sperando che altri ricercatori si basino sul loro lavoro.