Nvidia ha presentato una versione aggiornata del suo Grace Hopper Superchip (GH200) annunciato due mesi fa. Il GH200 è stato progettato per alimentare i data center per l'elaborazione dell'intelligenza artificiale su larga scala.

La GH200 non è ancora entrata in produzione di serie, ma ha già avuto una aggiornamento importante nella sua memoria. La salsa segreta di questi nuovi chip è la memoria ad alta larghezza di banda, chiamata HBM3e, che è in grado di accedere ai dati a 5 TB/s.

Questo rappresenta un miglioramento di 50% rispetto alla memoria HBM3 del chip annunciato a fine maggio.

Nvidia ha collegato questa memoria ad alta velocità a potenti CPU e GPU sullo stesso dispositivo. L'aumento della velocità di elaborazione che ne deriva migliorerà notevolmente la capacità di elaborazione dell'intelligenza artificiale dei data center attuali.

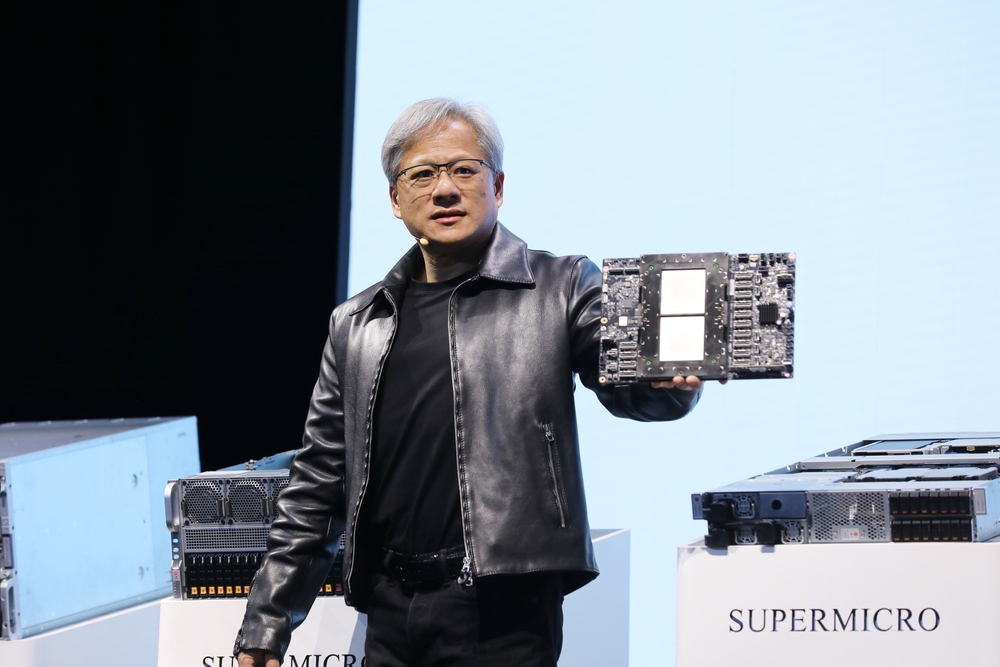

Oltre al chip aggiornato, Nvidia ha annunciato anche la piattaforma GH200 Grace Hopper, che consente di collegare 2 chip GH200 su un'unica scheda.

La piattaforma offre otto petaflop di elaborazione AI e 282 GB di memoria HBM3e con una larghezza di banda di 10 TB/s.

In che modo il chip di Nvidia cambierà i data center?

I numeri possono essere un po' difficili da capire. Ma quanto è importante questo nuovo chip e questa nuova piattaforma?

Nella sua presentazione, Jensen Huang, CEO di Nvidia, ha fatto l'esempio di un tipico data center con 8800 processori x86 che svolgono diverse funzioni di calcolo (budget ISO).

Un centro dati di questo tipo che esegue Llama 2 per l'inferenza, con un database vettoriale che viene interrogato e SDXL che genera gli output, costerebbe circa $100m e consumerebbe 5MW di energia.

Un data center di $100m che utilizza 2500 piattaforme GH200 potrebbe eseguire gli stessi modelli 12 volte più velocemente e consumerebbe solo 3MW di energia.

Se un data center si concentra su un insieme molto specifico di attività (carico di lavoro ISO), il confronto diventa ancora più sbalorditivo.

Basterebbe spendere $8m per 210 dispositivi GH200 che consumano 20 volte meno energia per eguagliare le prestazioni di un data center da $100m.

Inutile dire che tutti i centri dati di cloud computing con intelligenza artificiale che erano in fase di progettazione prima di questo rilascio dovranno tornare al tavolo da disegno.

I chip GH200 verranno distribuiti nel secondo trimestre del 2024 e si prevede che si prenderanno un bel po' di processori x86. Il nuovo chip MI300 di AMD è il rivale più vicino a Nvidia, ma il suo vantaggio in termini di memoria sembra essere eroso dall'aggiornamento del nuovo GH200.

L'avanzamento della tecnologia dei processori che stiamo vedendo sta superando Legge di Moore e non mostra segni di rallentamento. Le applicazioni di intelligenza artificiale generativa offrono già prestazioni impressionanti, ma sembra che stiano per diventare molto più veloci.