I ricercatori delle università britanniche Durham University, University of Surrey e Royal Holloway University of London hanno sviluppato una tecnica innovativa supportata dall'intelligenza artificiale per estrarre i tasti dalle registrazioni acustiche.

Il studio ha sviluppato una tecnica per leggere con successo i tasti della tastiera utilizzando registrazioni audio.

Questa tecnica potrebbe consentire agli hacker di analizzare le sequenze di tasti, prendendo il controllo del microfono di un dispositivo e raccogliendo informazioni personali come password, conversazioni private, messaggi e altri dati sensibili.

I tasti vengono registrati attraverso un microfono ed elaborati e analizzati da un modello di apprendimento automatico (ML) che ne determina la spaziatura e la posizione sulla tastiera.

Il modello è in grado di identificare i singoli tasti premuti con un tasso di precisione sconvolgente di 95% quando i tasti vengono registrati attraverso il microfono di un telefono vicino. L'accuratezza della previsione è scesa a 93% quando le registrazioni effettuate tramite Zoom sono state utilizzate per addestrare l'algoritmo di classificazione del suono.

Gli attacchi di hacking acustico sono diventati sempre più sofisticati grazie alla disponibilità diffusa di dispositivi dotati di microfoni in grado di catturare audio di alta qualità.

Come funziona il modello?

L'attacco inizia registrando le battute sulla tastiera dell'obiettivo. Questi dati sono fondamentali per l'addestramento dell'algoritmo predittivo.

La registrazione può essere effettuata utilizzando un microfono nelle vicinanze o il telefono infettato da malware dell'obiettivo con accesso al suo microfono.

In alternativa, un partecipante disonesto a una chiamata Zoom potrebbe correlare i messaggi digitati dall'obiettivo con la sua registrazione audio. È inoltre possibile violare il microfono del computer utilizzando malware o vulnerabilità del software.

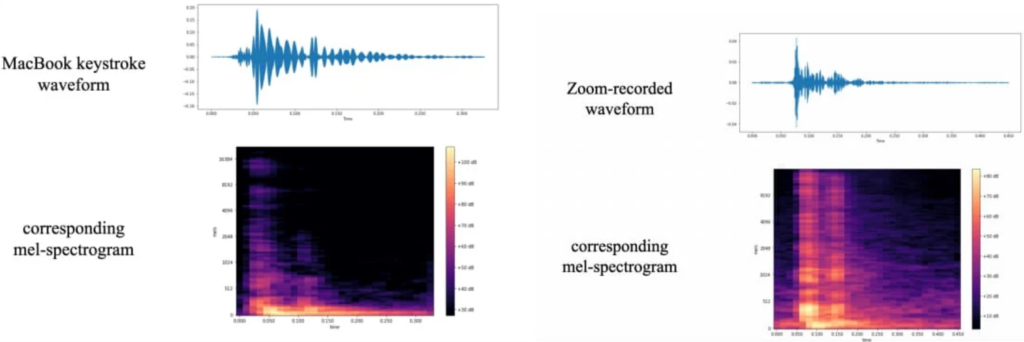

I ricercatori hanno raccolto i dati dell'addestramento premendo 25 volte ciascuno dei 36 tasti di un moderno MacBook Pro, registrando il suono generato da ciascun tasto. Le forme d'onda e gli spettrogrammi sono stati prodotti da queste registrazioni, visualizzando le variazioni identificabili per ogni tasto.

È stata eseguita un'ulteriore elaborazione dei dati per migliorare i segnali utilizzati per l'identificazione dei tasti premuti.

Queste immagini di spettrogrammi sono state utilizzate per addestrare "CoAtNet", un classificatore di immagini che attribuisce diversi spettrogrammi audio a diverse sequenze di tasti.

Nei loro test, i ricercatori hanno utilizzato un computer portatile con una tastiera simile ai più recenti laptop Apple. I microfoni e i metodi di registrazione comprendevano un iPhone 13 Mini posto a 17 cm di distanza dall'obiettivo, Zoom e Skype.

Il classificatore CoANet ha dimostrato un'accuratezza di 95% dalle registrazioni su smartphone e di 93% da quelle acquisite tramite Zoom. Sono state inoltre testate le sequenze di tasti registrate tramite Skype, che hanno dato un'accuratezza di 91,7%.

Il documento di ricerca suggerisce di modificare gli stili di digitazione o di utilizzare password randomizzate per prevenire tali attacchi, ma ciò è tutt'altro che pratico.

Altre potenziali misure difensive includono l'impiego di software per riprodurre i suoni dei tasti, il rumore bianco o i filtri audio dei tasti basati su software. Tuttavia, lo studio ha rilevato che anche una tastiera silenziosa può essere analizzata con successo alla ricerca di sequenze di tasti.

Si tratta di un altro esempio inedito di come l'apprendimento automatico possa consentire tecniche di frode sofisticate. A studio recente ha scoperto che le voci audio false e profonde possono ingannare fino a 25% di persone.

Gli attacchi audio potrebbero essere rivolti a persone di alto profilo, come politici e amministratori delegati, per rubare informazioni sensibili o lanciare attacchi ransomware basati sulle conversazioni rubate.