Mentre si discute dei rischi dei sistemi di intelligenza artificiale, non possiamo trascurare la pressione che la tecnologia esercita sulle forniture energetiche e idriche del mondo, già sottoposte a un forte stress.

I progetti complessi di apprendimento automatico (ML) dipendono da una costellazione di tecnologie, tra cui l'hardware per l'addestramento (GPU) e l'hardware per ospitare e distribuire i modelli di IA.

Sebbene tecniche e architetture di addestramento dell'IA efficienti promettano di ridurre il consumo energetico, il boom dell'IA è appena iniziato e le big tech stanno aumentando gli investimenti in data center e tecnologie cloud che consumano risorse.

Con l'aggravarsi della crisi climatica, trovare un equilibrio tra progresso tecnologico ed efficienza energetica è più che mai fondamentale.

Sfide energetiche per l'IA

Il consumo energetico dell'IA è aumentato con l'avvento di architetture complesse e computazionalmente costose come le reti neurali.

Ad esempio, si dice che il GPT-4 sia basato su 8 modelli con 220 miliardi di parametri ciascuno, per un totale di circa 1,76 trilioni di parametri. Inflection sta attualmente costruendo un cluster di 22.000 chip Nvidia di fascia altache potrebbe costare circa $550.000.000 con un prezzo al dettaglio approssimativo di $25.000 per scheda. E questo solo per i chip.

Ogni modello avanzato di IA richiede risorse immense per essere addestrato, ma fino a poco tempo fa era difficile capire il vero costo dello sviluppo dell'IA.

A Studio 2019 dell'Università del Massachusetts ad Amherst ha studiato il consumo di risorse associato agli approcci delle reti neurali profonde (DNN).

In genere, queste DNN richiedono agli scienziati dei dati di progettare manualmente o di utilizzare la ricerca di architetture neurali (NAS) per trovare e addestrare da zero una rete neurale specializzata per ogni singolo caso.

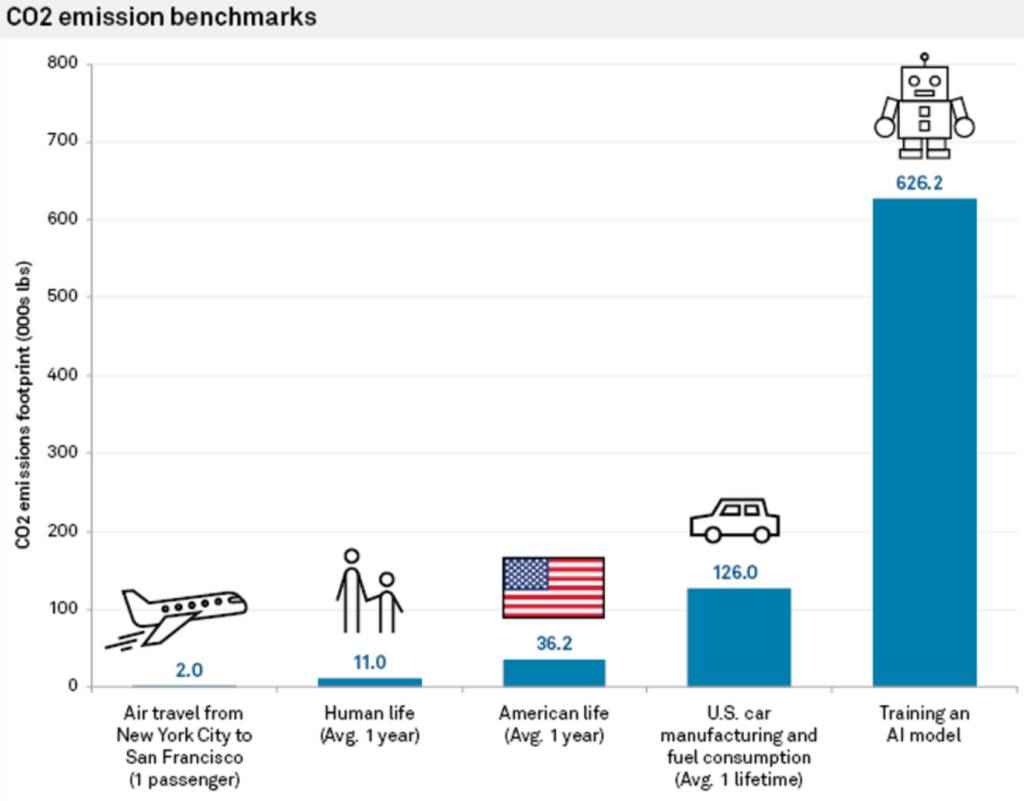

Questo approccio non solo richiede molte risorse, ma ha anche una notevole impronta di carbonio. Lo studio ha scoperto che l'addestramento di una singola rete neurale di grandi dimensioni basata su Transformer, costruita utilizzando NAS, uno strumento comunemente impiegato nella traduzione automatica, ha generato circa 626.000 libbre di anidride carbonica.

Ciò equivale all'incirca alle emissioni di gas nel corso della vita di 5 automobili.

Carlos Gómez-Rodríguez, informatico dell'Università di A Coruña in Spagna, ha commentato lo studio: "Mentre probabilmente molti di noi hanno pensato a questo problema in modo astratto e vago, le cifre mostrano davvero l'entità del problema", aggiungendo: "Né io né altri ricercatori con cui ne ho discusso pensavamo che l'impatto ambientale fosse così sostanziale".

I costi energetici per l'addestramento del modello sono solo dei valori di base, ovvero la quantità minima di lavoro necessaria per rendere operativo un modello.

Come dice Emma Strubell, dottoranda presso l'Università del Massachusetts, "addestrare un singolo modello è la quantità minima di lavoro che si può fare".

L'approccio "una volta per tutte" del MIT

I ricercatori del MIT hanno in seguito proposto una soluzione a questo problema: il Approccio "una volta per tutte" (OFA).

I ricercatori descrivere il problema con l'addestramento delle reti neurali convenzionali: "La progettazione di reti neurali specializzate per ogni scenario è costosa dal punto di vista ingegneristico e computazionale, sia con metodi basati sull'uomo che con i NAS. Poiché tali metodi devono ripetere il processo di progettazione della rete e riaddestrare la rete progettata da zero per ogni caso, il loro costo totale cresce linearmente con l'aumentare del numero di scenari di implementazione, con conseguente consumo eccessivo di energia ed emissioni di CO2".

Con il paradigma OFA del MIT, i ricercatori addestrano un'unica rete neurale generica da cui possono essere create varie sotto-reti specializzate. Il processo OFA non richiede una formazione aggiuntiva per le nuove sottoreti, riducendo le ore di GPU ad alto consumo energetico necessarie per la formazione dei modelli e diminuendo le emissioni di CO2.

Oltre ai vantaggi ambientali, l'approccio OFA offre sostanziali miglioramenti delle prestazioni. Nei test interni, i modelli creati con l'approccio OFA hanno funzionato fino a 2,6 volte più velocemente sui dispositivi edge (dispositivi IoT compatti) rispetto ai modelli creati con NAS.

L'approccio OFA del MIT è stato premiato in occasione della quarta edizione della Low Power Computer Vision Challenge nel 2019, un evento annuale ospitato dall'IEEE che promuove la ricerca sul miglioramento dell'efficienza energetica dei sistemi di computer vision (CV).

Il team del MIT si è aggiudicato il massimo dei voti e gli organizzatori dell'evento hanno commentato: "Le soluzioni di questi team superano le migliori soluzioni presenti in letteratura".

Il 2023 Sfida di visione computerizzata a basso consumo sta ricevendo le candidature fino al 4 agosto.

Il ruolo del cloud computing sull'impatto ambientale dell'IA

Oltre alla formazione dei modelli, gli sviluppatori hanno bisogno di immense risorse cloud per ospitare e distribuire i loro modelli.

Grandi aziende tecnologiche come Microsoft e Google stanno aumentando gli investimenti in risorse cloud nel 2023 per gestire la crescente domanda di prodotti legati all'intelligenza artificiale.

Il cloud computing e i centri dati ad esso associati hanno un immenso fabbisogno di risorse. A partire dal 2016, stime suggerite che i data center di tutto il mondo sono responsabili di circa 1% - 3% del consumo globale di elettricità, pari all'utilizzo di energia di alcune piccole nazioni.

Anche l'impronta idrica dei data center è colossale. I grandi data center possono consumare milioni di litri d'acqua al giorno.

Nel 2020, è stato riferito che i centri dati di Google nella Carolina del Sud sono stati autorizzati a usare 549 milioni di litri d'acquaquasi il doppio della quantità utilizzata due anni prima. Un centro dati da 15 megawatt può consumare fino a 360.000 galloni di acqua al giorno.

Nel 2022, Google ha rivelato che la sua flotta globale di data center ha consumato circa 4,3 miliardi di galloni d'acqua. Tuttavia, sottolineano che il raffreddamento ad acqua è sostanzialmente più efficiente di altre tecniche.

Le grandi aziende tecnologiche hanno tutte piani simili per ridurre l'uso delle risorse, come Google, che nel 2017 ha raggiunto l'obiettivo di far corrispondere il 100% del suo uso di energia con acquisti di energia rinnovabile.

Hardware AI di nuova generazione modellato sul cervello umano

L'intelligenza artificiale richiede un'immensa quantità di risorse, mentre il nostro cervello funziona con una semplice 12 watt di potenza - è possibile replicare tale efficienza energetica nella tecnologia AI?

Persino un computer desktop assorbe oltre 10 volte più energia del cervello umano, e i modelli di IA più potenti richiedono milioni di volte più energia. Costruire una tecnologia di IA in grado di replicare l'efficienza dei sistemi biologici trasformerebbe completamente il settore.

Per essere onesti con l'IA, questo confronto non tiene conto del fatto che il cervello umano è stato "addestrato" nel corso di milioni di anni di evoluzione. Inoltre, i sistemi di IA e i cervelli biologici eccellono in compiti diversi.

Tuttavia, la costruzione di hardware per l'IA in grado di elaborare informazioni con un consumo energetico simile a quello dei cervelli biologici consentirebbe di realizzare IA autonome ispirate alla biologia che non siano legate a ingombranti fonti di energia.

Nel 2022, un gruppo di ricercatori dell'Istituto Indiano di Tecnologia di Bombay, ha annunciato lo sviluppo di un nuovo chip di intelligenza artificiale modellato sul cervello umano. Il chip funziona con le reti neurali spiking (SNN), che imitano l'elaborazione dei segnali neurali dei cervelli biologici.

Il cervello è composto da 100 miliardi di piccoli neuroni collegati a migliaia di altri neuroni tramite sinapsi, che trasmettono informazioni attraverso schemi coordinati di spike elettrico. I ricercatori hanno costruito neuroni artificiali a bassissima energia, dotando gli SNN di corrente di tunneling da banda a banda (BTBT).

"Con il BTBT, la corrente di tunneling quantistico carica il condensatore con una corrente bassissima, il che significa che è necessaria meno energia", ha spiegato Udayan Ganguly del team di ricerca.

Secondo il professor Ganguly, rispetto agli attuali neuroni allo stato dell'arte implementati nelle SNN hardware, il loro approccio raggiunge "un'energia per spike 5.000 volte inferiore a parità di area e una potenza di standby 10 volte inferiore a parità di area ed energia per spike".

I ricercatori hanno dimostrato con successo il loro approccio in un modello di riconoscimento vocale ispirato alla corteccia uditiva del cervello. Le SNN potrebbero migliorare le applicazioni su dispositivi compatti come i telefoni cellulari e i sensori IoT.

Il team mira a sviluppare un "nucleo neurosinaptico a bassissimo consumo e un meccanismo di apprendimento in tempo reale su chip, che sono fondamentali per reti neurali autonome di ispirazione biologica".

L'impatto ambientale dell'IA è spesso trascurato, ma la soluzione di problemi come il consumo energetico dei chip di IA aprirà nuove strade all'innovazione.

Se i ricercatori riuscissero a modellare la tecnologia dell'IA sui sistemi biologici, che sono eccezionalmente efficienti dal punto di vista energetico, ciò consentirebbe lo sviluppo di sistemi autonomi di IA che non dipendono da un'ampia alimentazione e dalla connettività dei centri dati.