Mentre l'IA continua a inserirsi nei processi di reclutamento, è chiaro che la promessa di efficienza di questa tecnologia comporta dei rischi.

Secondo Dati 2022circa 55% di aziende utilizzano già strumenti di intelligenza artificiale per il reclutamento.

Se da un lato l'intelligenza artificiale ha accelerato le pratiche di assunzione tradizionali, eliminando pile di CV e curriculum, dall'altro ha sollevato questioni critiche sull'equità, i pregiudizi e la natura stessa del processo decisionale umano.

Dopotutto, le IA sono addestrate su dati umani, quindi possono ereditare tutti i pregiudizi e i preconcetti che promettono di sradicare.

È qualcosa che possiamo cambiare? Cosa abbiamo imparato finora dall'IA del reclutamento?

Meta accusata di pratiche pubblicitarie discriminatorie da gruppi per i diritti umani

I dati mostrano che alcuni 79% di persone in cerca di lavoro usano i social media per cercare lavoro, e le prove dimostrano che è proprio qui che inizia la discriminazione.

Meta è attualmente di fronte a molteplici accuse da parte di organizzazioni europee per i diritti umani che sostengono che l'algoritmo di Facebook per il targeting degli annunci di lavoro sia parziale.

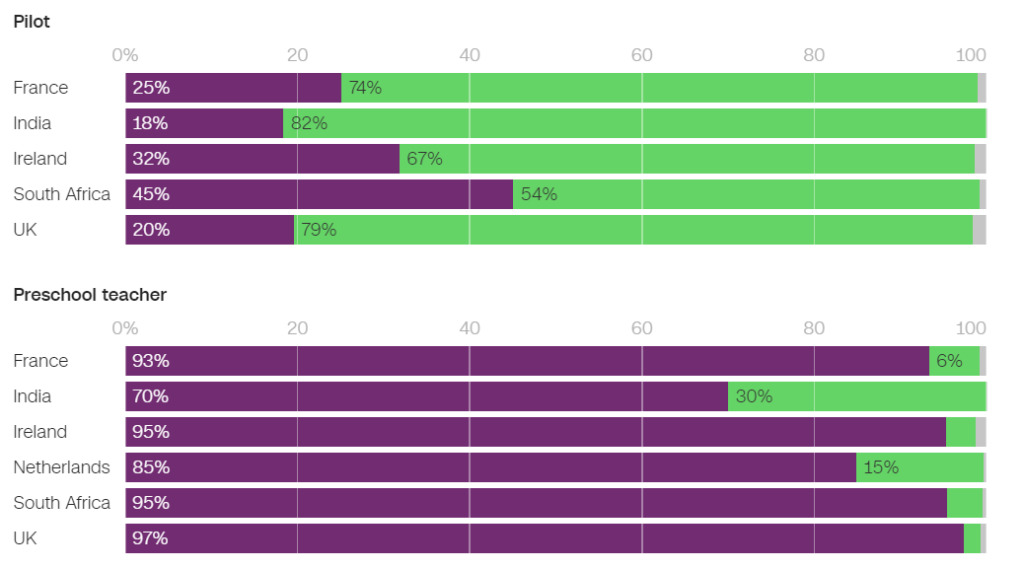

A giugno, l'ONG Testimonianza globale ha condotto una ricerca su diversi annunci di lavoro auto-targettizzati su Facebook e ha scoperto che molti di essi perpetuavano pregiudizi di genere.

Ad esempio, gli uomini avevano una probabilità significativamente maggiore di ricevere annunci relativi all'ingegneria, mentre le donne avevano una probabilità sostanzialmente maggiore di ricevere annunci relativi all'insegnamento.

Tra gli annunci pubblicati in Francia, 93% degli utenti che hanno visualizzato un annuncio di lavoro di insegnante di scuola materna e 86% di quelli che hanno visualizzato un annuncio di lavoro di psicologo erano donne. Al contrario, solo 25% di donne hanno visualizzato un annuncio di lavoro di un pilota e appena 6% un annuncio di lavoro di un meccanico.

Nei Paesi Bassi, 85% degli utenti a cui è stato mostrato un annuncio di lavoro per insegnanti e 96% di quelli a cui è stato mostrato un annuncio di lavoro per receptionist erano donne. Risultati simili sono stati osservati in molti altri Paesi, tra cui Regno Unito, India e Sudafrica.

In un intervista alla CNNNaomi Hirst di Global Witness ha dichiarato: "La nostra preoccupazione è che Facebook stia esacerbando i pregiudizi che viviamo all'interno della società e che, di fatto, stia ostacolando le opportunità di progresso e di equità sul posto di lavoro".

Insieme al Bureau Clara Wichmann e alla Fondation des Femmes, Global Witness ha presentato denunce contro Meta alle autorità per i diritti umani e per la protezione dei dati in Francia e nei Paesi Bassi.

I gruppi sollecitano un'indagine per verificare se le pratiche di Meta violano le leggi sui diritti umani o sulla protezione dei dati. Se le accuse saranno confermate, Meta potrebbe incorrere in multe e sanzioni.

In risposta, un portavoce di Meta ha dichiarato: "Il sistema tiene conto di diversi tipi di informazioni per cercare di servire alle persone gli annunci a cui sono più interessate".

Non è la prima volta che Meta ha respinto tali critiche: l'azienda ha affrontato cause multiple nel 2019 e si è impegnata a modificare il proprio sistema di distribuzione degli annunci per evitare pregiudizi basati su caratteristiche protette come il sesso e la razza.

Pat de Brún, di Amnesty International, ha criticato i risultati di Global Witness. "Le ricerche dimostrano costantemente come gli algoritmi di Facebook producano risultati profondamente diseguali e spesso rafforzino l'emarginazione e la discriminazione", ha dichiarato alla CNN.

Amazon elimina lo strumento segreto di reclutamento AI che mostrava pregiudizi nei confronti delle donne

Amazon ha sviluppato uno strumento di reclutamento AI tra il 2014 e il 2017, prima di rendersi conto che lo strumento era parziale nella selezione di posti di lavoro per sviluppatori di software e altri posti tecnici. Nel 2018, Amazon ha abbandonato completamente lo strumento.

Il sistema di intelligenza artificiale ha penalizzato i curriculum contenenti le parole "donna" e "femminile" e ha declassato le competenze delle laureate.

Il sistema è fallito anche dopo che Amazon ha tentato di modificare gli algoritmi per renderli neutrali rispetto al genere.

In seguito è emerso che Amazon ha addestrato lo strumento sui curriculum inviati all'azienda in un periodo di 10 anni, la maggior parte dei quali proveniva da uomini.

Come molti sistemi di intelligenza artificiale, lo strumento di Amazon è stato influenzato dai dati su cui è stato addestrato, con conseguenti pregiudizi involontari. Questo pregiudizio ha favorito i candidati di sesso maschile e ha preferito i curriculum che utilizzavano un linguaggio più comunemente presente nei curriculum degli ingegneri maschi.

Inoltre, a causa di problemi con i dati sottostanti, il sistema spesso raccomandava candidati non qualificati per vari lavori.

Il Forum economico mondiale ha detto del sistema di reclutamento di Amazon: "Ad esempio, come nel caso di Amazon, forti squilibri di genere potrebbero essere correlati al tipo di studio intrapreso. Questi pregiudizi sui dati di addestramento potrebbero anche derivare da una cattiva qualità dei dati o da insiemi di dati molto piccoli e non diversificati, come nel caso di aziende che non operano a livello globale e che cercano candidati di nicchia".

Amazon è riuscita a riutilizzare una "versione annacquata" del motore di reclutamento per compiti rudimentali, come l'eliminazione dei profili duplicati dei candidati dai database.

Hanno creato un nuovo team per fare un altro tentativo di screening automatico dell'occupazione, questa volta concentrandosi sulla promozione della diversità.

Google lotta contro i propri problemi di discriminazione e pregiudizio

Nel dicembre 2020, il dott. Timnit Gebru, uno dei principali esperti di etica dell'IA di Google, ha annunciato che la azienda l'aveva licenziata.

Il licenziamento è avvenuto dopo che il dottor Gebru ha espresso preoccupazioni sull'approccio di Google alle assunzioni di minoranze e sui pregiudizi intrinseci nei sistemi di intelligenza artificiale.

Prima di lasciare l'azienda, il Dr. Gebru stava per pubblicare un documento che evidenziava i pregiudizi nei modelli di intelligenza artificiale di Google.

Dopo aver presentato l'articolo a una conferenza accademica, la dottoressa Gebru ha rivelato che un dirigente di Google le ha chiesto di ritrattare l'articolo o di rimuovere i nomi suoi e degli altri ricercatori di Google. Al suo rifiuto, Google ha accettato una proposta di dimissioni condizionate, ponendo di fatto fine immediatamente alla posizione della dottoressa Gebru.

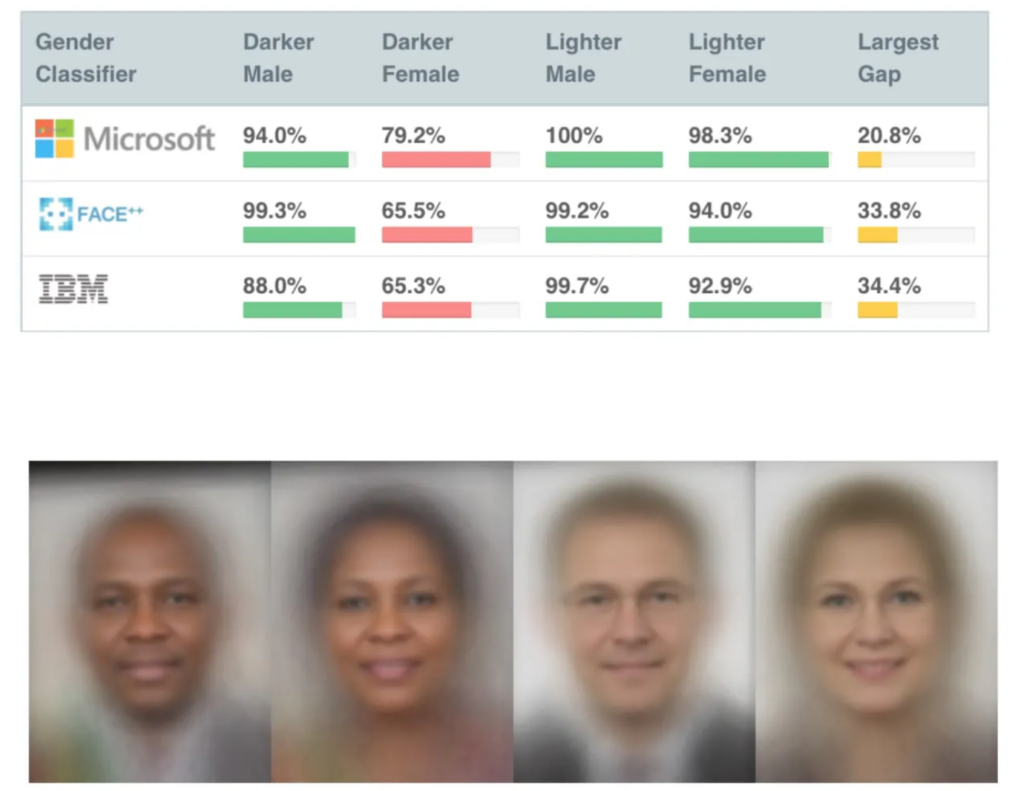

Questo non molto tempo dopo la pubblicazione di diversi studi molto influenti sui pregiudizi dell'intelligenza artificiale, tra cui Lo studio Gender Shades del MITche è diventato uno degli articoli sull'IA più citati di tutti i tempi.

Lo studio Gender Shades ha scoperto una distorsione nelle IA di riconoscimento facciale, che hanno identificato erroneamente i volti neri per circa 30%-35% del tempo, rispetto a circa 5% per i volti bianchi.

Un'errata corrispondenza del riconoscimento facciale ha portato all'arresto e all'incarcerazione illegittimi di un uomo di colore. diversi uomini negli Stati Uniti.

Il licenziamento di Gebru ha provocato una tempesta mediatica sulle pratiche discriminatorie nella Silicon Valley.

Mutale Nkonde dello Stanford Digital Civil Society Lab ha dichiarato: "Il suo licenziamento indica solo che gli scienziati, gli attivisti e gli studiosi che vogliono lavorare in questo campo - e sono donne di colore - non sono i benvenuti nella Silicon Valley".

Il licenziamento del dottor Gebru ha ispirato un altro studio, Smascherare i pregiudizi codificatiche ha rilevato che le persone di colore hanno una probabilità significativamente maggiore di essere sottovalutate dall'IA di reclutamento rispetto a chiunque altro.

"Questo rapporto ha trovato ampie prove che suggeriscono che gli studenti e i professionisti neri sono preoccupati di affrontare pregiudizi anti-neri durante il processo di assunzione. Poco più della metà di tutti gli intervistati riferisce di aver osservato pregiudizi nel processo di assunzione o reclutamento sui siti web di assunzione o reclutamento. I professionisti neri hanno una probabilità leggermente maggiore di aver osservato tali pregiudizi, con il cinquantacinque per cento degli intervistati che ha indicato di averli osservati nel processo di assunzione". Smascherare i pregiudizi codificati, Laboratorio di politica legale della Pennsylvania.

Il documento afferma: "La conversazione pubblica stimolata dalla dottoressa Gebru e dai suoi colleghi sui pregiudizi algoritmici ha permesso al nostro laboratorio di impegnarsi in questo dialogo nazionale e di ampliare una comprensione più sfumata dei pregiudizi algoritmici nelle piattaforme di assunzione".

L'esposizione del problema è stata un catalizzatore per il cambiamento, ma l'IA ha una lunga strada da percorrere per riconciliare il suo ruolo nel delicato processo decisionale umano.

Il ruolo dell'IA nel reclutamento: recuperare alcuni aspetti positivi

Nonostante le numerose controversie, è stato difficile per le aziende resistere all'immenso potenziale dell'IA di accelerare le assunzioni.

Il ruolo dell'IA nel reclutamento ha certamente un senso logico: potrebbe essere più facile liberare l'IA dai pregiudizi rispetto agli esseri umani. Dopotutto, l'IA è *solo* matematica e codice, sicuramente più malleabile di pregiudizi inconsci profondamente radicati.

E se all'inizio e alla metà degli anni 2010 i dati di formazione erano fortemente distorti, soprattutto a causa della mancanza di set di dati diversificati, da allora la situazione è probabilmente migliorata.

Un importante strumento di reclutamento AI è Sapia, soprannominato "intervistatore intelligente". Secondo il fondatore di Sapia, Barb Hyman, l'intelligenza artificiale consente un processo di colloquio "cieco" che non si basa su curriculum, social media o dati demografici, ma solo sulle risposte del candidato, eliminando così i pregiudizi prevalenti nelle assunzioni guidate dall'uomo.

Questi sistemi possono offrire a tutti una possibilità equa, intervistando tutti i candidati. Hyman suggerisceSe si utilizza l'intelligenza artificiale, si ha il doppio delle probabilità di assumere e mantenere le donne nel processo di assunzione".

Ma anche il processo stesso di intervistare qualcuno con l'IA solleva delle domande.

I modelli di elaborazione del linguaggio naturale (NLP) sono in genere addestrati principalmente su testi in inglese nativo, il che significa che sono scarsa capacità di gestire l'inglese non madrelingua.

Questi sistemi potrebbero inavvertitamente penalizzare chi non è madrelingua inglese o chi ha caratteristiche culturali diverse. Inoltre, i critici sostengono che le disabilità potrebbero non essere tenute adeguatamente in considerazione in una chat o in un colloquio video dell'IA, portando a ulteriori potenziali discriminazioni.

Ciò è aggravato dal fatto che i candidati spesso non sanno se un'IA li sta valutando, rendendo così impossibile richiedere le necessarie modifiche al processo di intervista.

I set di dati sono fondamentali

Le serie di dati sono fondamentali in questo caso. Se si addestra un'intelligenza artificiale su dati vecchi di dieci anni, questa impara valori vecchi di dieci anni.

Il mercato del lavoro è diventato notevolmente più diversificato dall'inizio del millennio.

In alcuni Paesi, ad esempio, le donne superano gli uomini in diverse discipline mediche chiave, come psicologia, genetica, pediatria e immunologia.

Nel Regno Unito, un rapporto 2023 ha rilevato che 27% delle donne occupate lavorano in "occupazioni professionali" (come medici, ingegneri, infermieri, contabili, insegnanti e avvocati) rispetto a 26% degli uomini, una tendenza in costante aumento da 5 a 10 anni.

Tali transizioni hanno subito un'accelerazione negli ultimi 2-5 anni: molte serie di dati sono più vecchie e semplicemente non riflettono dati recenti. Problemi simili valgono anche per la razza e le disabilità, oltre che per il genere.

Le serie di dati devono rispecchiare i nostri luoghi di lavoro, sempre più diversificati, per servire tutti in modo equo.

Sebbene ci sia ancora un enorme lavoro da fare per garantire la diversità sul posto di lavoro, l'IA deve ereditare i valori del presente e non del passato. Questo dovrebbe essere il minimo indispensabile per produrre IA di reclutamento eque e trasparenti.

Gli sviluppatori di IA per il reclutamento dovranno probabilmente affrontare una rigida regolamentazione, con gli Stati Uniti, il Regno Unito, la Cina, gli Stati membri dell'Unione Europea e molti altri Paesi destinati a rafforzare i controlli sull'intelligenza artificiale nei prossimi anni.

La ricerca è in corso, ma è improbabile che la maggior parte delle IA di reclutamento applichi i principi di equità e imparzialità che ci aspettiamo dagli altri.