L'avvocato newyorkese Steven A Schwartz ha utilizzato ChatGPT per ricercare diversi "casi" che si sono rivelati falsi.

Il caso di Schwartz riguardava un uomo che aveva fatto causa alla compagnia aerea colombiana Avianca. L'attore ha lavorato con un team di avvocati, Levidow, Levidow & Oberman, che ha preparato una memoria legale che fa riferimento a casi giuridici completamente falsi.

Schwartz ha chiesto a ChatGPT la garanzia che i casi fossero reali, ma ha cercato di fare un controllo incrociato dettagliato solo su uno dei casi e ChatGPT gli ha assicurato che poteva essere trovato nei database di Westlaw e LexisNexis. Su questa base, Schwartz ha pensato che anche gli altri casi fossero reali.

In seguito si è scoperto che solo un caso era reale, Zicherman v. Korean Air Lines Co., 516 U.S. 217 (1996)e ChatGPT ha sbagliato la data e diversi altri dettagli.

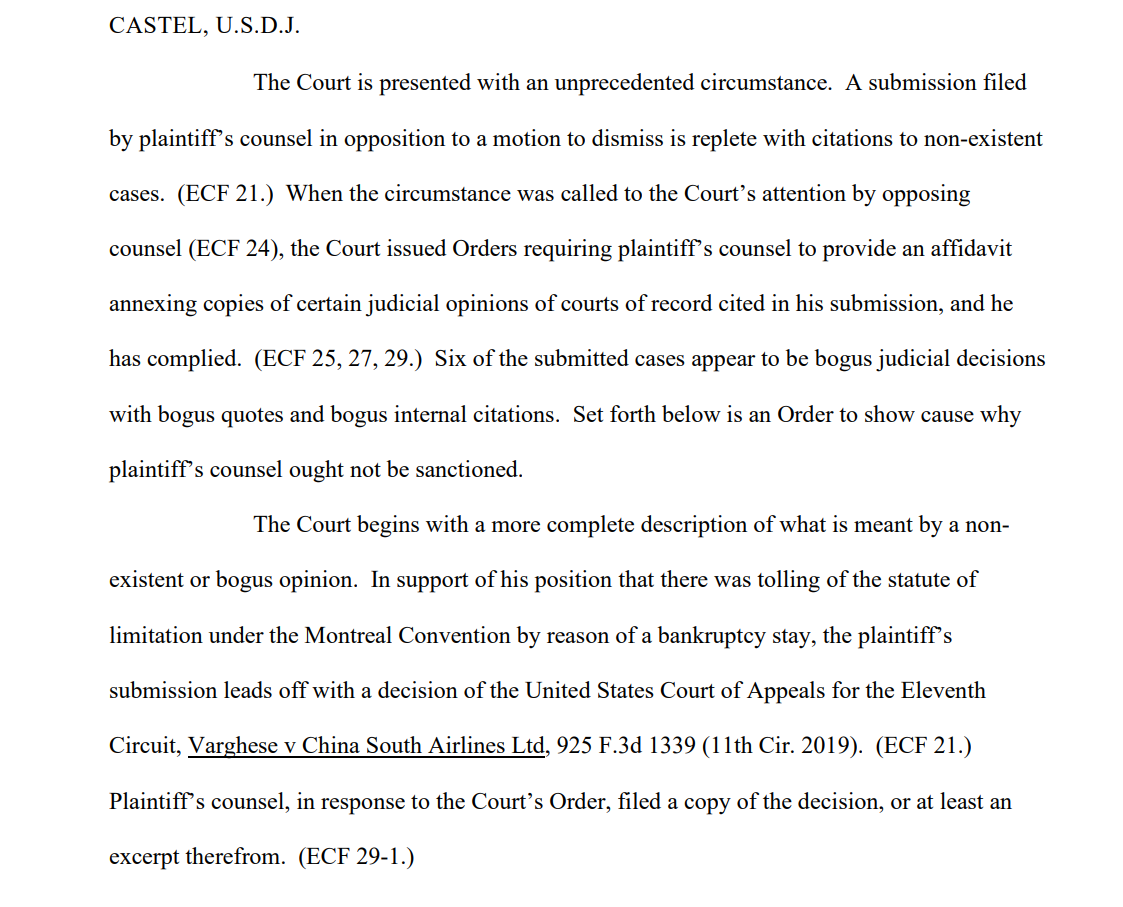

Dopo che il team del querelante ha presentato la memoria, uno dei destinatari, il giudice distrettuale degli Stati Uniti Kevin Castel, ha dichiarato: "Sei dei casi presentati sembrano essere decisioni giudiziarie fasulle con citazioni e citazioni interne fasulle".

Uno dei verbali dei tribunali diceLa Corte si trova di fronte a una circostanza senza precedenti. Una memoria presentata dall'avvocato del ricorrente in opposizione a una mozione di licenziamento è piena di citazioni di casi inesistenti".

Schwartz, che ha 30 anni di esperienza come avvocato, ha sostenuto che si è trattato di un errore innocente, dicendo alla Corte che "si rammarica molto" di aver usato ChatGPT per la ricerca e che "non era consapevole che il suo contenuto potesse essere falso". Ha anche ammesso di aver usato ChatGPT in altri casi legali.

Schwartz, che ha agito per conto di Peter LeDocu, un collega dello stesso studio legale, dovrà comparire davanti alla Corte l'8 giugno per spiegare perché lui e il suo studio legale non dovrebbero essere sanzionati.

Quando ChatGPT controlla ChatGPT

OpenAI è molto chiaro sul fatto che ChatGPT è vulnerabile al travisamento della verità, ma l'IA può apparire sicura di sé quando fornisce "esempi" contestualmente rilevanti che non sono corretti dal punto di vista fattuale - anche chiamati "allucinazioni".

Questo è un problema anche in ambito accademico, dove ChatGPT spesso genera riferimenti falsi, arrivando talvolta a produrre studi ed esperimenti realistici che non sono mai avvenuti.

Molte università hanno rilasciato dichiarazioni che sottolineano questo aspetto. Ad esempio, L'Università di Duke afferma, "Quello che forse non sapete di ChatGPT è che ha dei limiti significativi come assistente di ricerca affidabile. Uno di questi limiti è che è noto per fabbricare o "allucinare" (in termini di apprendimento automatico) le citazioni".

L'analisi dei riferimenti alla ricerca di incongruenze è diventata un modo affidabile per i tutor di individuare gli studenti che utilizzano ChatGPT per scrivere i saggi.

È proprio quello che è successo a Schwartz: è stato catturato. Non è stato il primo e non sarà l'ultimo. Sembrava sinceramente ignorante, ma l'ignoranza non costituisce necessariamente una difesa in tribunale.

La generazione di false citazioni legali è un esempio allarmante della fallibilità di ChatGPT e serve a ricordarci di controllare, ricontrollare e triplicare i "fatti" presentati dalle IA generative.