En 1956, Philip K. Dick a écrit une nouvelle intitulée "The Minority Report" (Le rapport de minorité) qui décrit un avenir où les "précogs" peuvent prévoir les crimes avant qu'ils ne se produisent dans la réalité.

Quelques décennies plus tard, Tom Cruise a transposé cette vision inquiétante sur grand écran, poursuivant des criminels en puissance sur la base de ces prédictions.

Les deux versions nous ont obligés à réfléchir aux implications éthiques d'une arrestation pour un acte que l'on pourrait commettre à l'avenir.

Aujourd'hui, alors que les méthodes de police prédictive font leur chemin dans l'application moderne de la loi, on peut se demander si nous sommes sur le point de réaliser le récit prémonitoire de Dick.

Qu'est-ce que la police prédictive et comment fonctionne-t-elle ?

La police prédictive associe l'application de la loi et l'analyse avancée, en exploitant l'apprentissage automatique pour anticiper les activités criminelles avant qu'elles ne se produisent.

Le principe est assez simple sur le papier : si nous pouvons décoder les schémas cachés dans les données historiques de la criminalité, nous pouvons créer des algorithmes pour prévoir les événements futurs.

Le processus commence par la collecte de données historiques sur les crimes, les flux de surveillance, les conversations sur les médias sociaux et même des nuances telles que les fluctuations météorologiques. Ce vaste ensemble d'informations est ensuite introduit dans des modèles sophistiqués d'apprentissage automatique conçus pour discerner les schémas sous-jacents.

Par exemple, le modèle peut déterminer qu'un quartier spécifique connaît un pic de cambriolages les soirs de week-end pluvieux.

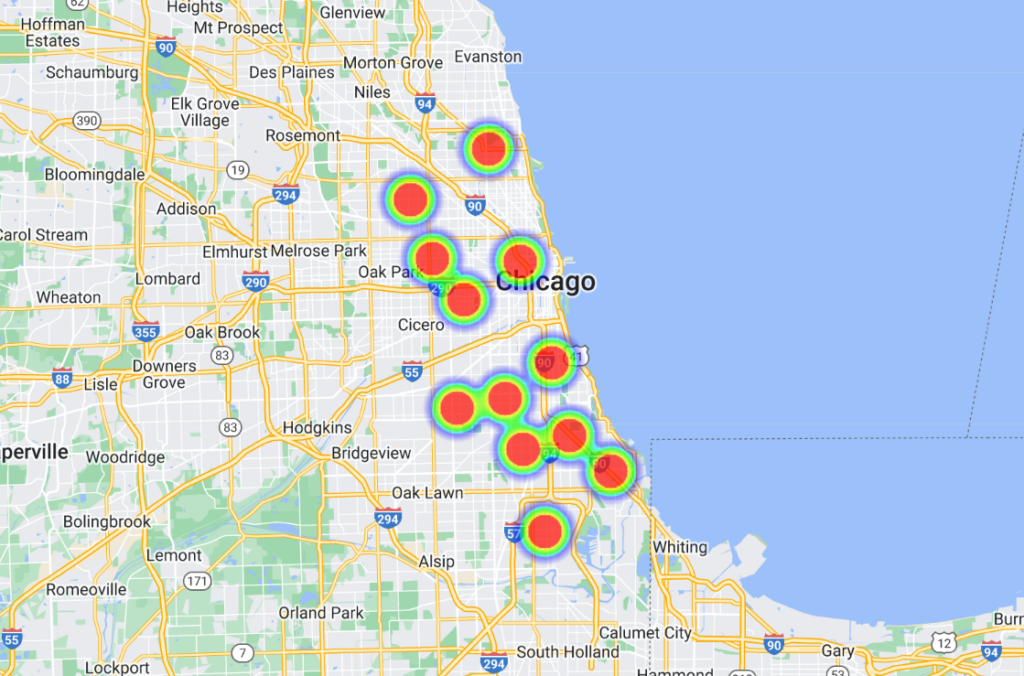

Une fois ces corrélations établies, des plateformes logicielles avancées les transforment en représentations visuelles, qui ressemblent souvent à des "cartes thermiques" mettant en évidence les points névralgiques probables de la criminalité. Cela permet à la police d'allouer ses ressources de manière proactive, en optimisant ses patrouilles et ses interventions.

Certains modèles sont allés plus loin en répertoriant les personnes par nom et par adresse, ce qui permet aux agents de disposer de prévisions très spécifiques et localisées.

L'histoire de la police prédictive

La technologie de la police prédictive est encore embryonnaire, et bien qu'il y ait eu quelques acteurs influents dans l'industrie, comme Palantir, l'industrie est petite.

En juin 2022, l'Université de Chicago a développé un modèle d'IA capable de prévoir les lieux et les taux de criminalité dans la ville avec une prétendue précision de 90%.

En s'appuyant sur les données ouvertes relatives à la criminalité entre 2014 et 2016, l'équipe a divisé Chicago en carrés d'environ 300 mètres de côté. Le modèle peut prédire, une semaine à l'avance, le carré où la probabilité d'un crime est la plus élevée.

L'étude avait des intentions honnêtes : elle mettait au jour des biais spatiaux et socio-économiques dans les efforts de la police et l'allocation des ressources. Elle a révélé que les quartiers aisés recevaient plus de ressources que les zones à faible revenu.

Selon les termes de l'étude, "nous montrons ici que, si les modèles prédictifs peuvent renforcer le pouvoir de l'État par le biais de la surveillance criminelle, ils permettent également la surveillance de l'État en traçant les biais systémiques dans la répression de la criminalité".

En outre, le modèle a été entraîné à l'aide de données provenant de sept autres villes américaines et a donné des résultats similaires. Tous les ensembles de données et les algorithmes sont disponibles sur GitHub.

Chicago est une étude de cas importante en matière de police fondée sur les données et assistée par l'IA. Un autre exemple est celui de la carte thermique des crimes commis avec des armes à feuqui identifie les "points chauds" de la criminalité pouvant être pris en compte dans les efforts de maintien de l'ordre.

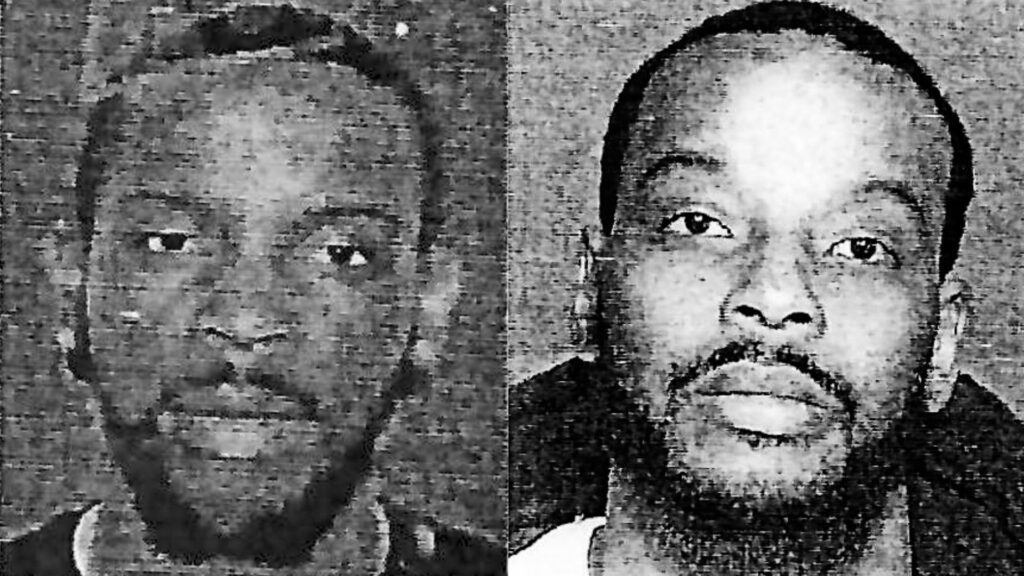

Un incident notable survenu en 2013 - au tout début de la police prédictive - a permis à la police de se rendre compte qu'elle n'était pas en mesure de faire face à la situation. impliqué Robert McDanielsIl s'agit d'un résident du quartier Austin de Chicago, qui compte 90% des crimes commis avec des armes à feu dans la ville.

Malgré ses antécédents non violents, l'inscription de McDaniel sur une liste de criminels potentiellement violents a fait de lui, à deux reprises, une cible de la violence armée, la police s'étant présentée à sa porte et l'ayant pris pour cible.

Une enquête menée par The Verge indique qu'un journaliste du Chicago Tribune a contacté M. McDaniel au sujet de la "heat list", un nom officieux que la police a donné aux algorithmes qui étiquettent les tireurs et les cibles potentiels.

Ishanu Chattopadhyay, chercheur principal de l'étude 2022 Chicago projet de prévision de la criminalitéIl a souligné que son modèle prédit des lieux et non des individus. "Ce n'est pas Minority Report", a-t-il déclaré, mais l'affaire McDaniels présente certainement des similitudes.

Répondant aux préoccupations de partialité, Chattopadhyay a noté qu'ils ont intentionnellement omis les infractions mineures au code de la route et à la législation sur les stupéfiants signalées par les citoyens, se concentrant sur les crimes violents et les délits contre les biens plus fréquemment signalés.

Toutefois, les ses études montrent que les Noirs sont plus souvent signalés pour des délits que leurs homologues blancs. Par conséquent, les quartiers noirs sont injustement qualifiés de "à haut risque".

En outre, l'intensification des activités policières dans une zone se traduit par une augmentation du nombre de délits signalés, ce qui crée une boucle de rétroaction qui fausse la perception de la criminalité.

Par ailleurs, le fait de s'appuyer sur des données antérieures peut perpétuer des stéréotypes et négliger le potentiel de changement et de réadaptation.

Quel est le bilan de la police prédictive ?

La police prédictive, sans surprise, est très controversée, mais fonctionne-t-elle vraiment ou remplit-elle son objectif de base ?

Une enquête menée en octobre 2023 par The Markup et Wired a révélé des défaillances flagrantes, s'ajoutant à un nombre croissant de preuves soulignant les dangers et les lacunes du transfert à des machines du processus décisionnel en matière d'application de la loi.

Le programme en question est Geoliticaun logiciel de police prédictive utilisé par la police de Plainfield, dans le New Jersey. Il convient de noter que le service de police de Plainfield est le seul des 38 services à avoir accepté de partager ses données avec les médias.

Précédemment connu sous le nom de PredPolDepuis, ce logiciel d'apprentissage automatique a été acquis par plusieurs services de police.

The Markup et Wired ont analysé 23 631 prédictions de Geolitica entre février et décembre 2018. Sur ce nombre, moins de 100 prédictions correspondaient à des cas de crimes réels, ce qui donne un taux de réussite de moins d'un demi pour cent.

Ces modèles de prédiction ont toujours été controversés, soulevant de nombreuses questions éthiques quant à leur potentiel de renforcement des préjugés discriminatoires et racistes qui prévalent dans l'IA et l'application de la loi.

Cette enquête récente met en évidence des dilemmes éthiques et remet en question l'efficacité du logiciel dans la prédiction des crimes.

Bien que le logiciel ait montré de légères variations dans la précision des prédictions selon les types de délits (par exemple, il a correctement prédit 0,6 % des vols ou des agressions aggravées contre 0,1 % des cambriolages), le constat général reste celui d'une sous-performance flagrante.

La réponse franche du capitaine de la police de Plainfield, David Guarino, met en lumière la réalité du terrain. "Pourquoi avons-nous acheté PredPol ? Nous voulions améliorer notre efficacité en matière de réduction de la criminalité", a-t-il déclaré.

"Je ne suis pas sûr qu'il y soit parvenu. Nous l'avons rarement, voire jamais, utilisé". Il a également indiqué que le service de police avait cessé de l'utiliser.

Le capitaine Guarino a suggéré que les fonds alloués à Geolitica - qui s'élevaient à un abonnement annuel de 120 000 euros et à un supplément de 15 000 euros pour la deuxième année - auraient pu être investis plus efficacement dans des programmes centrés sur la communauté.

Geolitica devrait cesser ses activités d'ici la fin de l'année.

Preuves attestant de la partialité de la police prédictive

La promesse d'une police prédictive reste alléchante, notamment parce que les forces de police sont de plus en plus sollicitées et que la qualité de la prise de décision de la police humaine est discréditée.

Les forces de police des États-Unis, du Royaume-Uni et de plusieurs pays européens, dont la France, font l'objet d'un examen minutieux en raison des préjugés qu'elles nourrissent à l'égard des groupes minoritaires.

Les membres de la Chambre des Lords et de la Chambre des Communes du Royaume-Uni demandent instamment une arrêt temporaire sur le déploiement de la technologie de reconnaissance faciale en direct par la police.

Cette décision a été prise après que le ministre de la police, Chris Philip, a discuté de la possibilité d'accorder aux forces de police l'accès à 45 millions d'images provenant de la base de données des passeports à des fins de reconnaissance faciale par la police. À ce jour, 65 parlementaires et 31 organisations de défense des droits et de l'égalité raciale s'opposent à l'utilisation des technologies de reconnaissance faciale dans les services de police.

Le groupe de pression Big Brother Watch a indiqué que 89% des alertes de reconnaissance faciale de la police britannique n'atteignent pas leur objectif, avec des résultats disproportionnés pour les groupes ethniques minoritaires et les femmes. Un essai de reconnaissance faciale mené en 2018 par la police métropolitaine de Londres a obtenu un résultat lamentable de taux de réussite d'environ 2%.

Comme Michael Birtwistle, de l'Institut Ada Lovelace, décriteLa précision et la base scientifique des technologies de reconnaissance faciale sont très contestées, et leur légalité est incertaine.

Aux États-Unis, un projet de collaboration entre l'université de Columbia, l'AI Now Institute et d'autres organismes a récemment analysé les litiges impliquant des algorithmes dans les salles d'audience américaines.

L'étude a révélé que les systèmes d'IA étaient souvent mis en œuvre à la hâte, sans contrôle approprié, principalement dans le but de réduire les coûts. Malheureusement, ces systèmes ont souvent donné lieu à des problèmes constitutionnels en raison de biais inhérents.

Au moins quatre hommes noirs ont été arrêtés et/ou emprisonnés à tort en raison de correspondances faciales erronées aux États-Unis. Parcs Nijeerfaussement accusé de vol à l'étalage et de délits routiers alors qu'il se trouvait à une trentaine de kilomètres des faits reprochés. Il a ensuite passé dix jours en prison et a dû payer des milliers de dollars de frais de justice.

Les Les auteurs de l'étude ont concluCes systèmes d'IA ont été mis en œuvre sans formation, soutien ou supervision significatifs, et sans aucune protection spécifique pour les bénéficiaires. Cela s'explique en partie par le fait qu'ils ont été adoptés pour réaliser des économies et une normalisation dans le cadre d'un modèle monolithique d'acquisition de technologies, qui prend rarement en compte les questions de responsabilité constitutionnelle".

La police prédictive peut encourager la prise de décision contre nature

Même lorsque la police prédictive est exacte, les humains doivent agir en fonction des prédictions, et c'est là que les choses se gâtent.

Lorsqu'un algorithme indique à la police qu'elle doit se rendre quelque part parce qu'un crime est commis ou risque de l'être, il est loin d'être impossible de penser que cela fausse la prise de décision.

Il existe quelques théories psychologiques de base qu'il serait judicieux de confronter lorsque l'on envisage le rôle de l'IA dans le maintien de l'ordre.

Tout d'abord, lorsqu'un algorithme informe la police d'une scène de crime probable, il l'incite potentiellement à envisager la situation sous l'angle de l'attente. Cela a pu jouer un rôle dans l'incident McDaniels : la police est arrivée sur les lieux en s'attendant à ce qu'un incident se produise, ce qui a déclenché une escalade des événements dans un environnement instable.

Ce phénomène est ancré dans le biais de confirmation, qui suggère qu'une fois que nous disposons d'un élément d'information, nous avons tendance à rechercher et à interpréter les informations ultérieures d'une manière qui s'aligne sur cette croyance initiale.

Lorsqu'un algorithme indique à une personne qu'un crime est susceptible de se produire, elle peut inconsciemment accorder plus d'importance aux indices qui confirment cette prédiction et négliger ceux qui la contredisent.

En outre, les algorithmes, en particulier ceux qui sont utilisés dans le cadre de fonctions officielles, peuvent être considérés comme faisant autorité en raison de leur nature informatique, et les agents peuvent leur accorder une confiance excessive.

Et puis il y a le risque de désengagement moral. Les agents peuvent rejeter la responsabilité de leurs actes sur l'algorithme, en pensant que c'est le logiciel qui a pris la décision, et non eux - ce qui est également très pertinent dans le domaine de la guerre.

Les débats ici sont parallèles à ceux qui entourent les L'utilisation de l'IA sur le champ de bataillequi pose des dilemmes similaires.

L'autorité imposée par l'IA peut entraîner un "déficit de responsabilité" où personne n'assume la responsabilité des erreurs commises par l'IA, comme l'ont souligné Kate Crawford et Jason Schultz dans un récent article de la revue Article JSTOR.

En définitive, d'après les données dont nous disposons actuellement, la police prédictive perpétue souvent les préjugés au lieu de les atténuer.

Lorsque les prévisions s'ajoutent aux décisions prises par l'homme, les conséquences peuvent être catastrophiques.