Alors que les conversations se multiplient autour des risques liés aux systèmes d'IA, nous ne pouvons pas ignorer la pression que la technologie exerce sur les réserves mondiales d'énergie et d'eau, qui sont déjà soumises à des contraintes.

Les projets complexes d'apprentissage automatique dépendent d'une constellation de technologies, notamment le matériel d'apprentissage (GPU) et le matériel d'hébergement et de déploiement des modèles d'IA.

Alors que des techniques et des architectures efficaces de formation à l'IA promettent de réduire la consommation d'énergie, le boom de l'IA ne fait que commencer, et les grandes entreprises technologiques augmentent leurs investissements dans les centres de données gourmands en ressources et dans la technologie du cloud.

Alors que la crise climatique s'aggrave, il est plus que jamais essentiel de trouver un équilibre entre les progrès technologiques et l'efficacité énergétique.

Défis énergétiques pour l'IA

La consommation d'énergie de l'IA a augmenté avec l'avènement d'architectures complexes et coûteuses en calcul, telles que les réseaux neuronaux.

Par exemple, GPT-4 serait basé sur 8 modèles avec 220 milliards de paramètres chacun, pour un total d'environ 1,76 trillion de paramètres. Inflection construit actuellement une grappe de 22 000 puces Nvidia haut de gammequi pourrait coûter environ $550 000 000 à un prix de détail approximatif de $25 000 par carte. Et cela ne concerne que les puces.

La formation de chaque modèle d'IA avancé nécessite d'immenses ressources, mais jusqu'à récemment, il était difficile de comprendre le coût réel du développement de l'IA.

A Étude 2019 de l'université du Massachusetts à Amherst a étudié la consommation de ressources associée aux approches des réseaux neuronaux profonds (DNN).

En règle générale, ces réseaux neuronaux nécessitent que les scientifiques des données conçoivent manuellement ou utilisent la recherche d'architecture neuronale (NAS) pour trouver et former un réseau neuronal spécialisé à partir de zéro pour chaque cas unique.

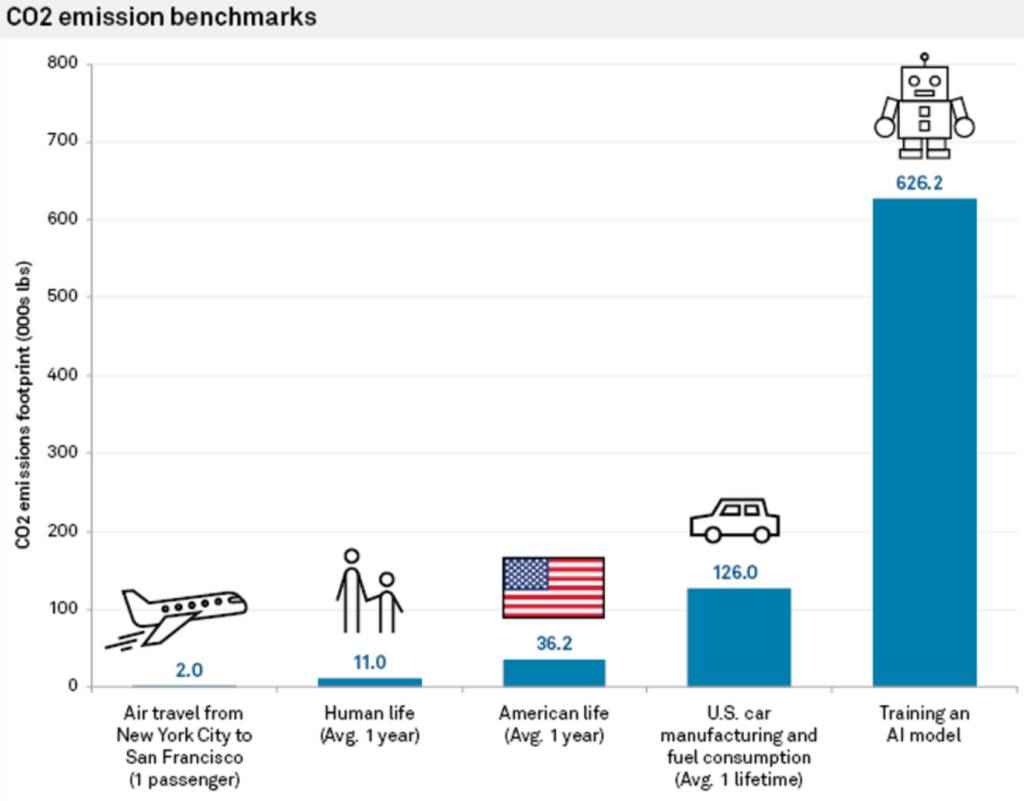

Cette approche est non seulement gourmande en ressources, mais elle a aussi une empreinte carbone importante. L'étude a révélé que la formation d'un seul grand réseau neuronal basé sur Transformer, construit à l'aide de NAS - un outil couramment utilisé dans la traduction automatique - générait environ 626 000 livres de dioxyde de carbone.

Cela équivaut approximativement aux émissions de gaz de 5 voitures pendant toute leur durée de vie.

Carlos Gómez-Rodríguez, informaticien à l'université de La Corogne, en Espagne, a commenté l'étude en ces termes : "Alors que beaucoup d'entre nous y ont probablement pensé de manière abstraite et vague, les chiffres montrent vraiment l'ampleur du problème", ajoutant : "Ni moi ni les autres chercheurs avec lesquels j'en ai discuté ne pensions que l'impact sur l'environnement était aussi important".

Les coûts énergétiques liés à la formation du modèle ne sont que des valeurs de référence, c'est-à-dire la quantité minimale de travail nécessaire pour rendre un modèle opérationnel.

Comme le dit Emma Strubell, doctorante à l'université du Massachusetts, "former un seul modèle est le minimum de travail que l'on puisse faire".

L'approche "une fois pour toutes" du MIT

Des chercheurs du MIT ont par la suite proposé une solution à ce problème : le L'approche "une fois pour toutes" (OFA).

Les chercheurs décrire le problème avec l'entraînement conventionnel des réseaux neuronaux : "La conception de réseaux neuronaux spécialisés pour chaque scénario est coûteuse en termes d'ingénierie et de calcul, que ce soit avec des méthodes humaines ou des NAS. Étant donné que ces méthodes doivent répéter le processus de conception du réseau et entraîner à nouveau le réseau conçu à partir de zéro pour chaque cas, leur coût total augmente de façon linéaire à mesure que le nombre de scénarios de déploiement augmente, ce qui entraînera une consommation d'énergie et des émissions de CO2 excessives."

Avec le paradigme OFA du MIT, les chercheurs forment un seul réseau neuronal polyvalent à partir duquel divers sous-réseaux spécialisés peuvent être créés. Le processus OFA ne nécessite pas de formation supplémentaire pour les nouveaux sous-réseaux, ce qui réduit les heures de GPU énergivores nécessaires à la formation des modèles et diminue les émissions de CO2.

Outre ses avantages environnementaux, l'approche de l'OFA apporte des améliorations substantielles en termes de performances. Lors de tests internes, les modèles créés à l'aide de l'approche OFA ont été jusqu'à 2,6 fois plus rapides sur les appareils de périphérie (appareils IoT compacts) que les modèles créés à l'aide de NAS.

L'approche OFA du MIT a été récompensée lors de la 4e édition du Low Power Computer Vision Challenge en 2019 - un événement annuel organisé par l'IEEE pour promouvoir la recherche sur l'amélioration de l'efficacité énergétique des systèmes de vision par ordinateur (CV).

C'est l'équipe du MIT qui a remporté la palme, avec les félicitations des organisateurs de l'événement : "Les solutions de ces équipes surpassent les meilleures solutions de la littérature".

Les 2023 Défi de la vision par ordinateur à faible consommation d'énergie reçoit actuellement des candidatures jusqu'au 4 août.

Le rôle de l'informatique en nuage dans l'impact environnemental de l'IA

Outre les modèles de formation, les développeurs ont besoin d'immenses ressources en nuage pour héberger et déployer leurs modèles.

Les grandes entreprises technologiques telles que Microsoft et Google augmentent leurs investissements dans les ressources en nuage d'ici à 2023 pour répondre à la demande croissante de produits liés à l'IA.

L'informatique en nuage et les centres de données qui y sont associés ont d'immenses besoins en ressources. Depuis 2016, estimations proposées que les centres de données dans le monde représentaient environ 1% à 3% de la consommation mondiale d'électricité, ce qui équivaut à la consommation d'énergie de certains petits pays.

L'empreinte hydrique des centres de données est également colossale. Les grands centres de données peuvent consommer des millions de litres d'eau par jour.

En 2020, il a été rapporté que les centres de données de Google en Caroline du Sud ont été autorisés à utiliser les technologies de l'information et de la communication (TIC). 549 millions de gallons d'eausoit près du double de la quantité utilisée deux ans auparavant. Un centre de données de 15 mégawatts peut consommer jusqu'à 360 000 gallons d'eau par jour.

En 2022, Google a divulgué que son parc mondial de centres de données a consommé environ 4,3 milliards de gallons d'eau. Ils soulignent toutefois que le refroidissement par eau est nettement plus efficace que d'autres techniques.

Les grandes entreprises technologiques ont toutes des plans similaires pour réduire leur utilisation des ressources, comme Google, qui a atteint son objectif de faire correspondre 100% de sa consommation d'énergie à des achats d'énergie renouvelable en 2017.

Le matériel d'IA de la prochaine génération s'inspire du cerveau humain

L'IA est immensément gourmande en ressources, alors que notre cerveau ne fonctionne qu'à l'aide d'un seul 12 watts de puissance - Une telle efficacité énergétique peut-elle être reproduite dans la technologie de l'IA ?

Même un ordinateur de bureau consomme plus de 10 fois plus d'énergie que le cerveau humain, et les modèles d'IA puissants nécessitent des millions de fois plus d'énergie. La mise au point d'une technologie d'IA capable de reproduire l'efficacité des systèmes biologiques transformerait complètement l'industrie.

Pour être juste envers l'IA, cette comparaison ne tient pas compte du fait que le cerveau humain a été "formé" au cours de millions d'années d'évolution. De plus, les systèmes d'IA et les cerveaux biologiques excellent dans des tâches différentes.

Néanmoins, la construction d'un matériel d'IA capable de traiter des informations avec une consommation d'énergie similaire à celle des cerveaux biologiques permettrait de créer des IA autonomes inspirées de la biologie et non couplées à des sources d'énergie encombrantes.

En 2022, une équipe de chercheurs de l'Institut indien de technologie de Bombay, a annoncé le développement d'une nouvelle puce d'intelligence artificielle inspirée du cerveau humain. La puce fonctionne avec des réseaux de neurones à pointes (SNN), qui imitent le traitement des signaux neuronaux des cerveaux biologiques.

Le cerveau comprend 100 milliards de petits neurones reliés à des milliers d'autres neurones par des synapses, transmettant des informations par des schémas coordonnés de pointes électriques. Les chercheurs ont construit des neurones artificiels à très faible consommation d'énergie, en équipant les SNN de courant à effet tunnel de bande à bande (BTBT).

"Avec le BTBT, le courant à effet tunnel quantique charge le condensateur avec un courant très faible, ce qui signifie que moins d'énergie est nécessaire", a expliqué Udayan Ganguly de l'équipe de recherche.

Selon le professeur Ganguly, par rapport aux neurones de pointe existants mis en œuvre dans les SNN matériels, leur approche permet d'obtenir "une énergie par pic 5 000 fois plus faible pour une zone similaire et une puissance en veille 10 fois plus faible pour une zone et une énergie par pic similaires".

Les chercheurs ont démontré avec succès leur approche dans un modèle de reconnaissance vocale inspiré du cortex auditif du cerveau. Les SNN pourraient améliorer les applications sur les appareils compacts tels que les téléphones mobiles et les capteurs IoT.

L'équipe a pour objectif de développer un "noyau neurosynaptique à très faible consommation d'énergie et un mécanisme d'apprentissage en temps réel sur la puce, qui sont essentiels pour les réseaux neuronaux autonomes inspirés par la biologie".

Les incidences de l'IA sur l'environnement sont souvent négligées, mais la résolution de problèmes tels que la consommation d'énergie des puces d'IA ouvrira également de nouvelles voies d'innovation.

Si les chercheurs peuvent modeler la technologie de l'IA sur les systèmes biologiques, qui sont exceptionnellement économes en énergie, cela permettrait de développer des systèmes d'IA autonomes qui ne dépendent pas d'une alimentation électrique abondante et de la connectivité des centres de données.