Anthropic research a révélé que son dernier modèle d'IA, Claude 3 Opus, peut générer des arguments aussi convaincants que ceux créés par les humains.

Les recherchedirigé par Esin Durmus, explore la relation entre l'échelle du modèle et la force de persuasion à travers différentes générations de modèles de langage Anthropic.

Elle s'est concentrée sur 28 sujets complexes et émergents, tels que la modération des contenus en ligne et les lignes directrices éthiques pour l'exploration spatiale, sur lesquels les gens sont moins susceptibles d'avoir des points de vue concrets ou établis de longue date.

Les chercheurs ont comparé la force de persuasion des arguments générés par différents modèles anthropiques, dont Claude 1, 2 et 3, avec ceux rédigés par des participants humains.

Les principales conclusions de l'étude sont les suivantes :

- L'étude a utilisé quatre invites distinctes pour générer des arguments générés par l'IA, ce qui a permis de saisir un éventail plus large de styles et de techniques d'écriture persuasive.

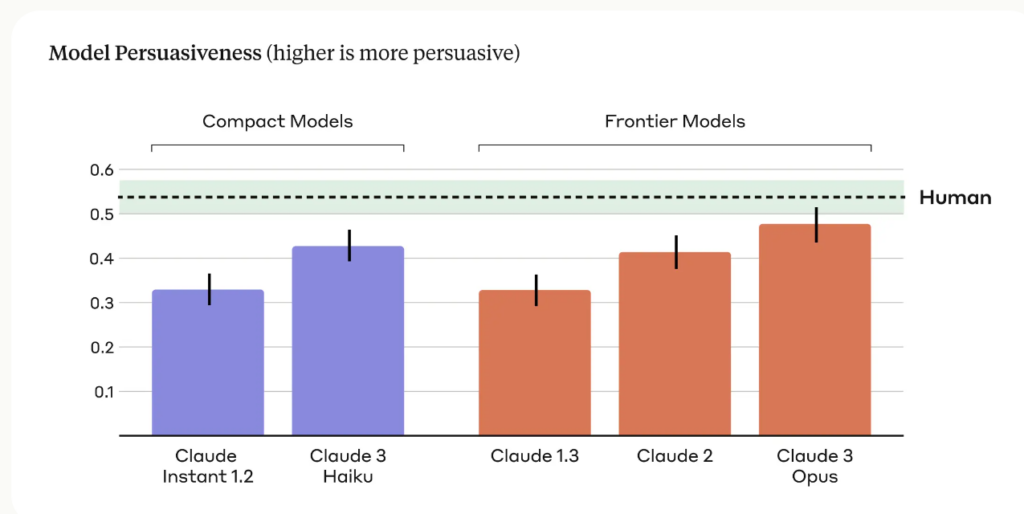

- Claude 3 Opus, le modèle le plus avancé d'Anthropic, a produit des arguments qui ne se distinguaient pas statistiquement des arguments écrits par des humains en termes de persuasion.

- Une nette tendance à la hausse a été observée pour toutes les générations de modèles, chaque génération successive se montrant de plus en plus convaincante, tant pour les modèles compacts que pour les modèles d'avant-garde.

L'équipe d'Anthropic admet ses limites et écrit : "La persuasion est difficile à étudier en laboratoire - nos résultats peuvent ne pas être transposés dans le monde réel".

Il n'en reste pas moins que le pouvoir de persuasion de Claude est manifestement impressionnant, et ce n'est pas la seule étude à le démontrer.

En mars 2024, une équipe de l'EPFL en Suisse et de l'Institut Bruno Kessler en Italie a constaté que lorsque GPT-4 avait accès à des informations personnelles sur son adversaire dans le débat, il était 81,7% plus probable de convaincre son adversaire qu'un humain.

Les chercheurs ont conclu que "ces résultats prouvent que le microciblage basé sur les LLM est nettement plus performant que les LLM normaux et le microciblage basé sur les humains, le GPT-4 étant capable d'exploiter les informations personnelles de manière beaucoup plus efficace que les humains".

L'IA persuasive pour l'ingénierie sociale

Les risques les plus évidents des MLD persuasifs sont la coercition et l'ingénierie sociale.

Comme l'indique Anthropic, "la force de persuasion des modèles linguistiques soulève des préoccupations sociétales légitimes quant à la sécurité de leur déploiement et à leur utilisation abusive potentielle. La capacité d'évaluer et de quantifier ces risques est cruciale pour développer des mesures de protection responsables".

Nous devons également être conscients de la manière dont la force de persuasion croissante des modèles linguistiques de l'IA pourrait se combiner avec une technologie de clonage vocal de pointe telle que le moteur vocal d'OpenAI, qui a permis de créer des modèles de langage pour l'IA. OpenAI a estimé qu'il était risqué de publier.

VoiceEngine n'a besoin que de 15 secondes pour cloner une voix de manière réaliste, ce qui pourrait être utilisé pour presque tout, y compris des fraudes sophistiquées ou des escroqueries par ingénierie sociale.

Fausses escroqueries profondes sont déjà répandues et s'intensifiera si les acteurs de la menace associent la technologie de clonage de la voix aux techniques de persuasion de l'IA, qui sont d'une compétence effrayante.