L'entreprise de logiciels RH Lattice, fondée par Jack Altman, le frère de Sam Altman, a été la première à fournir aux travailleurs numériques des dossiers officiels, mais elle a annulé cette initiative trois jours plus tard.

Sarah Franklin, PDG de Lattice annoncé sur LinkedIn que Lattice "est entrée dans l'histoire en devenant la première entreprise à prendre la tête de l'emploi responsable des "travailleurs numériques" de l'IA en créant un dossier numérique de l'employé pour les régir avec transparence et responsabilité".

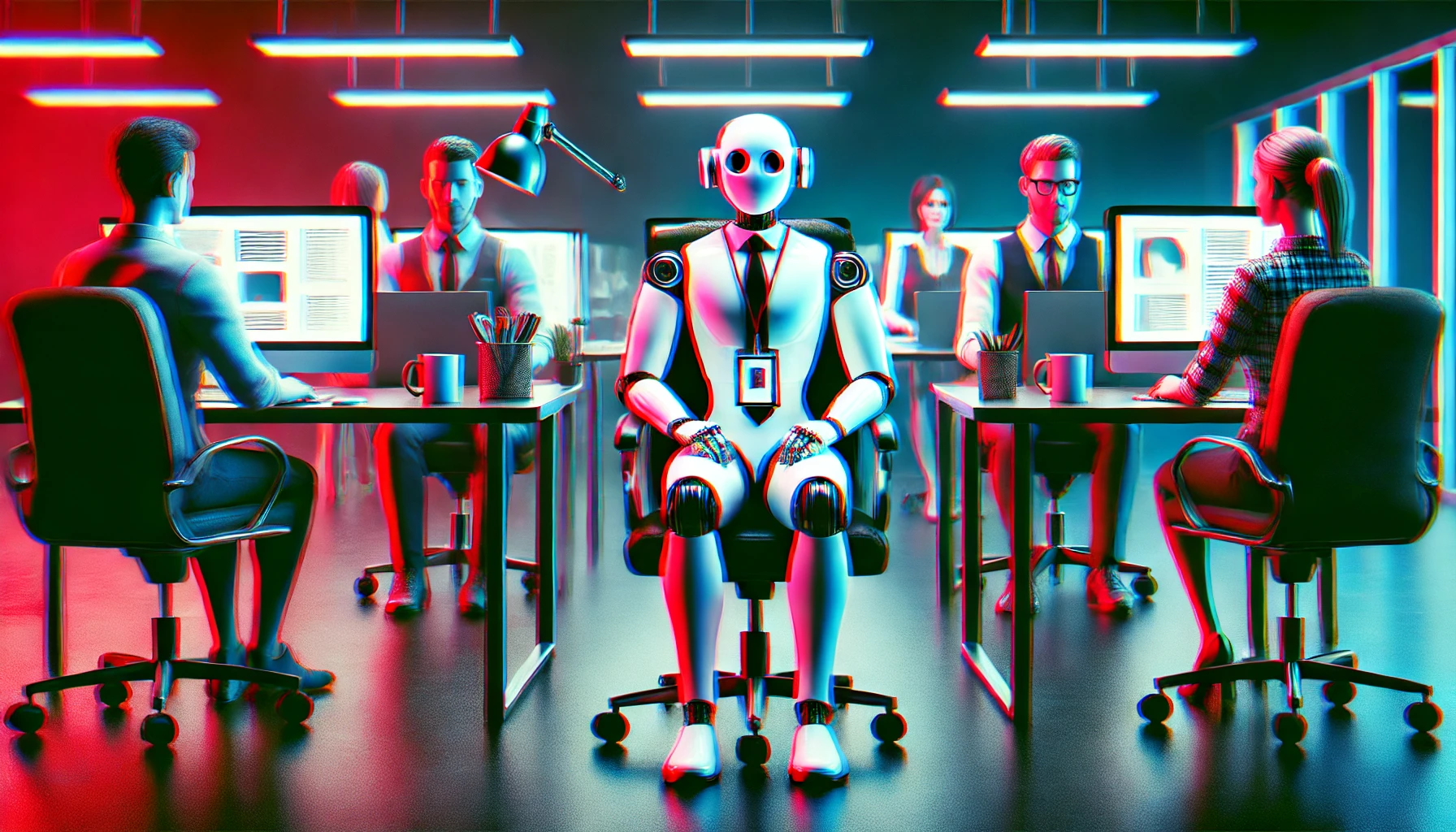

Selon M. Franklin, les "travailleurs numériques" seront intégrés, formés et se verront assigner des objectifs, des mesures de performance, un accès approprié aux systèmes et même un responsable.

Si vous pensez que cette tendance à anthropomorphiser l'IA va trop loin et qu'elle est mal perçue face aux pertes d'emplois qui se profilent, vous n'êtes pas le seul.

La réaction de la communauté en ligne a été rapide, y compris de la part de personnes travaillant dans le secteur de l'intelligence artificielle.

Sawyer Middeleer, chef du personnel de la plateforme de vente d'IA Aomni, a commenté l'article en déclarant : "Cette stratégie et ce message manquent cruellement leur cible, et je le dis en tant que créateur d'une entreprise d'IA. Traiter les agents d'IA comme des employés ne respecte pas l'humanité de vos véritables employés. Pire encore, cela implique que vous considérez les humains simplement comme des "ressources" à optimiser et à mesurer par rapport aux machines."

Ed Zitron, PDG de la société de relations avec les médias technologiques EZPR, a demandé à M. Franklin : "En cas d'effort de syndicalisation chez Lattice, ces employés de l'IA seront-ils autorisés à voter ?"

Lattice a rapidement compris que le monde n'était peut-être pas encore prêt pour les "employés numériques". Trois jours seulement après l'annonce, l'entreprise déclare qu'elle a annulé le projet.

Sont-ils des travailleurs ?

Il est de plus en plus facile d'humaniser les modèles d'IA et les robots. Ils parlent comme nous, émettent des émotions et sont souvent plus empathiques que nous.

Mais sont-ils conscients ou sensibles au point que nous devrions envisager de leur accorder des droits de "travailleurs" ? Lattice a peut-être simplement essayé de devancer cette question inévitable, bien qu'un peu maladroitement.

Claude 3 ingénieurs surpris par l'Opus lorsqu'il a révélé une certaine conscience de soi au cours des tests. Google a licencié l'un de ses ingénieurs en 2022 après qu'il eut déclaré que son modèle d'IA était sensible, et les chercheurs affirment que GPT-4 a passé le test de Turing.

La question de savoir si les modèles d'IA sont réellement conscients ou non ne sera peut-être même pas déterminante pour savoir si les employés numériques bénéficieront de droits à l'avenir.

En avril, des chercheurs a publié une étude intéressante dans la revue Neuroscience of Consciousness. Ils ont demandé à 300 citoyens américains s'ils pensaient que le ChatGPT était conscient et qu'il avait des expériences subjectives telles que des sentiments et des sensations. Plus de deux tiers des personnes interrogées ont répondu par l'affirmative, même si la plupart des experts ne sont pas d'accord.

Les chercheurs ont constaté que plus les personnes utilisaient fréquemment des outils tels que ChatGPT, plus elles étaient susceptibles de leur attribuer un certain niveau de conscience.

Notre première réaction automatique peut être de rechigner à l'idée qu'un "collègue" de l'IA puisse bénéficier des droits des travailleurs. Cette étude suggère que plus nous interagissons avec l'IA, plus nous sommes susceptibles de sympathiser avec elle et d'envisager de l'accueillir dans l'équipe.