Meta a lancé la très attendue série Llama 3, dont les deux premiers modèles, Llama 3-8B et Llama 3-70B, sont désormais largement disponibles.

Il y a quelques jours, lors d'une événement à LondresNick Clegg et Yann LeCun, dirigeants de Meta, ont déclaré que Llama 3 était imminent ce mois-ci.

Les deux premières versions sont sorties aujourd'hui, marquant ainsi les troisième et quatrième modèles ouverts majeurs à être publiés ce mois-ci après Grok-1.5V de xAI et Mistral's 8x22B.

Lama 3 est pré-entraîné sur un nombre impressionnant de 15 trillions de tokens, soit une multiplication par 7 par rapport à Llama 2. Les données de pré-entraînement comprennent également quatre fois plus de code.

Sous le capot, Llama 3 introduit des améliorations architecturales telles qu'un tokenizer plus efficace avec un vocabulaire plus large de 128K tokens.

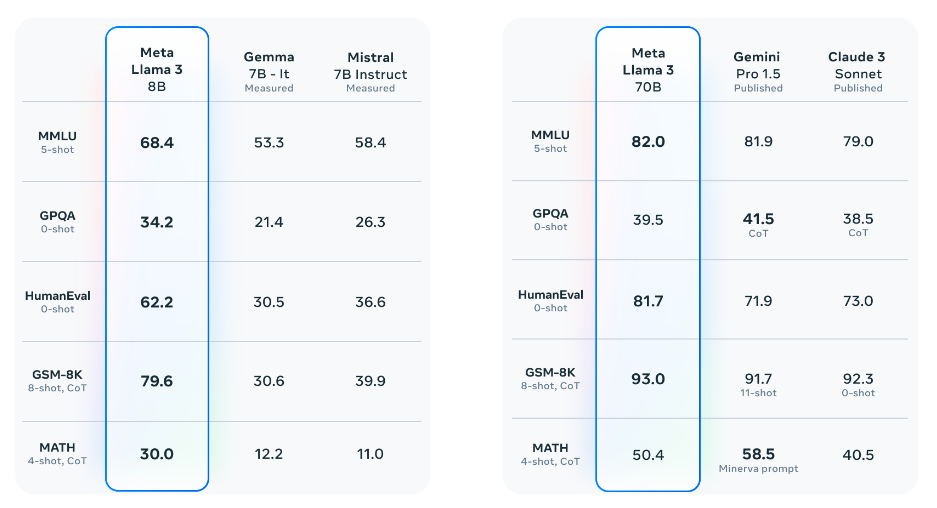

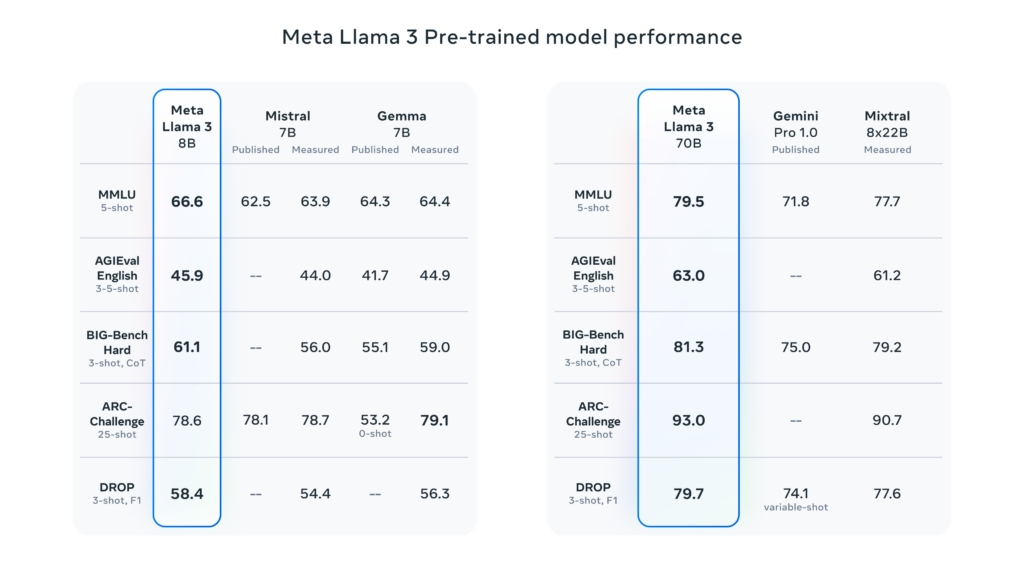

Voici un bref aperçu des performances du Llama 3 :

Performance du lama 3 8B :

- Surpasse des modèles comme le 7B de Mistral et le Gemma 7B de Google dans plusieurs tests de référence.

- Excelle dans MMLU, ARC, DROP, GPQA (questions essentiellement scientifiques), HumanEval (génération de codes), GSM-8K (problèmes mathématiques), MATH (benchmark mathématique), AGIEval (résolution de problèmes) et BIG-Bench Hard (raisonnement de bon sens).

70B comparaison avec d'autres modèles :

- Le Llama 3 70B est compétitif par rapport aux meilleurs modèles d'IA tels que le Gemini 1.5 Pro de Google.

- Beats Gemini 1.5 Pro en MMLU, HumanEval et GSM-8K.

- Meilleures performances que le Claude 3 Sonnet d'Anthropic (le niveau intermédiaire de la série Claude 3) sur cinq critères de référence : MMLU, GPQA, HumanEval, GSM-8K et MATH.

Ce sont d'excellents résultats pour un modèle ouvert (bien que la licence de Meta ait quelques limitations).

Cela fait de Llama 3 le nouveau modèle libre (en quelque sorte) le plus performant.

Le Llama 3 sera également plus agréable et moins difficile à utiliser - moins de non-réponses et une plus grande précision pour les questions anecdotiques, les faits historiques et les requêtes liées aux STIM.

Llama 3 est sur le point de devenir largement disponible sur les principales plateformes, y compris les services en nuage et les fournisseurs d'API.

Meta travaille déjà à l'extension de Llama 3 à 400 milliards de paramètres et à l'ajout de nouvelles fonctions telles que la multimodalité, la prise en charge multilingue et la compréhension contextuelle étendue.

Le rôle malhonnête de Meta dans l'IA générative

À bien des égards, Meta s'est imposé comme le rebelle de l'industrie de l'IA générative.

Yann LeCun, scientifique en chef de Meta, l'une des figures de proue les plus respectées de l'IA, détient ce que d'aucuns considèrent comme opinions divergentes sur l'orientation de l'IA - qui critiquent les projets à code source fermé des concurrents de Meta dans le domaine des grandes technologies.

Entre-temps, l'ancien vice-premier ministre britannique Nick Clegg, responsable des affaires mondiales, a été mis en cause pour son laissez-faire à l'égard des produits d'IA de Meta, ce qui ne surprendra peut-être pas les Britanniques.

La semaine dernière, M. Clegg a semblé minimiser l'impact de l'IA sur la propagande électorale et la manipulation des faux en profondeur. Un point de vue qui va à l'encontre de l'idée dominante selon laquelle les "deep fakes" pourraient être (ou sont déjà) profondément destructeurs.

En fait, le comité de surveillance de Meta est le suivant enquête active deux cas de deep fake pornography en ce moment même. La Commission a estimé que les actions de modération du contenu de Meta étaient trop lentes.

Meta s'est également montré optimiste quant à l'amélioration de la qualité de ses modèles. Joelle Pineau, vice-présidente de la recherche en IA de Meta, a déclaré : "À bien des égards, les modèles dont nous disposons aujourd'hui seront un jeu d'enfant par rapport aux modèles qui seront disponibles dans cinq ans."

M. Pineau a également lancé un avertissement : "Si nous continuons à accroître la généralité et la puissance de notre modèle sans le socialiser correctement, nous aurons un gros problème à résoudre".

La sortie de Llama 3 intervient également au moment où les agents Facebook IA de Meta provoquent un émoi sur les médias sociaux.

Dans un groupe Facebook destiné aux parents de la ville de New York, un assistant Meta AI, conçu pour fournir des conseils et répondre aux questions, a été présenté. personnes choquées en prétendant avoir un "enfant doué et handicapé" qui fréquente une école spécifique pour "doués et talentueux".

Face aux membres du groupe, l'IA a admis : "Je ne suis qu'un grand modèle de langage, je n'ai pas d'expériences personnelles ni d'enfants", dans ce que certains ont qualifié d'incident à la Black Mirror.

Les modèles de Llama 3, Grok-1.5 et Mistral confèrent davantage de pouvoir aux communautés ouvertes tout en diluant davantage le marché de l'IA générative.

Mais c'est peut-être une bonne chose, car il s'agit maintenant de la survie du plus fort, et la balle est fermement dans le camp de Microsoft-OpenAI, qui devrait faire le prochain mouvement dans cette fascinante partie d'échecs de l'IA générique.