Les chercheurs de Google ont mis au point une technique appelée Infini-attention, qui permet aux LLM de traiter des textes infiniment longs sans augmenter les besoins en calcul et en mémoire.

L'architecture du transformateur d'un LLM est ce qui lui permet d'accorder de l'attention à tous les jetons d'une invite. Le produit point complexe et les multiplications matricielles qu'il effectue sont d'une complexité quadratique.

Cela signifie qu'en doublant le nombre de jetons dans votre invite, vous aurez besoin de quatre fois plus de mémoire et de puissance de traitement. C'est la raison pour laquelle il est si difficile de faire des LLM avec des grandes fenêtres contextuelles sans que les exigences en matière de mémoire et de calcul ne montent en flèche.

Dans un LLM "standard", les informations au début du contenu de l'invite sont perdues une fois que l'invite devient plus grande que la fenêtre contextuelle. La méthode de Google document de recherche explique comment Infini-attention peut conserver des données au-delà de la fenêtre contextuelle.

Google présente Leave No Context Behind : Transformateurs de contexte infini efficaces avec Infini-attention

Le modèle 1B qui a été affiné sur des instances de passkey d'une longueur de séquence allant jusqu'à 5K résout le problème de la longueur de 1Mhttps://t.co/zyHMt3inhi pic.twitter.com/ySYEMET9Ef

- Aran Komatsuzaki (@arankomatsuzaki) 11 avril 2024

Comment fonctionne Infini-attention ?

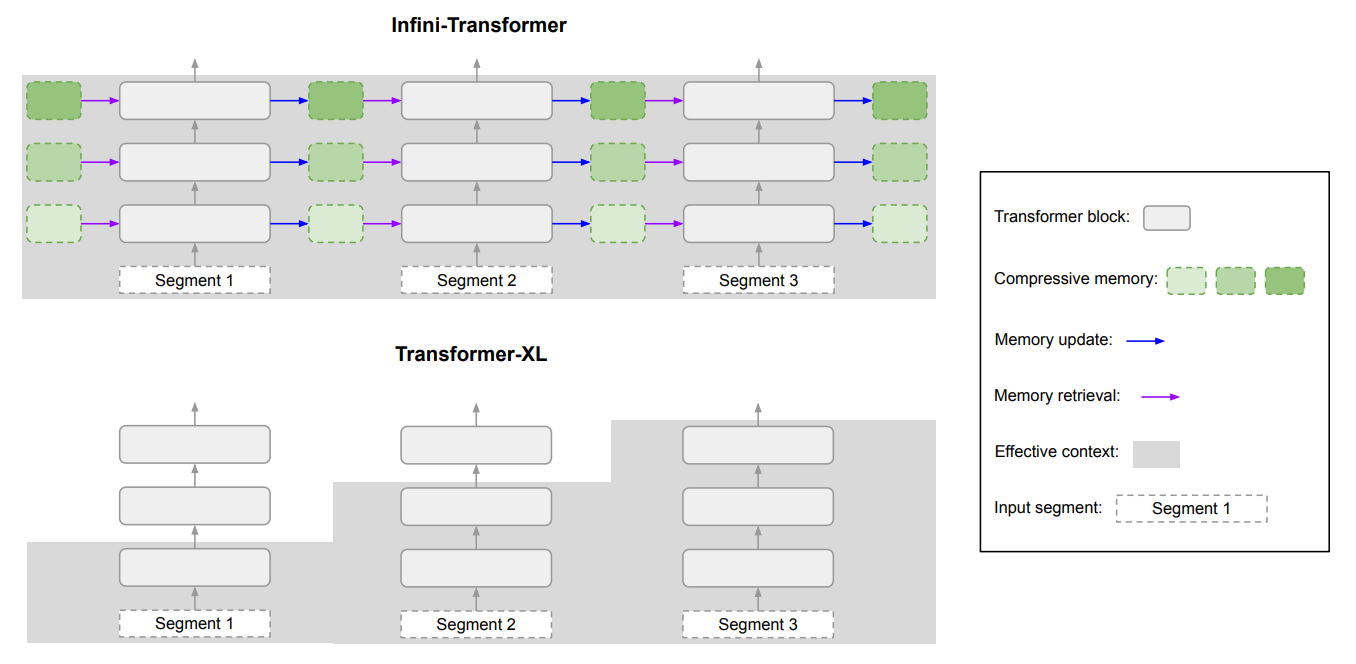

L'infini-attention combine des techniques de mémoire compressive avec des mécanismes d'attention modifiés, de sorte que les informations pertinentes plus anciennes ne sont pas perdues.

Une fois que l'invite d'entrée dépasse la longueur de contexte du modèle, la mémoire compressive stocke l'information dans un format compressé au lieu de la rejeter.

Cela permet de stocker des informations plus anciennes, moins immédiatement pertinentes, sans que les besoins en mémoire et en calcul n'augmentent indéfiniment au fur et à mesure que les données augmentent.

Au lieu d'essayer de retenir toutes les anciennes informations, la mémoire compressive d'Infini-attention pèse et résume les informations jugées pertinentes et dignes d'être retenues.

Infini-attention reprend alors un mécanisme d'attention "vanille", mais réutilise les états de valeur clé (KV) de chaque segment ultérieur du modèle au lieu de les rejeter.

Voici un diagramme qui montre la différence entre Infini-attention et un autre modèle de contexte étendu, Transformer XL.

Le résultat est un LLM qui accorde une attention locale aux données d'entrée récentes, mais qui contient également des données historiques compressées et distillées en continu auxquelles il peut accorder une attention à long terme.

L'article indique que "cette modification subtile mais essentielle de la couche d'attention permet aux LLM de traiter des contextes infiniment longs avec des ressources limitées en termes de mémoire et de calcul".

Quelle est sa qualité ?

Google a effectué des tests d'évaluation comparative en utilisant des modèles Infini-attention à 1B et 8B paramètres plus petits. Ceux-ci ont été comparés à d'autres modèles de contexte étendu tels que Transformer-XL et Memorizing Transformers.

Le transformateur Infini-Transformer a obtenu des scores de perplexité nettement inférieurs à ceux des autres modèles lors du traitement de contenus à contexte long. Un score de perplexité inférieur signifie que le modèle est plus sûr de ses prédictions de sortie.

Dans les tests de "récupération de clés", les modèles Infini-attention ont systématiquement trouvé le nombre aléatoire caché dans un texte comportant jusqu'à 1 million de mots.

D'autres modèles parviennent souvent à récupérer la clé vers la fin de la saisie, mais peinent à la trouver au milieu ou au début d'un long contenu. Infini-attention n'a eu aucun problème avec ce test.

Les tests d'étalonnage sont très techniques, mais l'essentiel est qu'Infini-attention a surpassé les modèles de base pour résumer et traiter de longues séquences tout en maintenant le contexte sur des périodes prolongées.

De manière significative, il a conservé cette capacité de rétention supérieure tout en nécessitant 114 fois moins de mémoire.

Les résultats de l'analyse comparative ont convaincu les chercheurs qu'Infini-attention pouvait être mis à l'échelle pour traiter des séquences d'entrée extrêmement longues tout en limitant les ressources de mémoire et de calcul.

La nature "plug-and-play" d'Infini-attention signifie qu'il pourrait être utilisé pour le pré-entraînement continu et le réglage fin des modèles Transformer existants. Cela permettrait d'étendre efficacement leurs fenêtres contextuelles sans nécessiter un réentraînement complet du modèle.

Les fenêtres contextuelles continueront de croître, mais cette approche montre qu'une mémoire efficace peut être une meilleure solution qu'une grande bibliothèque.