L'armée américaine tente d'intégrer des chatbots dans sa planification stratégique, mais dans le cadre d'une simulation de jeu de guerre basée sur le célèbre jeu vidéo Starcraft II.

Le présent étudedirigée par le laboratoire de recherche de l'armée américaine, analyse les stratégies GPT-4 Turbo et GPT-4 Vision d'OpenAI sur le champ de bataille.

Cela fait partie de l'initiative de l'OpenAI collaboration avec le ministère de la défense (DOD) à la suite de la mise en place de la Groupe de travail sur l'IA générative l'année dernière.

L'utilisation de l'IA sur le champ de bataille est vivement débattu, avec un une étude similaire récente sur les jeux de guerre utilisant l'IA qui a constaté que les LLM tels que GPT-3.5 et GPT-4 ont tendance à intensifier les tactiques diplomatiques, aboutissant parfois à une guerre nucléaire.

Cette nouvelle recherche de l'armée américaine a utilisé Starcraft II pour simuler un scénario de champ de bataille impliquant un nombre limité d'unités militaires.

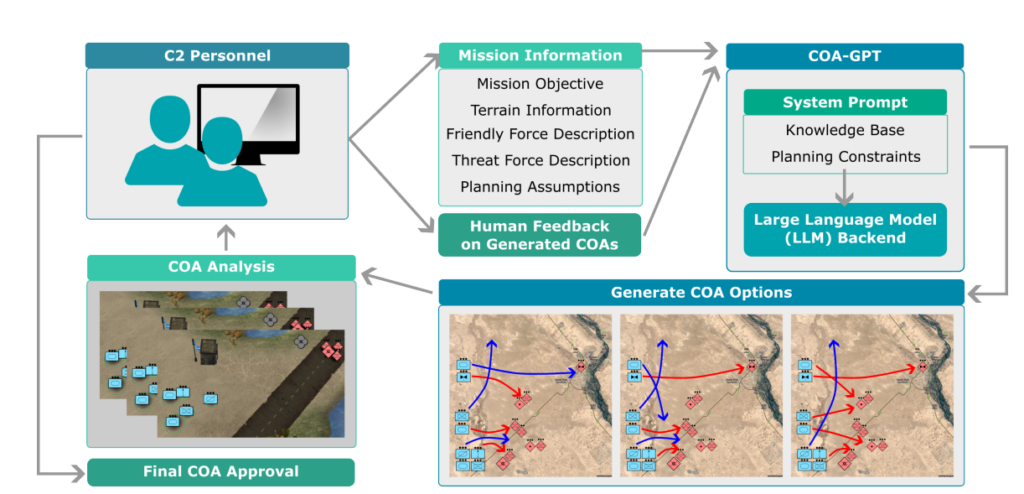

Les chercheurs ont baptisé ce système "COA-GPT", COA étant l'abréviation du terme militaire "Courses of Action", qui décrit essentiellement les tactiques militaires.

COA-GPT a assumé le rôle d'assistant du commandant militaire, chargé d'élaborer des stratégies pour anéantir les forces ennemies et s'emparer des points stratégiques.

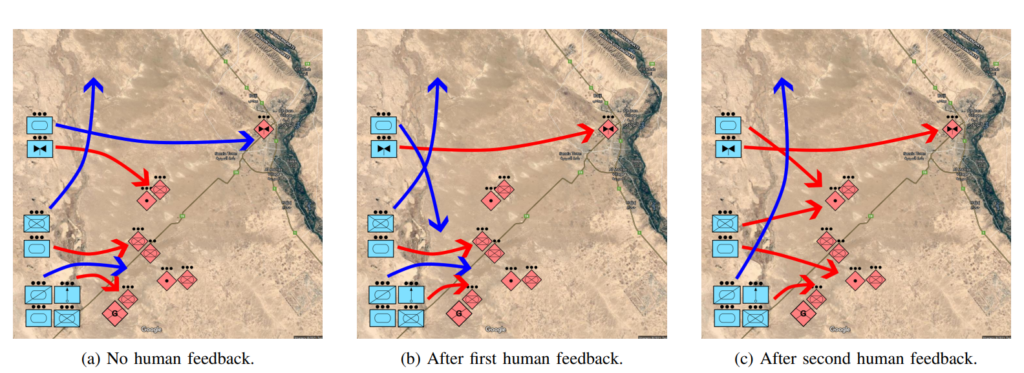

Les chercheurs notent que l'ACO traditionnelle est notoirement lente et exigeante en main-d'œuvre. COA-GPT prend des décisions en quelques secondes tout en intégrant le retour d'information humain dans le processus d'apprentissage de l'IA.

COA-GPT surpasse les autres méthodes, mais cela a un coût

COA-GPT a démontré une performance supérieure aux méthodes existantes, dépassant les méthodes existantes dans la génération de COA stratégiques, et pourrait s'adapter à un retour d'information en temps réel.

Cependant, il y avait des lacunes. Plus particulièrement, l'ACO-GPT a subi des pertes plus importantes dans l'accomplissement des objectifs de la mission.

L'étude précise : "Nous observons que les modèles COA-GPT et COA-GPT-V, même lorsqu'ils sont améliorés par un retour d'information humain, entraînent un plus grand nombre de pertes au sein des forces amies que les autres modèles de référence".

Cela décourage-t-il les chercheurs ? Apparemment non.

L'étude précise : "En conclusion, COA-GPT représente une approche transformatrice des opérations militaires de C2, facilitant une prise de décision plus rapide et plus agile et maintenant un avantage stratégique dans la guerre moderne".

Il est inquiétant qu'un système d'IA qui a causé plus de pertes inutiles que le système de référence soit défini comme une "approche transformatrice".

La DOD a déjà identifié d'autres pistes pour explorer les utilisations militaires de l'IA, mais des inquiétudes subsistent quant à l'état de préparation de la technologie et à ses implications éthiques.

Par exemple, qui est responsable lorsque des militaires Les applications de l'IA tournent mal? Les développeurs ? Le responsable ? Ou quelqu'un d'autre ?

Des systèmes de guerre IA sont déjà déployés en Ukraine et dans le conflit israélo-palestinien, mais ces questions n'ont pas encore été testées.

Espérons qu'il en restera ainsi.