Les humains peuvent-ils apprendre à détecter de manière fiable les contrefaçons générées par l'IA ? Quel est leur impact sur notre niveau cognitif ?

Le système Sora d'OpenAI a récemment annoncé une nouvelle vague de médias synthétiques alimentés par l'IA. Il ne faudra sans doute pas attendre longtemps avant que toute forme de média réaliste ne se mette en place. - audio, vidéo ou image - peut être générée en quelques secondes à l'aide de messages-guides.

Ces systèmes d'IA devenant de plus en plus performants, nous devrons développer de nouvelles compétences en matière de pensée critique afin de séparer la vérité de la fiction.

Jusqu'à présent, les efforts de Big Tech pour ralentir ou arrêter les deep fakes n'ont guère abouti qu'à un sentiment, non pas par manque de conviction, mais parce que le contenu de l'IA est tellement réaliste.

Cela signifie que difficile à détecter au niveau du pixeltandis que d'autres signaux, comme les métadonnées et les filigranes, ont leurs faiblesses.

En outre, même si les contenus générés par l'IA pouvaient être détectés à grande échelle, il est difficile de distinguer les contenus authentiques et intentionnels de ceux qui visent à diffuser des informations erronées.

Une solution possible consiste à confier le contenu à des réviseurs humains et à utiliser des "notes de la communauté" (informations jointes au contenu, souvent visibles sur X). Cependant, cela implique parfois une interprétation subjective et risque d'entraîner un étiquetage incorrect.

Par exemple, dans le Conflit israélo-palestinienNous avons été témoins d'images troublantes qualifiées de réelles alors qu'elles étaient fausses et vice-versa.

Lorsqu'une image réelle est étiquetée comme fausse, cela peut créer une 'dividende du menteurLe "syndrome de l'homme de la rue", où quelqu'un ou quelque chose peut balayer la vérité du revers de la main en la qualifiant d'imposture.

Ainsi, en l'absence de méthodes techniques permettant d'empêcher les contrefaçons profondes, que pouvons-nous faire ?

Et dans quelle mesure les "deep fakes" ont-ils un impact sur notre prise de décision et notre psychologie ?

Par exemple, lorsque les gens sont exposés à de fausses images politiques, cela a-t-il un impact tangible sur leur comportement électoral ?

Jetons un coup d'œil à quelques études qui évaluent précisément cette question.

Les contrefaçons profondes influencent-elles nos opinions et nos états psychologiques ?

Une étude en 2020L'étude "Deepfakes and Disinformation : Exploring the Impact of Synthetic Political Video on Deception, Uncertainty, and Trust in News" (Exploration de l'impact des vidéos politiques synthétiques sur la tromperie, l'incertitude et la confiance dans les informations), a étudié la manière dont les vidéos truquées influencent la perception du public, notamment en ce qui concerne la confiance dans les informations partagées sur les médias sociaux.

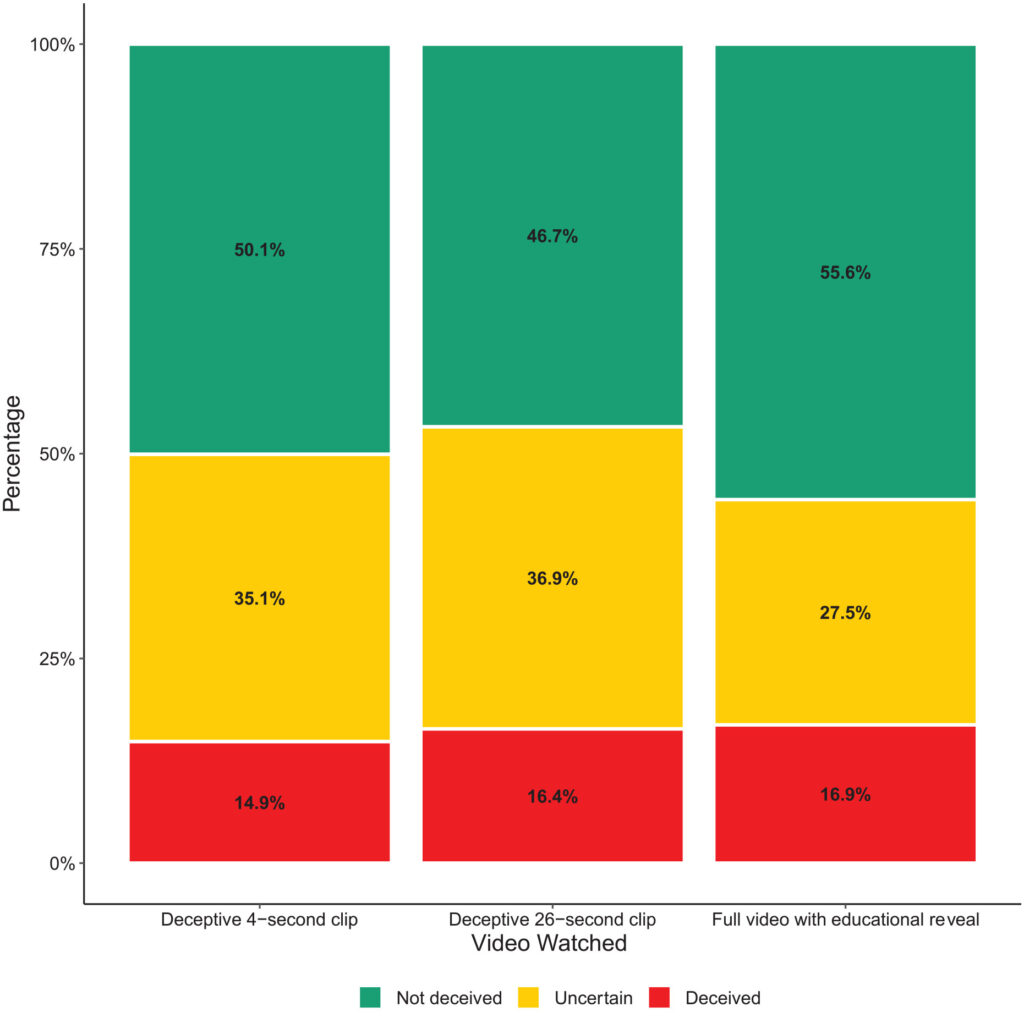

La recherche a consisté en une expérience à grande échelle avec 2 005 participants du Royaume-Uni, conçue pour mesurer les réactions à différents types de fausses vidéos de l'ancien président américain Barack Obama.

Les participants ont été choisis au hasard pour visionner l'une des trois vidéos :

- Un clip de 4 secondes montrant Obama faisant une déclaration surprenante sans aucun contexte.

- Un clip de 26 secondes qui comportait quelques indices sur la nature artificielle de la vidéo, mais qui était surtout trompeur.

- Une vidéo complète avec une "révélation éducative" où la nature artificielle du deep fake est explicitement révélée, avec Jordan Peele expliquant la technologie derrière le deep fake.

Principales conclusions

L'étude a exploré trois domaines clés :

- Tromperie: L'étude n'a trouvé que peu de preuves que les participants croyaient aux fausses déclarations dans les simulacres profonds. Le pourcentage de participants qui ont été trompés par les fausses déclarations était relativement faible dans tous les groupes de traitement.

- Incertitude: Cependant, l'un des principaux résultats a été l'augmentation de l'incertitude parmi les spectateurs, en particulier ceux qui ont vu les clips les plus courts et les plus trompeurs. Environ 35,1% des participants qui ont regardé le clip de 4 secondes et 36,9% de ceux qui ont vu le clip de 26 secondes ont déclaré avoir des doutes quant à l'authenticité de la vidéo. En revanche, seuls 27,5% de ceux qui ont visionné la vidéo éducative complète ont eu ce sentiment.

- La confiance dans l'information: Cette incertitude a eu un impact négatif sur la confiance des participants dans les informations diffusées sur les médias sociaux. Ceux qui ont été exposés aux images trompeuses ont montré des niveaux de confiance plus faibles que ceux qui ont vu la révélation éducative.

Cela montre que l'exposition à de fausses images profondes entraîne une incertitude à plus long terme.

Au fil du temps, les images truquées peuvent affaiblir la confiance dans toutes les informations, y compris la vérité.

Des résultats similaires ont été obtenus par un étude plus récente de 2023L'étude a également conclu que les images truquées ont des effets à long terme.

Les gens "se souviennent" d'un contenu falsifié après y avoir été exposés

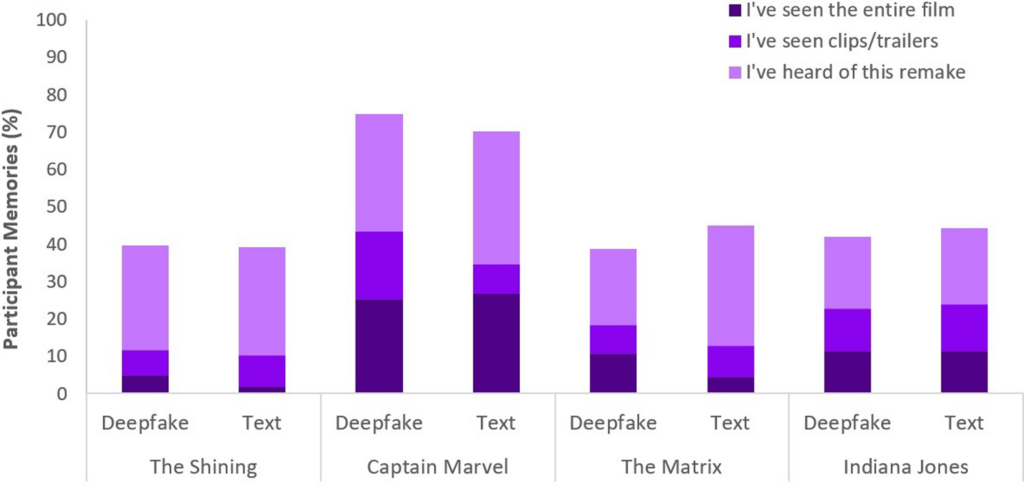

Menée auprès de 436 participants, l'étude Face/Off s'est intéressée à l'influence que peuvent avoir les faux sur nos souvenirs de films.

Les participants ont pris part à une enquête en ligne destinée à examiner leurs perceptions et leurs souvenirs des remakes de films réels et imaginaires.

Le cœur de l'enquête consistait à présenter aux participants six titres de films, dont quatre remakes réels et deux fictifs.

MLes films ont été randomisés et présentés sous deux formes : la moitié des films ont été présentés par de courtes descriptions textuelles, et l'autre moitié a été associée à de brefs clips vidéo.

Les remakes de films fictifs consistaient en des versions de "The Shining", "The Matrix", "Indiana Jones" et "Captain Marvel", accompagnées de descriptions affirmant faussement la participation d'acteurs de premier plan à ces remakes inexistants.

Par exemple, on a parlé aux participants d'un faux remake de "The Shining" avec Brad Pitt et Angelina Jolie, qui n'a jamais eu lieu.

En revanche, les vrais remakes de films présentés dans l'enquête, tels que "Charlie et la chocolaterie" et "Total Recall", étaient décrits avec précision et accompagnés d'extraits de films authentiques. Ce mélange de vrais et de faux remakes avait pour but d'étudier la manière dont les participants font la distinction entre un contenu réel et un contenu fabriqué.

Les participants ont été interrogés sur leur familiarité avec chaque film, en leur demandant s'ils avaient vu le film original ou le remake, ou s'ils les connaissaient déjà.

Principales conclusions

- Le phénomène des faux souvenirs: L'un des principaux résultats de l'étude est la révélation que près de la moitié des participants (49%) ont développé de faux souvenirs en regardant des remakes fictifs, par exemple en imaginant Will Smith dans le rôle de Neo dans "Matrix". Cela illustre l'effet durable que les médias suggestifs, qu'il s'agisse de fausses vidéos profondes ou de descriptions textuelles, peuvent avoir sur notre mémoire.

- En particulierLe film "Captain Marvel" arrive en tête de liste, avec 73% des participants se souvenant de son remake de l'IA, suivi par "Indiana Jones" avec 43%, "The Matrix" avec 42% et "The Shining" avec 40%. Parmi ceux qui ont cru à tort à ces remakes, 41% pensaient que le remake de "Captain Marvel" était supérieur à l'original.

- Influence comparative des deep fakes et du texte: Une autre découverte est que les deep fakes, malgré leur réalisme visuel et auditif, n'étaient pas plus efficaces pour altérer les souvenirs des participants que les descriptions textuelles du même contenu fictif. Cela suggère que le format de la fausse information - visuel ou textuel - ne modifie pas de manière significative son impact sur la distorsion de la mémoire dans le contexte d'un film.

Le phénomène des faux souvenirs dont il est question dans cette étude a fait l'objet de nombreuses recherches. Il montre comment les humains construisent ou reconstruisent efficacement de faux souvenirs dont ils sont certains qu'ils sont réels alors qu'ils ne le sont pas.

Tout le monde est susceptible de se construire de faux souvenirs, et deep fakes semble activer ce comportement, ce qui signifie que la visualisation d'un certain contenu peut modifier notre perception, même si nous comprenons consciemment qu'il est inauthentique.

Dans les deux études, les deep fakes ont eu des effets tangibles, potentiellement à long terme. L'effet pourrait nous surprendre et s'accumuler au fil du temps.

Nous devons également garder à l'esprit que les faux contenus circulent auprès de millions de personnes, de sorte que de petits changements de perception s'étendent à l'ensemble de la population mondiale.

Que faire face aux contrefaçons profondes ?

Faire la guerre aux "deep fakes", c'est combattre le cerveau humain.

Alors que la montée des "fake news" et de la désinformation a forcé les gens à développer une nouvelle éducation aux médias ces dernières années, les médias synthétiques générés par l'IA nécessiteront un nouveau niveau d'adaptation.

Nous avons déjà été confrontés à de tels points d'inflexion, de la photographie aux effets spéciaux en images de synthèse, mais l'IA exigera une évolution de nos sens critiques.

Aujourd'hui, nous devons aller au-delà de la simple croyance en nos yeux et nous appuyer davantage sur l'analyse des sources et des indices contextuels.

Il est essentiel de s'interroger sur les motivations ou les préjugés du contenu. Correspond-elle aux faits connus ou les contredit-elle ? Existe-t-il des preuves corroborantes provenant d'autres sources dignes de confiance ?

Un autre aspect essentiel est l'établissement de normes juridiques permettant d'identifier les médias truqués ou manipulés et de tenir les créateurs pour responsables.

Les Loi américaine DEFIANCELa loi britannique sur la sécurité en ligne et ses équivalents dans le monde entier établissent des procédures juridiques pour traiter les contrefaçons profondes. Reste à savoir si elles seront efficaces.

Stratégies pour dévoiler la vérité

Concluons par cinq stratégies d'identification et d'interrogation des "deep fakes" potentiels.

Bien qu'aucune stratégie ne soit parfaite, la promotion d'un état d'esprit critique est la meilleure chose que nous puissions faire collectivement pour minimiser l'impact de la désinformation par l'IA.

- Vérification des sources: L'examen de la crédibilité et de l'origine des informations est une étape fondamentale. Les contenus authentiques proviennent souvent de sources réputées pour leur fiabilité.

- Analyse technique: Malgré leur sophistication, les contrefaçons profondes peuvent présenter des défauts subtils, tels que des expressions faciales irrégulières ou un éclairage incohérent. Examinez attentivement le contenu et vérifiez s'il a été modifié numériquement.

- Références croisées: La vérification de l'information par rapport à plusieurs sources fiables peut fournir une perspective plus large et aider à confirmer l'authenticité du contenu.

- Culture numérique: Il est essentiel de comprendre les capacités et les limites des technologies de l'IA pour évaluer les contenus. L'éducation à la culture numérique dans les écoles et les médias, y compris le fonctionnement de l'IA et ses implications éthiques, sera cruciale.

- Interaction prudente: L'interaction avec des informations erronées générées par l'IA amplifie leurs effets. Soyez prudent lorsque vous aimez, partagez ou rediffusez des contenus dont vous doutez.

Les techniques de détection et d'atténuation des dommages évoluent en même temps que les "deep fakes". L'année 2024 sera révélatrice, car près de la moitié de la population mondiale est appelée à voter lors d'élections majeures.

Il est donc loin d'être exagéré de penser que la désinformation par l'IA pourrait avoir un impact matériel sur les résultats.

À mesure que nous avançons, les pratiques éthiques en matière d'IA, la culture numérique, la réglementation et l'engagement critique seront essentiels pour façonner un avenir où la technologie amplifie, plutôt que d'obscurcir, l'essence de la vérité.