La vidéo de Google présentant les capacités de son nouveau modèle Gemini était tout simplement stupéfiante. Malheureusement, la vérité sur les qualités et les capacités de Gemini n'est pas à la hauteur du battage publicitaire.

Lorsque nous avons regardé pour la première fois la vidéo de démonstration montrant Gemini interagissant en temps réel avec le présentateur, nous avons été époustouflés. Nous étions tellement enthousiastes que nous avons oublié quelques avertissements clés au début et avons accepté la vidéo à sa valeur nominale.

Le texte des premières secondes de la vidéo indique : "Nous avons filmé des séquences pour le tester sur un large éventail de défis, en lui montrant une série d'images et en lui demandant de raisonner sur ce qu'il voit".

Ce qui s'est réellement passé en coulisses est à l'origine de la la critique de Google et les questions éthiques qu'elle soulève.

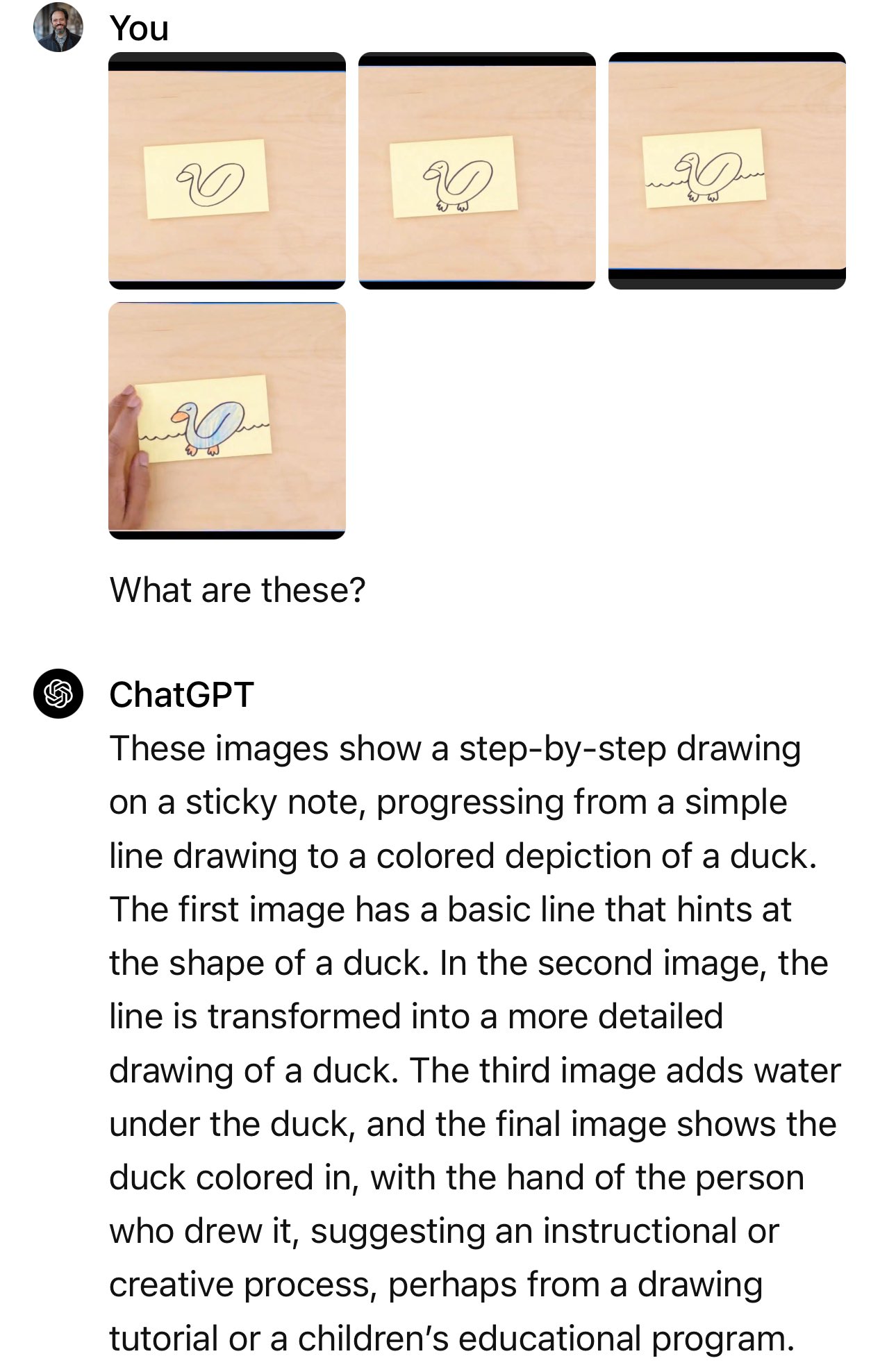

Gemini ne regardait pas une vidéo en direct du présentateur en train de dessiner un canard ou de déplacer des tasses. Il ne répondait pas non plus aux messages vocaux que vous avez entendus. La vidéo était une présentation marketing stylisée d'une vérité plus simple.

En réalité, Gemini s'est vu présenter des images fixes et des invites textuelles plus détaillées que les questions que vous entendez poser le présentateur.

Un porte-parole de Google a confirmé que les mots que vous entendez dans la vidéo sont "de véritables extraits des messages-guides utilisés pour produire la sortie Gemini qui suit".

Il s'agit donc d'invites textuelles détaillées, d'images fixes et de réponses textuelles. Ce que Google a démontré en réalité, c'est une fonctionnalité que GPT-4 possède depuis des mois.

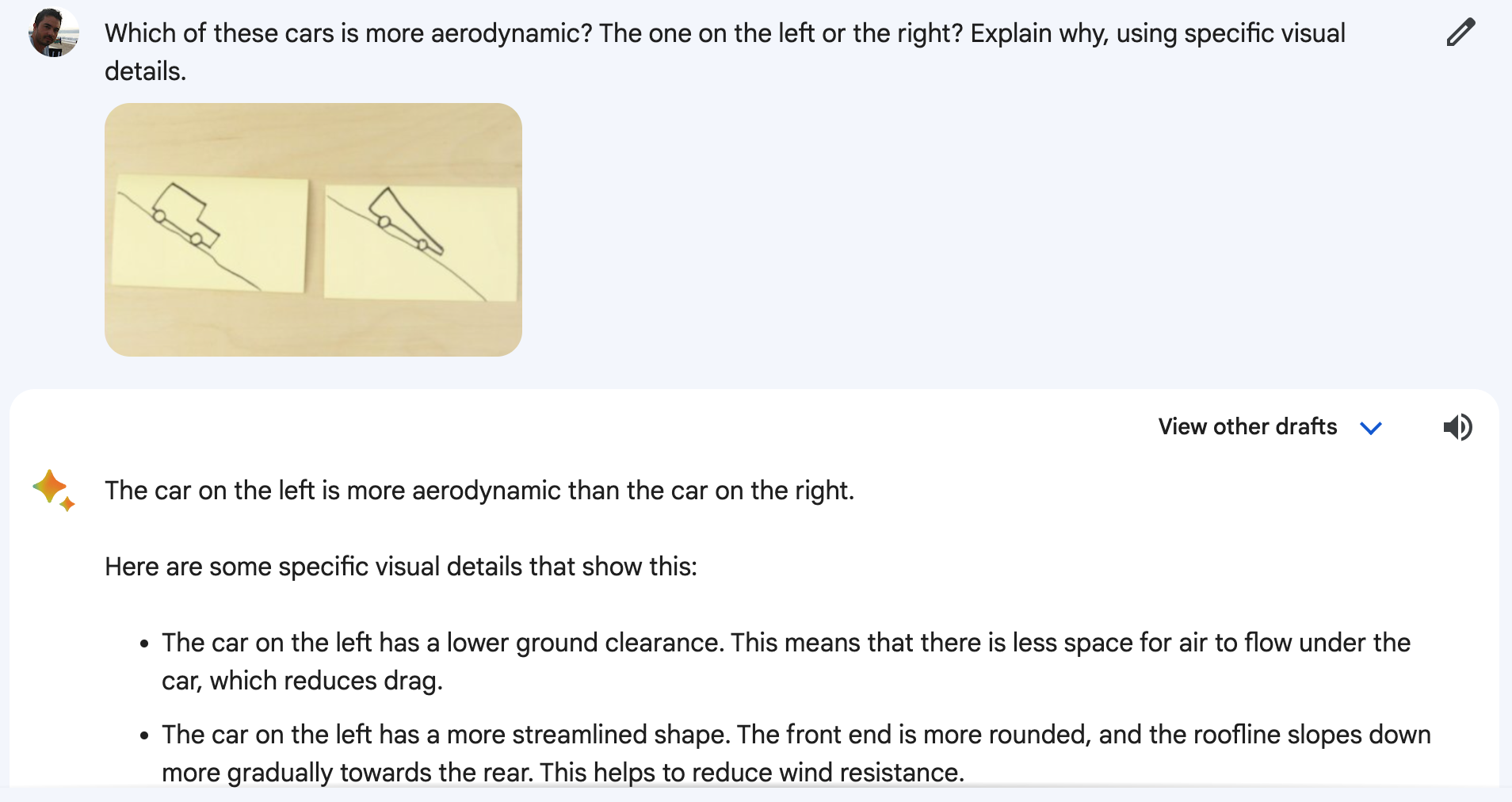

Article de blog de Google montre les images fixes et les messages-guides qui ont été utilisés.

Dans l'exemple de la voiture, le présentateur demande : "D'après leur conception, laquelle de ces voitures irait plus vite ?"

La question posée était la suivante : "Laquelle de ces voitures est la plus aérodynamique ? Celle de gauche ou celle de droite ? Expliquez pourquoi, en utilisant des détails visuels spécifiques".

Et lorsque l'on recrée l'expérience sur Bard, dont les Gémeaux sont désormais les maîtres d'œuvre, les résultats ne sont pas toujours satisfaisants.

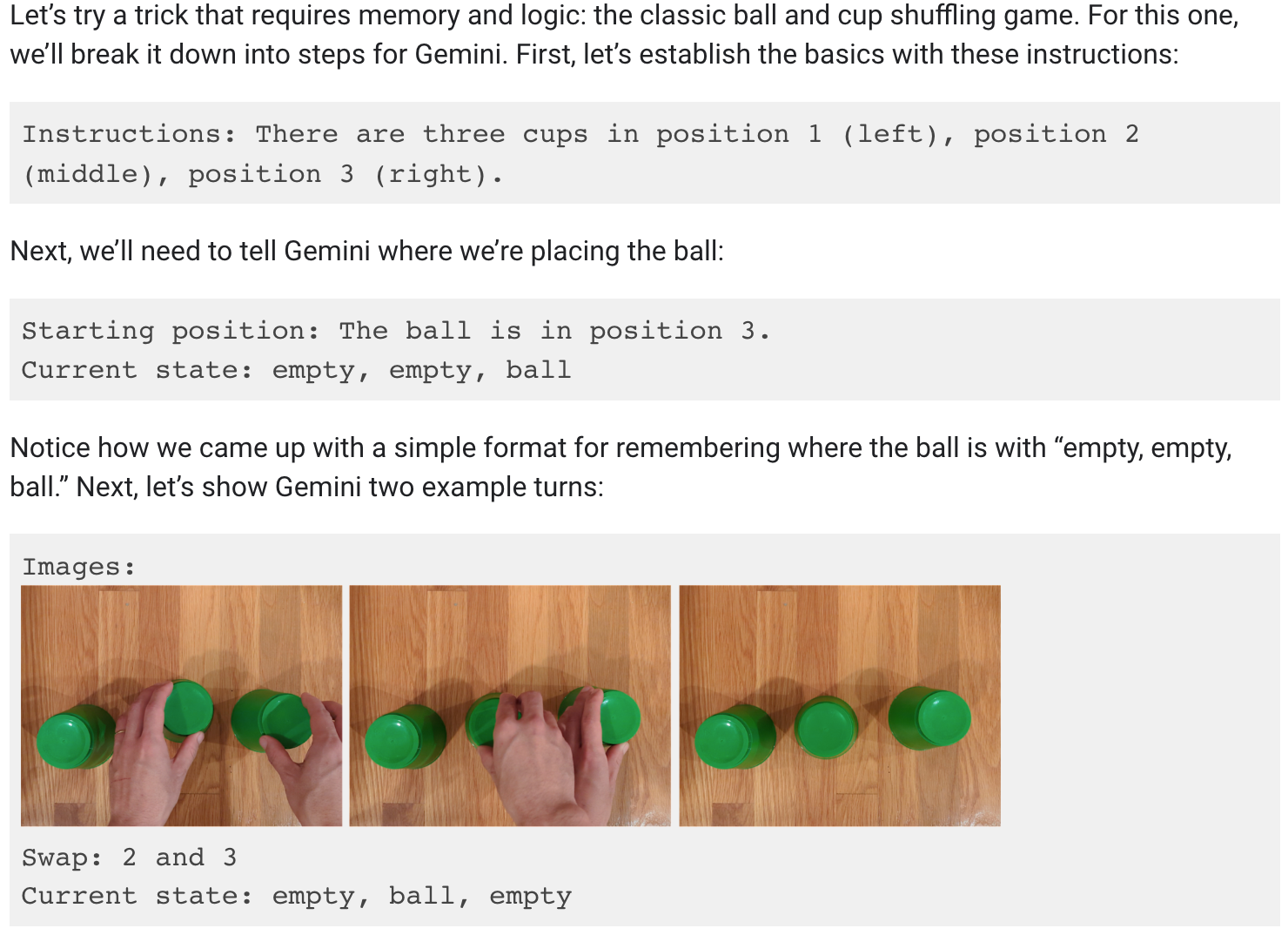

Je voulais vraiment croire que Gemini pouvait suivre la balle lorsque les trois gobelets étaient déplacés, mais malheureusement ce n'est pas le cas non plus.

Le billet de blog de Google montre qu'il a fallu beaucoup d'invites et d'explications pour la démonstration de mélange des gobelets.

Il est toujours impressionnant qu'un modèle d'IA puisse faire cela, mais ce n'est pas ce qu'on nous a vendu dans la vidéo.

C'est ça, Google ?

Nous ne faisons que spéculer ici, mais la démo montrait très probablement les résultats obtenus par Google avec Gemini Ultra, qui n'a toujours pas été publié.

Ainsi, lorsque Gemini Ultra sera finalement commercialisé, il semble qu'il sera capable de faire ce que GPT-4 fait depuis des mois. Les implications ne sont pas très importantes.

Les capacités de l'IA sont-elles en train de plafonner ? Car si les meilleurs cerveaux de l'IA travaillent chez Google, il est certain qu'ils sont à l'origine d'innovations de pointe.

Ou bien Google a-t-il non seulement tardé à entrer dans la course, mais s'est-il battu pour rester dans la course ? Les données de référence que Google a fièrement affichées montrent que son modèle, qui n'a pas encore été commercialisé, a légèrement battu le GPT-4 dans certains tests. Comment se comportera-t-il face au GPT-5 ?

Ou peut-être que le département marketing de Google a fait une erreur de jugement avec sa vidéo, mais Gemini Ultra sera quand même meilleur que ce que nous pensons. Google affirme que Gemini est réellement multimodal et qu'il comprend la vidéo, ce qui sera vraiment une première pour les LLM.

Nous n'avons pas encore vu un LLM faire preuve de compréhension vidéo, mais lorsque ce sera le cas, cela vaudra la peine de s'enthousiasmer. Sera-ce Gemini Ultra ou GPT-5 qui nous le montrera en premier ?