Des chercheurs de Stanford, du MIT et de Princeton ont créé un indice pour évaluer la transparence des entreprises d'IA et de leurs modèles. Les résultats ne sont pas fameux.

L'indice de transparence des modèles de fondation (Foundation Model Transparency Index - FMTI) évalue la transparence de 10 entreprises de modèles de fondation en fonction de 100 aspects différents de la transparence. Les critères sont liés à la façon dont une entreprise construit un modèle de fondation, à son fonctionnement et à l'expérience de l'utilisateur en aval.

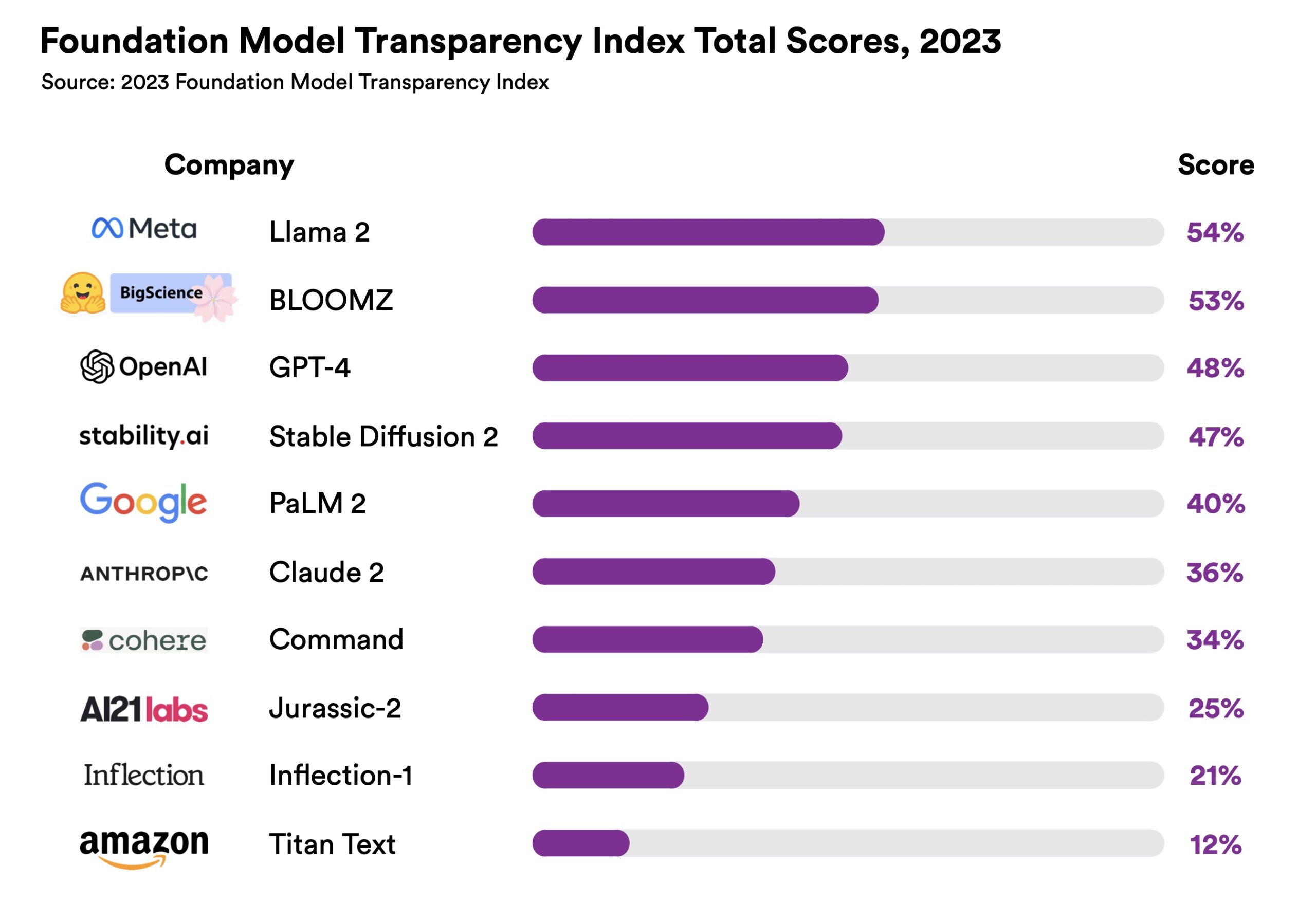

Le Llama 2 de Meta est arrivé en tête, mais son score de 54% n'est pas très brillant. OpenAI arrive en troisième position avec un score de transparence de 48%. Compte tenu de la débat open source vs propriétaireIl est intéressant de constater que l'écart entre les deux n'était pas beaucoup plus important.

La transparence est un facteur important lorsque les organisations tentent de choisir le modèle d'entreprise à adopter. Si votre entreprise ou votre établissement d'enseignement utilise un modèle d'IA, vous voulez savoir si vous pouvez lui faire confiance.

La manière dont le modèle a été conçu est-elle conforme aux principes de votre institution ? Pourriez-vous vous exposer à des litiges ultérieurs en raison de violations des droits d'auteur ?

L'indice permet de réaliser deux choses importantes. Il montre que nous avons encore beaucoup de chemin à parcourir avant de disposer de solutions d'IA véritablement transparentes. Et, bien que nous n'y soyons pas encore parvenus, il nous montre quelles entreprises font un meilleur travail que d'autres.

Les liste des critères est une lecture intéressante. Il pose des questions telles que : "Les informations géographiques concernant les personnes impliquées dans le travail des données sont-elles divulguées pour chaque phase du pipeline de données ?" Travailleurs fantômes ont été une mouche éthique litigieuse dans l'affaire de l'IA.

Un autre critère demande : "La quantité d'énergie dépensée pour construire le modèle est-elle divulguée ?" Il s'agit d'un point important si vous voulez faire une l'environnement choix éclairé entre deux modèles.

Ces questions sont indéniablement importantes, mais elles sont peu divulguées par les entreprises d'IA. Dans l'introduction du FMTI, le Center for Research Foundation Models déclare : "Alors que l'impact sociétal de ces modèles augmente, la transparence est en baisse."

On peut espérer que le fait de mettre un chiffre sur cette question suscitera une certaine concurrence entre les grandes entreprises de technologie de l'IA, qui s'efforceront de se hisser au sommet du tableau de l'IFAO.

Au fur et à mesure que la parité des performances entre les modèles les plus performants se rapproche, il se pourrait bien que le score FMTI influence l'adoption d'un modèle plutôt qu'un autre.