Une enquête du Guardian a mis en lumière l'utilisation omniprésente de l'IA et d'algorithmes complexes au Royaume-Uni dans divers processus décisionnels du secteur public.

Les fonctionnaires d'au moins huit départements du secteur public, ainsi que plusieurs unités de police, ont intégré des outils d'IA dans leurs flux de travail.

Les outils d'IA ont contribué à des processus décisionnels cruciaux dans les domaines de l'aide sociale, de l'immigration et de la justice pénale. L'enquête a révélé des preuves d'abus et de discrimination.

Bien que les biais liés aux algorithmes et à l'IA ne relèvent pas strictement de la même définition, ils risquent tous deux d'aboutir à des résultats biaisés lorsqu'ils sont exposés à des scénarios réels. Les modèles d'apprentissage automatique peuvent amplifier les biais prédominants dans les ensembles de données.

Selon la rapport:

- Un membre du Parlement a fait part de ses préoccupations concernant un algorithme utilisé par le ministère du travail et des pensions (DWP), qui est soupçonné d'avoir fait perdre à tort leurs prestations à de nombreuses personnes.

- L'outil de reconnaissance faciale de la police métropolitaine présente un taux d'erreur plus élevé lorsqu'il s'agit d'identifier des visages noirs que des visages blancs dans certaines conditions. Ce phénomène est bien établi, avec une étude indiquant que ces plateformes offraient une précision d'à peine 2% en 2018.

- Le ministère de l'intérieur a utilisé un algorithme qui cible de manière disproportionnée les personnes de certaines nationalités pour découvrir des mariages frauduleux en vue de l'obtention d'allocations et d'allégements fiscaux. Des ressortissants d'Albanie, de Grèce, de Roumanie et de Bulgarie ont pu être injustement signalés.

Les outils d'IA apprennent des modèles à partir de vastes ensembles de données. Si les ensembles de données sont biaisés ou peu représentatifs de la réalité, le modèle hérite de ces modèles.

Il existe de nombreux exemples internationaux de biais liés à l'IA et aux algorithmes, notamment de fausses reconnaissances faciales conduisant à l'emprisonnement, des systèmes d'évaluation du crédit infliger des préjugés aux femmeset les outils discriminatoires utilisés dans les tribunaux et les systèmes de santé.

Selon le rapport du Guardian, le Royaume-Uni se trouve aujourd'hui au bord d'un scandale potentiel, les experts exprimant des inquiétudes quant à la transparence et à la compréhension des algorithmes utilisés par les fonctionnaires.

Les scandales ont déjà a été observée dans d'autres payscomme aux États-Unis, où les les plateformes de police prédictive ont été démanteléeset aux Pays-Bas, où les tribunaux se sont opposés à un système d'IA destiné à réduire les fraudes à l'aide sociale.

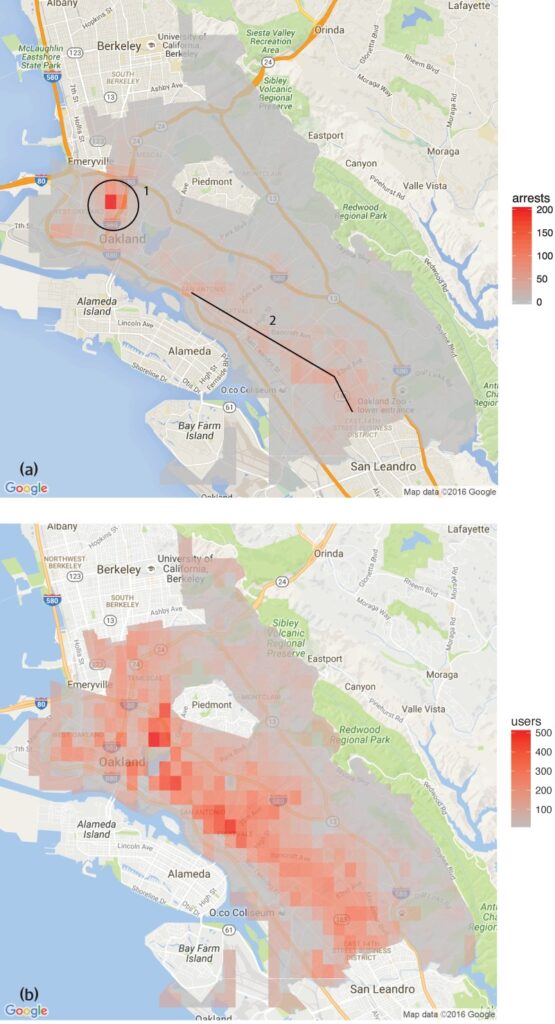

Une étude menée par la Groupe d'analyse des données sur les droits de l'homme a constaté que les logiciels de police prédictive utilisés à Oakland, en Californie, ciblaient de manière disproportionnée les communautés de couleur, perpétuant ainsi un cycle de surpolitisation dans ces quartiers.

Cela reflète les préoccupations soulevées par la L'outil de reconnaissance faciale de la police métropolitainequi ont montré des taux d'erreur plus élevés lors de l'identification de visages noirs dans certaines conditions.

Il existe également plusieurs exemples dans le domaine des soins de santé, comme les incohérences dans les modèles d'IA conçus pour aider à détecter le cancer de la peau. Dans la plupart des cas, les groupes minoritaires et les femmes sont les plus exposés.

Shameem Ahmad, directeur général du Public Law Project, a souligné la nécessité d'une action immédiate en déclarant : "L'IA offre un potentiel énorme pour le bien social. Par exemple, nous pouvons rendre les choses plus efficaces. Mais nous ne pouvons pas ignorer les risques sérieux. Si nous n'agissons pas d'urgence, nous pourrions nous retrouver dans une situation où des systèmes automatisés opaques sont régulièrement, voire illégalement, utilisés pour changer des vies, et où les gens ne seront pas en mesure d'obtenir réparation lorsque ces processus tournent mal.

Faisant écho à ces préoccupations, Marion Oswald, professeur de droit à l'université de Northumbria, a souligné les incohérences et le manque de transparence dans l'utilisation de l'IA dans le secteur public, déclarant : "Il y a un manque de cohérence et de transparence dans la façon dont l'IA est utilisée dans le secteur public. Beaucoup de ces outils affecteront de nombreuses personnes dans leur vie quotidienne, par exemple celles qui demandent des prestations, mais les gens ne comprennent pas pourquoi ils sont utilisés et n'ont pas la possibilité de les contester."

Les risques de l'IA pour le secteur public

L'application incontrôlée de l'IA dans les services gouvernementaux et les forces de police soulève des préoccupations en matière de responsabilité, de transparence et de partialité.

Dans le cas du ministère du travail et des pensions (DWP), le rapport du Guardian a dévoilé des cas où un algorithme a suspendu les prestations des personnes sans explication claire.

La députée Kate Osamor a déclaré que ses électeurs bulgares avaient perdu leurs allocations en raison d'un système semi-automatisé qui signalait leurs cas de fraude potentielle, ce qui met en évidence un manque de transparence.

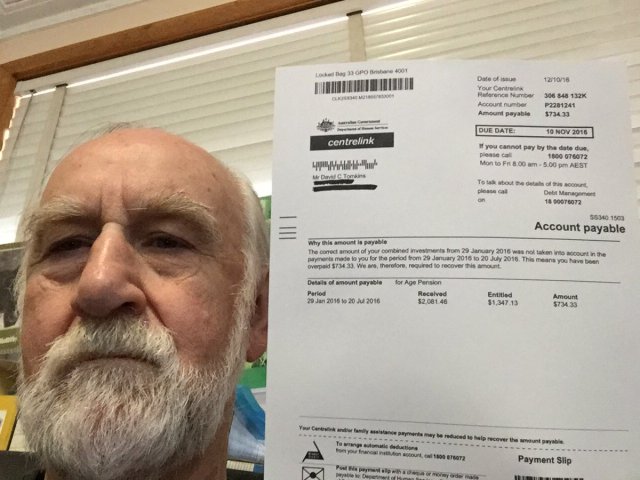

Cela rappelle la Scandale de la "Robodebt" en Australieoù un système automatisé a accusé à tort plus de 400 000 personnes de fraude à l'aide sociale, ce qui a entraîné des difficultés considérables.

Le scandale Robodebt, qui a fait l'objet d'enquêtes de la part du médiateur du Commonwealth, de recours juridiques et d'enquêtes publiques, a démontré l'ampleur de l'impact des décisions algorithmiques.

Le gouvernement australien a accepté un règlement d'un montant de $1,8 milliard d'AUS en 2021.

Les lacunes de l'IA ne se limitent pas aux services publics. Le monde de l'entreprise a également connu des échecs, notamment en ce qui concerne les outils de recrutement pilotés par l'IA.

Un exemple notable est celui de l'outil de recrutement par IA d'Amazon, qui a fait preuve de partialité à l'égard des candidates. Le système a été formé à partir de CV soumis à l'entreprise sur une période de 10 ans, dont la plupart provenaient d'hommes, ce qui a conduit l'IA à favoriser les candidats masculins.

Trois exemples de biais algorithmiques dont il faut se méfier

Alors que l'IA et la prise de décision algorithmique s'intègrent dans des processus sociétaux complexes, les exemples alarmants de préjugés et de discrimination se multiplient.

Le système de santé et le système judiciaire américains

Une étude en 2019 publié dans Science a révélé qu'un algorithme de soins de santé largement utilisé aux États-Unis présentait des préjugés raciaux. L'algorithme était moins susceptible d'orienter les Noirs vers des programmes conçus pour améliorer les soins aux patients ayant des besoins médicaux complexes que leurs homologues blancs.

L'étude explique pourquoi : "Le biais est dû au fait que l'algorithme utilise les coûts de santé comme indicateur des besoins de santé. Moins d'argent est dépensé pour les patients noirs qui ont les mêmes besoins, et l'algorithme conclut donc faussement que les patients noirs sont en meilleure santé que les patients blancs tout aussi malades."

Un autre exemple important est l'utilisation de l'IA dans la police prédictive et la détermination des peines par les tribunaux. Des outils tels que Profil de gestion des délinquants correctionnels pour les sanctions alternatives (COMPAS) ont été utilisées pour évaluer le risque de récidive des prévenus.

Des enquêtes ont révélé que ces outils peuvent être biaisés à l'encontre des accusés afro-américains, en leur attribuant des scores de risque plus élevés qu'à leurs homologues blancs. Cela soulève des inquiétudes quant à l'équité et à l'impartialité des décisions judiciaires assistées par l'IA.

Reconnaissance faciale au Brésil

Les Projet Smart Sampa à São Pauloau Brésil, a marqué une étape importante dans l'intégration de l'IA et de la surveillance dans les paysages urbains, ce qui n'avait été le cas qu'en Chine.

D'ici 2024, elle vise à installer jusqu'à 20 000 caméras à São Paulo et à intégrer un nombre égal de caméras tierces et privées dans une plateforme de vidéosurveillance unique. Ce réseau surveillera les espaces publics, les établissements médicaux et les écoles et examinera le contenu des médias sociaux en rapport avec l'administration publique.

Alors que Smart Sampa promet une sécurité accrue et des services publics améliorés, les experts avertissent qu'elle pourrait exacerber les problèmes sociétaux existants, en particulier le racisme structurel et l'inégalité.

Plus de 90% des personnes arrêtées au Brésil sur la base du contrôle au faciès sont noires. L'initiative de São Paulo risque de perpétuer cette tendance, en marginalisant davantage la communauté noire, qui représente 56% de la population brésilienne.

Les technologies de reconnaissance faciale identifient souvent mal les teints foncés, en partie parce que la technologie d'imagerie est moins performante pour les teints foncés et en partie parce que les ensembles de données d'entraînement ne sont pas représentatifs.

Fernanda Rodrigues, avocate spécialisée dans les droits numériques, a souligné la possibilité de faux positifs et le risque d'incarcération massive des Noirs qui en découle.

Selon M. Rodrigues, "outre le risque que les informations transmises à ces plateformes ne soient pas exactes et que le système lui-même tombe en panne, il existe un problème qui précède les implications technologiques, à savoir le racisme".

"Nous savons que le système pénal brésilien est sélectif, et nous pouvons donc conclure que [l'utilisation de la surveillance avec reconnaissance faciale] a pour but d'augmenter les risques et les préjudices pour cette population", a-t-elle ajouté.

Les préoccupations en matière de protection de la vie privée sont également primordiales. Les critiques affirment que Smart Sampa pourrait porter atteinte aux droits de l'homme fondamentaux, notamment à la vie privée et à la liberté d'expression, de réunion et d'association. La nature opaque du projet a encore compliqué les choses, avec une participation limitée du public pendant la phase de consultation.

Smart Sampa n'est pas resté sans réponse. Des procureurs ont enquêté et des organisations de défense des droits de l'homme ont entamé des actions en justice pour faire cesser l'utilisation de cette technologie.

Indication néerlandaise du risque systémique (SyRI)

En 2022, le tribunal de district de La Haye a examiné de près l'utilisation par le gouvernement néerlandais des Indication du risque du système (SyRI)un algorithme conçu pour détecter les fraudes potentielles à l'aide sociale.

SyRI était destiné à améliorer l'efficacité de l'identification des fraudes à l'aide sociale en agrégeant des données provenant de diverses bases de données gouvernementales et en appliquant des indicateurs de risque pour générer des profils de fraudeurs potentiels. Cependant, des décisions suspectes et un manque de transparence ont tiré la sonnette d'alarme, ce qui a conduit à un recours en justice par une coalition d'organisations de la société civile.

Les plaignants ont fait valoir que SyRI violait diverses lois internationales et européennes sur les droits de l'homme. Ils ont également mis en doute la légalité, la nécessité et la proportionnalité de l'application de l'algorithme.

Le tribunal de district de La Haye a jugé que la législation régissant le SyRI et son application ne respectait pas les normes nécessaires en matière de droits de l'homme. Le tribunal a souligné le manque de transparence et le risque d'effets discriminatoires, en insistant sur la nécessité de disposer de garanties juridiques adéquates lors de la mise en œuvre de ces technologies.

Cette affaire a été saluée comme l'une des premières à traiter de l'impact de l'IA sur les droits de l'homme dans le secteur public, soulignant la nécessité de la transparence, de la responsabilité et de cadres juridiques solides.

Il est primordial de tester les outils de manière transparente et équitable.

À la suite des récentes contestations juridiques et de l'examen public des décisions algorithmiques dans les opérations gouvernementales, l'appel à des tests transparents des outils d'IA est devenu de plus en plus pressant.

Garantir la responsabilité, prévenir la discrimination et maintenir la confiance du public dépendent de la mise en œuvre de protocoles de test rigoureux et ouverts.

Des tests transparents permettent de comprendre en profondeur le fonctionnement de ces algorithmes, les données qu'ils utilisent et les processus décisionnels qu'ils suivent. Cela est essentiel pour identifier les biais potentiels, les inexactitudes ou les pratiques discriminatoires intégrées dans le système.

Cependant, les procédures de test rigoureuses sont en contradiction avec la promesse d'efficacité rapide de l'IA.

Dans le cas du Royaume-Uni, la déclaration du Premier ministre Rishi Sunak a été faite en décembre dernier. Une politique favorable à l'innovationIl n'y a peut-être pas assez de place pour des procédures d'essai complètes. En outre, il n'existe que peu - voire pas du tout - de processus convenus pour tester les outils d'IA avant de les distribuer pour un usage public.

Ce scénario se retrouve dans le monde entier. L'adoption rapide de l'IA ne doit pas se faire au détriment de l'examen et de l'analyse.