Nvidia a annoncé un nouveau logiciel open source qui, selon elle, augmentera les performances d'inférence sur ses GPU H100.

Une grande partie de la demande actuelle pour les GPU de Nvidia concerne la puissance de calcul nécessaire à l'apprentissage de nouveaux modèles. Mais une fois formés, ces modèles doivent être utilisés. L'inférence en IA fait référence à la capacité d'un LLM comme ChatGPT à tirer des conclusions ou à faire des prédictions à partir de données sur lesquelles il a été entraîné et à générer des résultats.

Lorsque vous essayez d'utiliser ChatGPT et qu'un message s'affiche pour vous indiquer que ses serveurs sont à bout de souffle, c'est parce que le matériel informatique a du mal à répondre à la demande d'inférence.

Nvidia affirme que son nouveau logiciel, TensorRT-LLM, peut faire fonctionner le matériel existant beaucoup plus rapidement et de manière plus économe en énergie.

Le logiciel comprend des versions optimisées des modèles les plus populaires, notamment Meta Llama 2, OpenAI GPT-2 et GPT-3, Falcon, Mosaic MPT et BLOOM.

Il utilise des techniques astucieuses telles qu'un regroupement plus efficace des tâches d'inférence et des techniques de quantification pour améliorer les performances.

Les LLM utilisent généralement des valeurs à virgule flottante de 16 bits pour représenter les poids et les activations. La quantification prend ces valeurs et les réduit à des valeurs à virgule flottante de 8 bits pendant l'inférence. La plupart des modèles parviennent à conserver leur exactitude avec cette précision réduite.

Les entreprises qui disposent d'une infrastructure informatique basée sur les GPU H100 de Nvidia peuvent s'attendre à une amélioration considérable des performances d'inférence sans avoir à dépenser un centime en utilisant TensorRT-LLM.

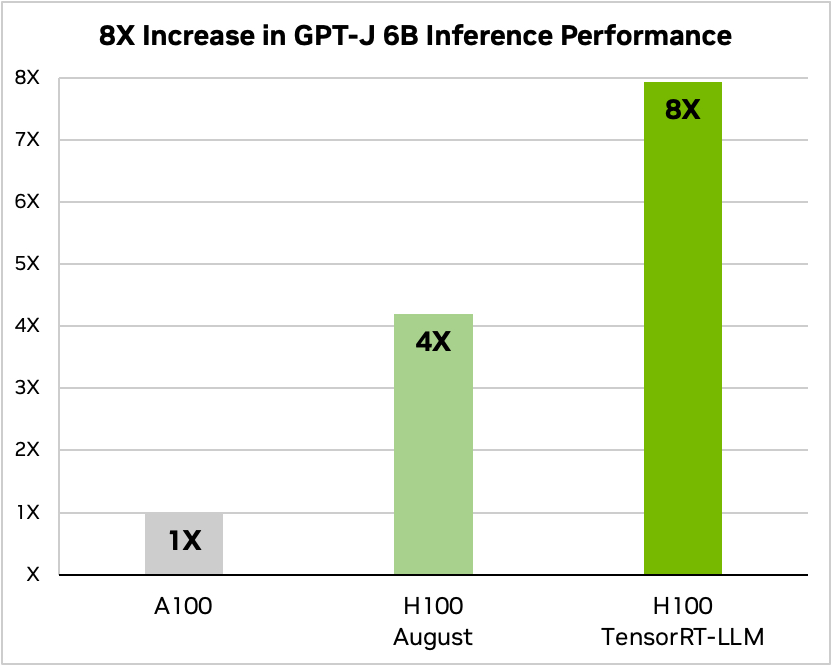

Nvidia a utilisé un exemple d'exécution d'un petit modèle open source, GPT-J 6, pour résumer des articles dans l'ensemble de données CNN/Daily Mail. Son ancienne puce A100 est utilisée comme vitesse de référence, puis comparée à la H100 sans puis avec TensorRT-LLM.

Source : Nvidia

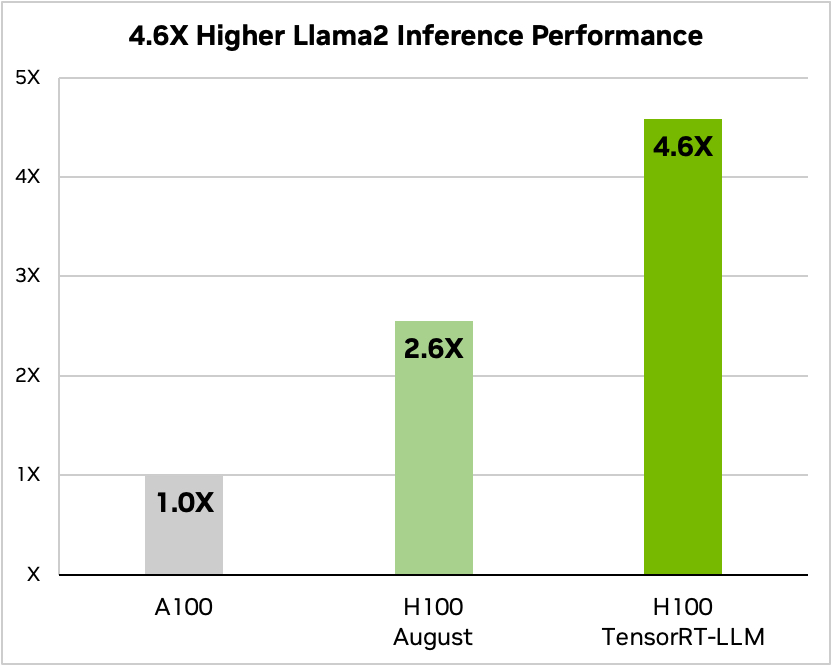

Et voici une comparaison avec le Llama 2 de Meta

Source : Nvidia

Nvidia a déclaré que ses tests ont montré que, selon le modèle, un H100 exécutant TensorRT-LLM utilise entre 3,2 et 5,6 fois moins d'énergie qu'un A100 pendant l'inférence.

Si vous exécutez des modèles d'IA sur du matériel H100, cela signifie que non seulement vos performances en matière d'inférence vont presque doubler, mais aussi que votre facture d'énergie sera beaucoup moins élevée une fois que vous aurez installé ce logiciel.

TensorRT-LLM sera également disponible pour la plate-forme Nvidia Les superpuces de Grace Hopper mais la société n'a pas publié de chiffres sur les performances du GH200 équipé de son nouveau logiciel.

Le nouveau logiciel n'était pas encore prêt lorsque Nvidia a soumis son Superchip GH200 aux tests d'évaluation des performances de l'IA MLPerf, un standard de l'industrie. Les résultats ont montré que la GH200 était jusqu'à 17% plus performante qu'une puce H100 SXM.

Si Nvidia parvient à augmenter ne serait-ce que modestement les performances d'inférence en utilisant TensorRT-LLM avec le GH200, l'entreprise se placera loin devant ses plus proches rivaux. Être représentant commercial pour Nvidia doit être le travail le plus facile au monde à l'heure actuelle.