Nos pensées sont peut-être notre sanctuaire le plus intime, mais elles ne sont pas interdites à l'IA.

L'IA qui lit dans les pensées semble sortir d'un roman de science-fiction. Pourtant, elle est extrêmement prometteuse pour les personnes qui ne peuvent pas communiquer en raison d'une paralysie ou d'une lésion cérébrale.

En outre, l'accès de l'IA au cerveau nous permettrait d'écrire, de créer et de concevoir à partir de nos seules pensées ou de fournir à d'autres des fenêtres sur notre conscience.

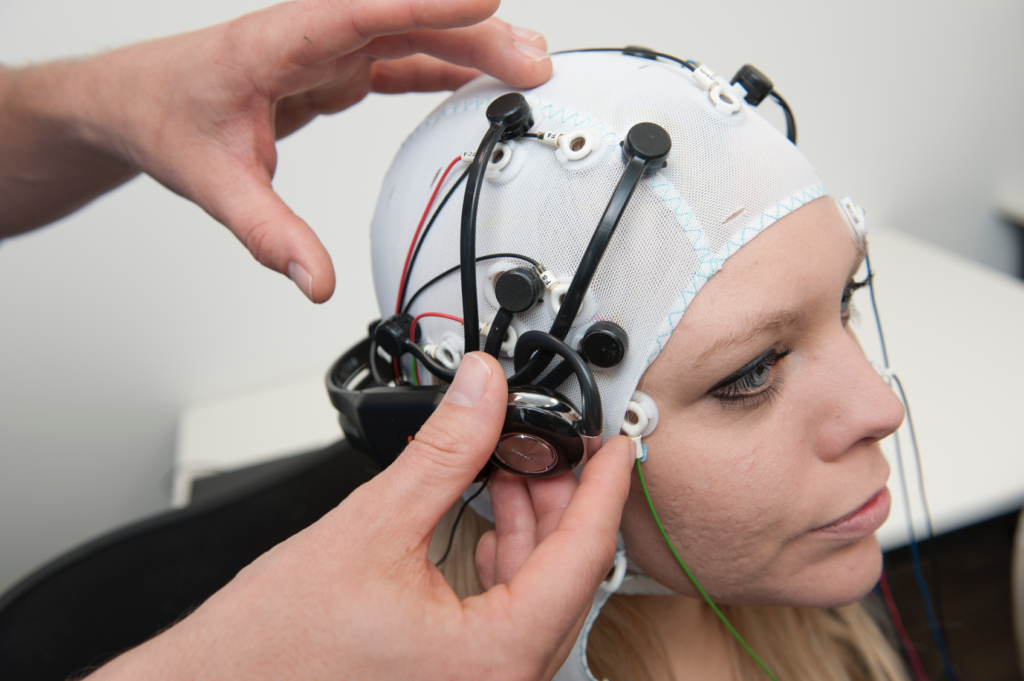

Depuis près de dix ans, la technologie de l'électroencéphalogramme (EEG), qui capte les signaux électriques par l'intermédiaire d'électrodes sur le cuir chevelu, aide les personnes souffrant d'accidents vasculaires cérébraux graves et du syndrome de verrouillage complet (CLIP), un état dans lequel une personne est consciente mais immobile.

En 2014, un Italien atteint de sclérose latérale amyotrophique (SLA), Anselmo Paglialonga, a utilisé un appareil d'imagerie médicale. casque intégré à l'apprentissage automatique de communiquer en répondant par oui ou par non, bien qu'ils soient incapables de bouger un muscle. Certaines personnes atteintes de la maladie peuvent bouger de minuscules muscles, comme Stephen Hawking, qui pouvait contracter le muscle de sa joue.

Au fur et à mesure que l'IA progresse, les chercheurs comblent le fossé qui sépare la simple interprétation des signaux de la traduction intégrale de pensées complexes.

À terme, les gens pourraient être capables de parler et de communiquer sans bouger un muscle, littéralement par le pouvoir de la pensée.

Cette même technologie pourrait nous permettre de contrôler des machines complexes à l'aide de notre cerveau, de composer de la musique en imaginant une mélodie, ou de peindre et de dessiner en évoquant des images avec notre esprit. Nous pourrions même "enregistrer" nos rêves à partir des ondes cérébrales et les réécouter plus tard.

Dans un avenir pas si lointain, l'IA qui lit dans les pensées pourrait être utilisée pour lire de force les souvenirs d'une personne, par exemple pour vérifier qu'elle a bien été témoin d'un crime.

Des pirates informatiques pourraient même vous inciter brièvement à imaginer vos informations personnelles tout en extrayant une copie de vos pensées de votre cerveau. Les régimes totalitaires pourraient effectuer des tests de routine sur les citoyens pour surveiller les pensées divergentes.

De plus, avec la capacité de convertir les pensées en une réalité informatisée, les humains pourraient passer leur vie dans un bac à sable de rêve où ils pourraient modeler leur réalité à volonté.

À l'heure actuelle, de telles applications semblent surréalistes et fantaisistes, mais plusieurs expériences récentes ont jeté les bases d'un avenir où le cerveau sera accessible à l'IA.

L'IA pour lire dans vos pensées

Comment tout cela est-il possible ?

Pour traduire l'activité cérébrale en un résultat utilisable par un ordinateur, il faut d'abord prendre des mesures précises.

C'est le premier obstacle, car le cerveau est aussi mystérieux que les confins de l'espace ou les profondeurs des océans. Il n'y a guère de consensus sur la manière dont l'activité neuronale produit des pensées complexes, sans parler de la conscience.

Le cerveau humain - comme d'ailleurs d'autres systèmes nerveux dans la nature - abrite des milliards de neurones, dont la plupart s'activent de 5 à 100 fois par seconde. Dans le cerveau humain, chaque seconde de pensée implique des billions de neurones. des actions neuronales individuelles.

Mesurer l'activité neuronale à un niveau granulaire est le Saint-Graal des neurosciences, mais ce n'est pas possible à l'heure actuelle, surtout avec des techniques non invasives.

Actuellement, les mesures de l'activité cérébrale sont plus globales, extraites des mouvements sanguins ou des échanges de signaux électriques. Il existe trois méthodes bien établies pour mesurer l'activité cérébrale :

- La magnétoencéphalographie (MEG) capte les champs magnétiques générés par l'activité électrique du cerveau et fournit des informations sur l'activité neuronale en temps réel.

- Électroencéphalographie (EEG) pour l'interprétation de l'activité électrique.

- L'IRM, qui mesure l'activité cérébrale par l'intermédiaire de la circulation sanguine.

L'apprentissage automatique (ML) et l'IA ont fusionné avec ces trois technologies pour améliorer l'analyse de signaux complexes.

L'objectif final est d'associer des activités cérébrales spécifiques à des pensées distinctes, qui peuvent inclure un mot, une image ou quelque chose de plus sémantique et abstrait.

Les technologies qui permettent d'obtenir des mesures du cerveau et de les transmettre à des ordinateurs sont appelées interfaces cerveau-ordinateur (ICU).

Voici comment cela fonctionne :

- Présentation du stimulus: Les participants sont exposés à divers stimuli. Il peut s'agir d'images, de sons ou même de sensations tactiles. Leur activité cérébrale est enregistrée pendant cette exposition, généralement par EEG ou IRM.

- Collecte de données: Les réponses du cerveau à ces stimuli sont enregistrées en temps réel. Ces données deviennent une riche source d'informations sur la manière dont différents stimuli affectent l'activité cérébrale.

- Prétraitement: Les données brutes sur le cerveau sont souvent bruyantes. Avant de pouvoir être utilisées, elles doivent être nettoyées et normalisées. Il peut s'agir d'éliminer les artefacts, de normaliser les signaux ou d'aligner les points de données.

- Apprentissage automatique: Les données traitées permettent d'introduire des modèles d'apprentissage automatique. Ces modèles sont entraînés à trouver des modèles ou des corrélations entre les données cérébrales et le stimulus correspondant. En substance, l'IA agit comme un interprète, déchiffrant le "langage" du cerveau.

- Modèle de formation: Il s'agit d'un processus itératif. Plus le modèle est exposé à des données, plus il devient apte à faire des prédictions ou à générer des résultats. Cette phase peut prendre beaucoup de temps et de puissance de calcul.

- Validation: Une fois formé, la précision du modèle est testée. Pour ce faire, on présente généralement de nouveaux stimuli aux participants, on enregistre leur activité cérébrale, puis on utilise le modèle pour prédire ou générer une sortie sur la base de ces nouvelles données.

- Retour d'information et perfectionnement : Sur la base des résultats de la validation, les chercheurs ajustent et affinent le modèle, en procédant par itérations jusqu'à ce qu'ils obtiennent la meilleure précision possible.

- Application: Une fois validée, l'application est utilisée pour l'usage auquel elle est destinée, qu'il s'agisse d'aider une personne paralysée à communiquer, de générer des images à partir de pensées ou de toute autre application.

Les méthodes d'IA ont évolué rapidement au cours des deux dernières années, permettant aux chercheurs de travailler avec des données cérébrales complexes et bruyantes pour en extraire des pensées transitoires et les convertir en quelque chose d'exploitable par un ordinateur.

Par exemple, un Projet 2022 La société Meta a exploité les données MEG et EEG de 169 personnes pour entraîner une IA à reconnaître les mots qu'elles ont entendus à partir d'une liste prédéterminée de 793 mots. L'IA a pu générer une liste de 10 mots contenant le mot sélectionné dans 73% des cas, ce qui prouve que l'IA peut "lire dans les pensées", bien qu'avec une précision limitée.

En mars 2023, Les chercheurs ont dévoilé un décodeur d'IA révolutionnaire qui transforme l'activité cérébrale en flux textuels continus.

L'IA a fait preuve d'une précision étonnante en convertissant en texte les histoires que les personnes ont écoutées ou imaginées à l'aide des données de l'IRMf.

Le Dr Alexander Huth, de l'université du Texas à Austin, s'est dit stupéfait de l'efficacité du système : "Nous avons été en quelque sorte choqués qu'il fonctionne aussi bien. Cela fait 15 ans que je travaille sur ce sujet... c'était donc à la fois choquant et excitant de voir qu'il fonctionnait enfin".

L'étude a intégré de grands modèles de langage (LLM), en particulier GPT-1, un ancêtre de ChatGPT.

Des volontaires ont effectué des séances d'IRMf de 16 heures en écoutant des podcasts. Ces données IRMf ont été utilisées pour former un modèle d'apprentissage automatique.

Ensuite, les participants ont écouté ou imaginé de nouvelles histoires, et l'IA a traduit leur activité cérébrale en texte. Environ 50% des résultats étaient proches ou exactement alignés sur le message original. Le Dr Huth explique : "Notre système fonctionne au niveau des idées, de la sémantique, du sens... c'est l'essentiel."

- Par exemple, la phrase "Je n'ai pas encore mon permis de conduire" a été décodée comme "Elle n'a même pas encore commencé à apprendre à conduire".

- Autre extrait : "Je ne savais pas si je devais crier, pleurer ou m'enfuir. Au lieu de cela, j'ai dit : "Laissez-moi tranquille !"" devient "J'ai commencé à crier et à pleurer, et puis elle m'a dit : "Je t'avais dit de me laisser tranquille".

Le modèle a également été appliqué aux ondes cérébrales générées par des participants regardant des films muets.

Lorsque les participants écoutaient une histoire particulière, l'interprétation de l'IA reflétait le sentiment général de l'histoire. Si elle est affinée, cette technologie pourrait nous permettre d'écrire des histoires à partir de nos seules pensées.

Vous avez du mal à vous lancer dans la rédaction d'un roman ou d'un projet d'écriture ? Il vous suffit de vous allonger et d'imaginer le déroulement de l'histoire. L'IA l'écrira pour vous.

L'IA pour générer des images à partir de la pensée

L'IA peut convertir l'activité cérébrale en mots et en concepts sémantiques, mais qu'en est-il des images ou de la musique ?

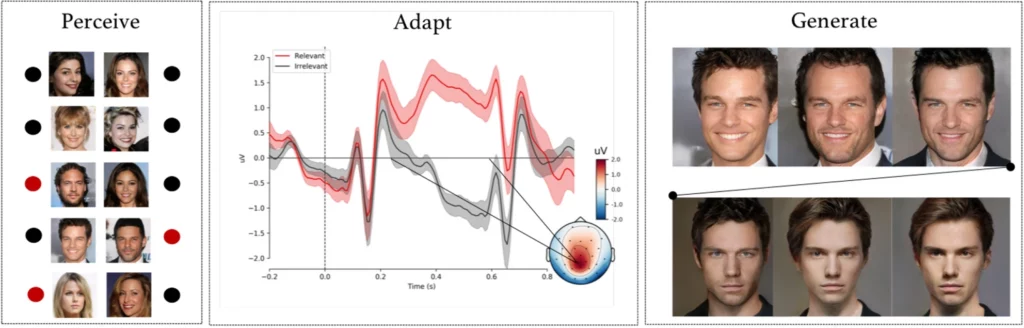

A expérience complexe réalisée par des chercheurs de l'université d'Helsinki, à Helsinki, en Finlande, a demandé à des sujets d'observer des images faciales générées par l'IA tout en enregistrant leurs signaux EEG.

Après avoir utilisé ces données pour former un modèle d'IA, les participants ont été invités à identifier des visages spécifiques à partir d'une liste. Ces signaux sont devenus une fenêtre sur les perceptions et les intentions du participant.

Le modèle d'IA a interprété si le participant reconnaissait un visage particulier sur la base des signaux EEG enregistrés.

Dans la phase suivante, les signaux EEG ont été utilisés pour adapter et mouler un réseau accusatoire génératif (GAN) - un modèle utilisé dans certaines IA génératives.

Le système a ainsi pu produire de nouvelles images de visages conformes à l'intention initiale de l'utilisateur.

Comme l'a fait remarquer Michiel Spapé, coauteur de l'étude, "la technique ne reconnaît pas les pensées, mais réagit plutôt aux associations que nous avons avec les catégories mentales".

En d'autres termes, si quelqu'un pense à un "visage de personne âgée", le système informatique peut générer une image d'une personne âgée qui correspond étroitement à la pensée du participant, grâce à la rétroaction des signaux cérébraux.

Dessiner avec la pensée forte

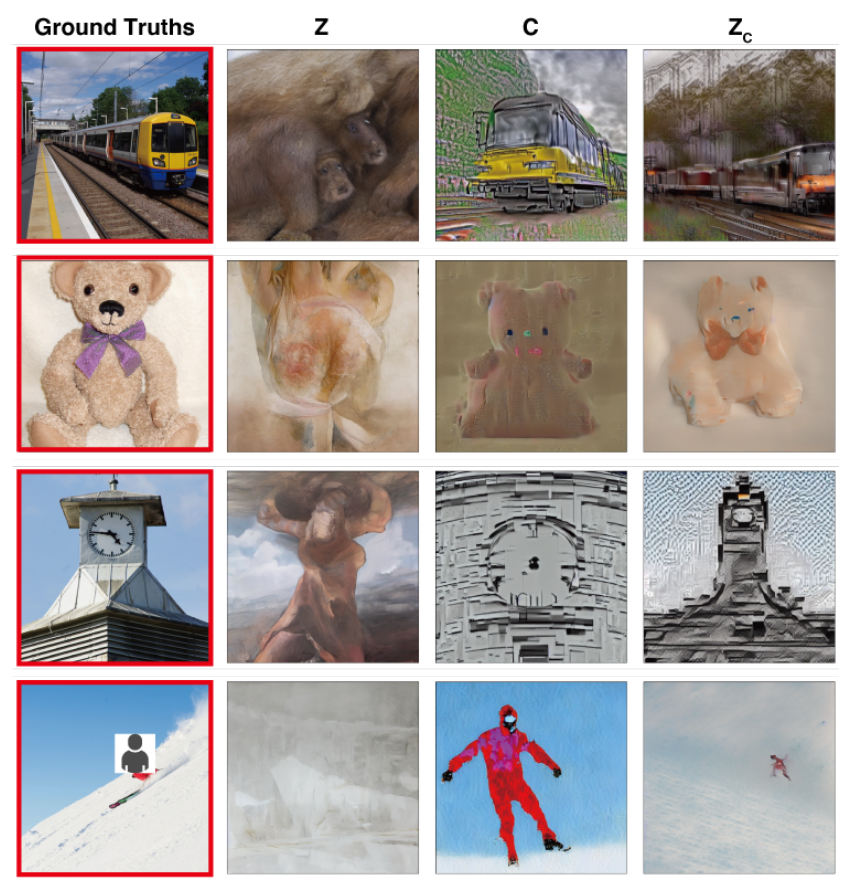

Dans un étude avec des objectifs similairesDes scientifiques de l'université d'Osaka, au Japon, ont mis au point une technique permettant de traduire des signaux cérébraux complexes en images de haute résolution, avec des résultats remarquables.

La méthode utilise un modèle de diffusion stable, une forme spécialisée de réseau neuronal conçu pour la génération d'images. Stable Diffusion a été développé avec l'aide et le financement de Stability AI.

Les pensées sont capturées à l'aide de l'IRMf et transmises à un modèle de diffusion stable, qui les transforme en images par le biais d'un processus complexe en plusieurs étapes qui implique plusieurs couches de raffinement.

Contrairement aux études précédentes, ces méthodes ne nécessitent qu'un réglage minimal du modèle. Cependant, les participants doivent encore passer de nombreuses heures à l'intérieur des appareils d'IRM.

Il s'agit d'un défi majeur, car la plupart de ces expériences impliquent des mesures rigoureuses et la formation de modèles, ce qui prend du temps, est coûteux et difficile à supporter pour les participants.

Toutefois, à l'avenir, il n'est pas impossible que les gens puissent former leurs propres modèles légers de lecture de l'esprit et utiliser leurs pensées pour diverses utilisations, telles que la conception d'un bâtiment en y pensant ou la composition d'un morceau d'orchestre en évoquant les mélodies.

Traduire les pensées en musique grâce à l'IA

Mots, images, musique - rien n'est interdit à l'IA.

A 2023 étude permet de mieux comprendre la perception des sons, ce qui ouvre de vastes perspectives pour la conception d'appareils de communication destinés aux personnes souffrant de troubles de l'élocution.

Robert Knight et son équipe de l'université de Californie à Berkeley ont examiné les enregistrements cérébraux réalisés à partir d'électrodes placées chirurgicalement sur 29 personnes atteintes d'épilepsie.

Pendant que ces participants écoutaient "Another Brick in the Wall, Part 1" de Pink Floyd, l'équipe a établi une corrélation entre leur activité cérébrale et des éléments de la chanson tels que la hauteur, la mélodie, l'harmonie et le rythme.

À l'aide de ces données, les chercheurs ont formé un modèle d'IA en omettant volontairement un segment de chanson de 15 secondes. L'IA a ensuite tenté de prédire ce segment manquant sur la base des signaux cérébraux, obtenant une similarité de spectrogramme de 43% avec le segment réel de la chanson.

Knight et son équipe ont identifié la zone du gyrus temporal supérieur du cerveau comme étant essentielle pour traiter le rythme de guitare de la chanson. Ils ont également confirmé des résultats antérieurs selon lesquels l'hémisphère droit joue un rôle plus important dans le traitement de la musique que l'hémisphère gauche.

M. Knight estime que cette compréhension plus approfondie de l'interaction cerveau-musique peut profiter aux dispositifs d'aide aux personnes souffrant de troubles de la parole, tels que la sclérose latérale amyotrophique (SLA) et l'aphasie.

Il a déclaré : "Pour les personnes atteintes de sclérose latérale amyotrophique [une affection du système nerveux] ou d'aphasie [un trouble du langage], qui ont du mal à parler, nous aimerions un appareil qui donne vraiment l'impression de communiquer avec quelqu'un d'une manière humaine. Comprendre comment le cerveau représente les éléments musicaux de la parole, y compris le ton et l'émotion, pourrait rendre ces appareils moins robotiques.

Ludovic Bellier, membre de l'équipe de recherche, estime que si l'IA peut reproduire de la musique à partir de la simple imagination, elle pourrait révolutionner la composition musicale.

Les producteurs de musique pourraient connecter leur cerveau à un logiciel et composer de la musique par la seule pensée, tout en bougeant à peine un muscle.

La prochaine étape : la lecture de l'esprit par l'IA en temps réel

Ces technologies sont regroupées sous le terme d'interfaces cerveau-ordinateur (ICU), qui visent à convertir les signaux cérébraux en une forme de sortie.

Les BCI permettent déjà aux personnes paralysées de retrouver la capacité de bouger et de marcher en comblant le fossé entre les composants du système nerveux qui ont été sectionnés.

Les interfaces cerveau-ordinateur développées cette année comprennent un dispositif qui permet à un homme paralysé de bouger ses jambes, implants cérébraux expérimentaux qui relient les parties endommagées du cerveau et de la moelle épinière pour restaurer les sensations perdues, et une jambe mécanique qui permet d'améliorer la qualité de la vie. a redonné du mouvement à un amputé.

Bien que ces premiers cas d'utilisation soient extrêmement prometteurs, nous sommes loin de pouvoir traduire de manière transparente chaque nuance de nos pensées en mouvements, en images, en paroles ou en musique.

L'une des principales contraintes est la nécessité de disposer d'énormes ensembles de données pour entraîner les algorithmes sophistiqués qui rendent ces traductions possibles.

Les modèles d'apprentissage automatique doivent être entraînés sur de nombreux scénarios pour prédire ou générer une image spécifique à partir de l'activité cérébrale avec précision. Cela implique la collecte de données IRM ou EEG pendant que les participants sont exposés à divers stimuli.

La qualité et la spécificité des résultats générés dépendent fortement de la richesse de ces données de formation. Les participants doivent passer des heures dans des scanners IRM pour collecter des données spécifiquement pertinentes.

En outre, le cerveau humain est incroyablement unique. Ce qui signifie le bonheur dans le cerveau d'une personne peut être différent dans celui d'une autre. Cela signifie que les modèles doivent être très généraux ou adaptés à chaque individu.

Ensuite, les activités cérébrales changent rapidement, même en l'espace de quelques fractions de seconde. Capturer des données en temps réel et à haute résolution tout en s'assurant qu'elles s'alignent parfaitement sur le stimulus externe est un défi technique.

N'oublions pas non plus les problèmes éthiques que pose le fait de pénétrer dans le cerveau d'une personne.

La collecte de données sur le cerveau, en particulier à grande échelle, soulève d'importantes questions en matière de respect de la vie privée et d'éthique. Comment s'assurer que les données ne sont pas utilisées à mauvais escient ? Qui a le droit d'accéder à nos pensées les plus intimes et de les interpréter ?

Provisoirement, il semble que ces défis puissent être surmontés. À l'avenir, les humains pourraient avoir accès à des interfaces cerveau-ordinateur portables et personnalisées leur permettant de se "brancher" sur une myriade d'appareils facilitant des actions complexes grâce au pouvoir de la pensée.

La manière dont la société réagirait à la généralisation d'une telle technologie est toutefois très controversée.