Les données sont l'élément vital de l'IA, mais elles ne constituent pas une ressource infinie. L'humanité peut-elle manquer de données ? Que se passera-t-il si c'est le cas ?

Les modèles d'IA complexes nécessitent de grandes quantités de données d'apprentissage. Par exemple, l'entraînement d'un grand modèle linguistique (LLM) comme ChatGPT nécessite environ 10 000 milliards de mots.

Certains experts estiment que l'offre de données de haute qualité s'amenuise. Par exemple, une étude réalisée en 2022 par des chercheurs de plusieurs universités déclarée, "Notre analyse indique que le stock de données linguistiques de haute qualité sera bientôt épuisé, probablement avant 2026... Notre travail suggère que la tendance actuelle à la croissance constante des modèles ML qui reposent sur d'énormes ensembles de données pourrait ralentir si l'efficacité des données n'est pas radicalement améliorée ou si de nouvelles sources de données ne deviennent pas disponibles."

Si la production de données synthétiques constitue une solution, elle ne permet généralement pas de saisir la profondeur, la nuance et la variance des données réelles.

Pour compliquer encore la situation, on s'interroge sur ce qui se passera lorsque l'IA commencera à consommer sa propre production, ce que les chercheurs de l'École polytechnique fédérale de Lausanne (EPFL), en Suisse, estiment être le cas. déjà en cours.

Leur recherche indique que les entreprises d'IA qui achètent des données produites par des humains sur des plateformes telles qu'Amazon Mechanical Turk pourraient recevoir des données générées par l'IA à la place.

Que se passe-t-il lorsque l'IA commence à manger sa propre production ? Peut-on l'éviter ?

La constitution d'ensembles de données est coûteuse et prend du temps - et les enjeux sont importants

Les données sont omniprésentes, mais les rendre opérationnelles pour l'IA est un processus complexe. La qualité des données et des étiquettes influe sur les performances du modèle.

Pour décrire brièvement le processus de constitution des ensembles de données, les annotateurs de données (ou étiqueteurs) prennent des données traitées (par exemple, une image recadrée) et les étiquettent. (par exemple, une voiture, une personne, un oiseau).

Les algorithmes disposent ainsi d'une "cible" à partir de laquelle ils peuvent apprendre. Les algorithmes extraient et analysent les caractéristiques des données étiquetées afin de prédire ces caractéristiques dans de nouvelles données inédites.

Cela est nécessaire pour l'apprentissage automatique supervisé, qui est l'une des branches principales de l'apprentissage automatique, avec l'apprentissage automatique non supervisé et l'apprentissage par renforcement. Par quelques estimationsLe processus de préparation et d'étiquetage des données occupe 80% de la durée d'un projet de modèle d'apprentissage automatique, mais si l'on prend trop de risques, on risque de compromettre les performances d'un modèle.

Outre les défis pratiques liés à la création d'ensembles de données de haute qualité, la nature même des données évolue constamment. Ce que l'on définissait comme un "ensemble de données contenant une sélection typique de véhicules sur la route" il y a dix ans n'est plus la même chose aujourd'hui. Aujourd'hui, on trouve un nombre beaucoup plus important de scooters et de vélos électriques sur les routes, par exemple.

Il s'agit de "cas marginaux", c'est-à-dire d'objets ou de phénomènes rares qui ne sont pas présents dans les ensembles de données.

Les modèles reflètent la qualité de leurs ensembles de données

Si vous entraînez un système d'IA moderne sur un ancien ensemble de données, le modèle risque d'être peu performant lorsqu'il sera exposé à de nouvelles données inédites.

Entre 2015 et 2020, des chercheurs ont mis au jour des biais structurels majeurs dans les algorithmes d'IA, en partie attribués à l'entraînement des modèles sur des données anciennes et biaisées.

Par exemple, le Visages étiquetés dans la maison sauvage (LFW)La base de données des visages de célébrités, couramment utilisée dans les tâches de reconnaissance faciale, se compose des éléments suivants 77,5% hommes et 83,5% peau blanche des individus. Une IA n'a aucune chance de fonctionner correctement si les données ne représentent pas toutes les personnes qu'elle est censée servir. Les taux d'erreur de reconnaissance faciale des meilleurs algorithmes se sont révélés aussi bas que 0,8% pour les hommes blancs et aussi élevés que 34,7% pour les femmes à la peau foncée.

Ces recherches ont abouti à la publication de l'ouvrage de référence Étude sur les nuances de genre et un documentaire intitulé Biais codéqui étudie la manière dont l'IA apprend probablement à partir de données erronées et non représentatives.

Les conséquences sont loin d'être anodines - cela a conduit à des décisions judiciaires erronées, à des emprisonnements injustifiés et à l'exclusion des femmes et d'autres groupes de l'emploi et du crédit.

Les IA ont besoin de davantage de données de haute qualité, qui doivent être équitables et représentatives - c'est une combinaison insaisissable.

Les données synthétiques sont-elles la solution ?

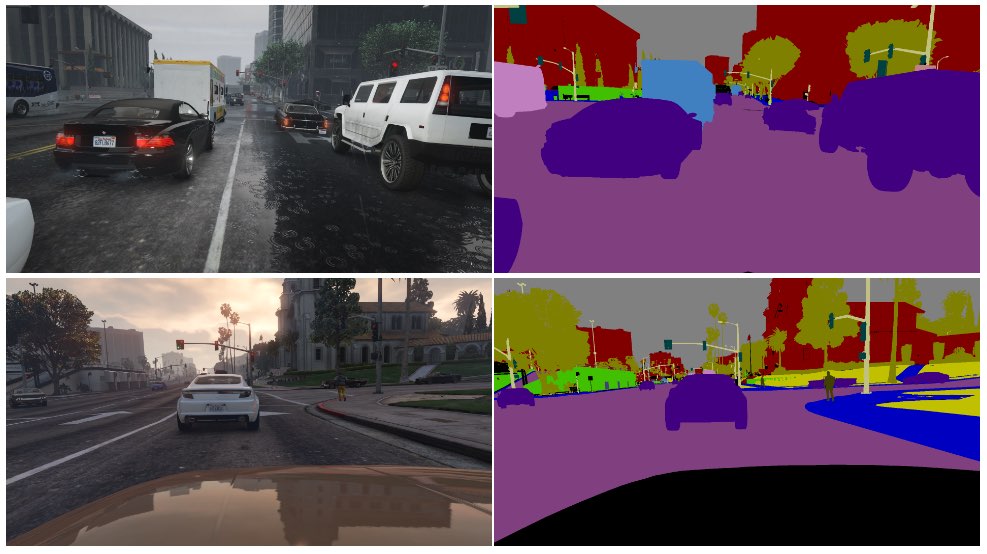

Les données synthétiques sont couramment utilisées dans le domaine de la vision artificielle, où les IA identifient des objets et des caractéristiques à partir d'images et de vidéos.

Au lieu de collecter des données d'image dans le monde réel - comme photographier ou filmer une rue - ce qui est techniquement difficile et pose des problèmes de confidentialité, vous générez simplement les données dans un environnement virtuel.

Bien que cela permette aux IA de disposer de plus de données, il y a plusieurs inconvénients :

- Modéliser des scénarios réels dans un environnement virtuel n'est pas simple.

- La production de grandes quantités de données synthétiques est encore coûteuse et prend du temps.

- Les cas limites et les valeurs aberrantes restent un problème.

- Il ne peut pas reproduire parfaitement la réalité.

- D'autre part, certains aspects peuvent être trop parfaits et il est difficile de déterminer ce qui manque.

En fin de compte, les données synthétiques sont excellentes pour les environnements facilement virtualisés, comme une usine, mais ne sont pas toujours adaptées aux environnements réels en mouvement rapide, comme les rues d'une ville.

Qu'en est-il de la génération de données textuelles synthétiques ?

Le texte est plus simple que les images ou les données vidéo. Des modèles comme ChatGPT peuvent-ils être utilisés pour générer des données d'entraînement synthétiques quasi infinies ?

Oui, mais c'est risqué et les conséquences ne sont pas faciles à prévoir. Si les données textuelles synthétiques peuvent aider à ajuster, tester et optimiser les modèles, elles ne sont pas idéales pour enseigner de nouvelles connaissances aux modèles et risquent de renforcer les préjugés et d'autres problèmes.

Voici une analogie qui montre pourquoi la formation d'IA avec des données générées par l'IA est problématique :

- Prenons l'exemple d'une école qui utilise tous les meilleurs manuels du monde pour former ses étudiants à tout ce qu'il faut savoir à partir de ses ressources en l'espace d'une journée.

- Ensuite, l'école commence à produire son propre travail sur la base de ces connaissances, à l'instar de la production d'un chatbot. Les étudiants ont appris à partir de toutes les données disponibles à la date du début de la formation, mais ils ne peuvent pas intégrer efficacement de nouvelles données dans le système de connaissances par la suite.

- La connaissance est créée chaque jour - alors que la grande majorité des connaissances humaines ont été créées avant un jour précis, la connaissance évolue et se transforme au fil du temps. Fait essentiel, les humains ne se contentent pas de créer constamment de nouvelles connaissances, ils changent également de point de vue sur les connaissances existantes.

- Supposons maintenant que l'école, à court de données, commence à enseigner à ses élèves en utilisant sa propre production. Les élèves commencent à "manger" leur contenu pour en produire un nouveau.

- À ce stade, la production des étudiants ne s'adapte pas au monde réel et son utilité diminue. Le système régurgite son propre travail. Bien que le travail puisse s'adapter et évoluer, il le fait de manière isolée par rapport à tout ce qui se trouve en dehors de cette boucle de rétroaction.

L'IA confronte constamment les gens à des énigmes à résoudre. celui-ci a beaucoup de les commentateurs sur Reddit et le Forum Y Combinator perplexe.

C'est un sujet déroutant, et il n'y a pas de véritable consensus sur les ramifications.

Les étiqueteurs de données humains utilisent souvent l'IA pour produire des données

Le problème de la production de données de formation de qualité comporte un autre aspect imprévu.

Les plateformes de crowdworking telles que Amazon Mechanical Turk (MTurk) sont régulièrement utilisés par les entreprises d'IA qui cherchent à produire de véritables ensembles de données "humaines". TIl est à craindre que les annotateurs de données sur ces plateformes utilisent des IA pour accomplir leurs tâches.

Des chercheurs de l'École polytechnique fédérale de Lausanne (EPFL), en Suisse, ont analysé les données créées par MTurk pour déterminer si les travailleurs utilisaient l'IA pour générer leurs soumissions.

L'étudepubliée le 13 juin, a demandé à 44 participants de MTurk de résumer les résumés de 16 articles de recherche médicale. L'étude a révélé que 33% à 46% des utilisateurs de la plateforme ont généré leurs soumissions à l'aide de l'IA, bien qu'il leur ait été demandé de répondre en langage naturel.

"Nous avons mis au point une méthodologie très spécifique qui a très bien fonctionné pour détecter les textes synthétiques dans notre scénario", explique Manoel Ribeiro, co-auteur de l'étude et doctorant à l'EPFL, a déclaré à The Register cette semaine.

Bien que l'ensemble des données et l'échantillon de l'étude soient assez restreints, il est loin d'être inconcevable de penser que les IA sont entraînées à leur insu sur du contenu généré par l'IA.

L'étude ne vise pas à blâmer les travailleurs de MTurk - les chercheurs notent que les bas salaires et le travail répétitif contribuent au problème. Les entreprises spécialisées dans l'IA veulent des données créées par des humains de la meilleure qualité possible tout en maintenant les coûts à un niveau bas. Un commentateur a déclaré sur Reddit : "Je suis actuellement l'un de ces travailleurs, chargé de former Bard. Je suis certain d'utiliser ChatGPT pour cela. 20$/h n'est pas suffisant pour l'horrible traitement que nous recevons, alors je vais tirer chaque centime de ce travail *******."

Le trou du lapin est encore plus profond, car les IA sont souvent formées à partir de données extraites de l'internet. Comme de plus en plus de contenus rédigés par l'IA sont publiés en ligne, l'IA apprendra inévitablement à partir de ses propres résultats.

Alors que les humains commencent à dépendre des IA pour obtenir des informations, la qualité de leurs résultats devient de plus en plus critique. Nous devons trouver des méthodes innovantes pour mettre à jour les IA avec des données fraîches et authentiques.

Comme l'explique M. Ribeiro, "les données humaines constituent l'étalon-or, car ce sont les êtres humains qui nous intéressent, et non les grands modèles de langage".

Le travail d'analyse de l'impact potentiel de l'IA consommant ses propres résultats est en cours, mais les données humaines authentiques restent essentielles pour un large éventail de tâches d'apprentissage automatique.

Générer de vastes quantités de données pour des IA affamées tout en gérant les risques est un travail en cours.