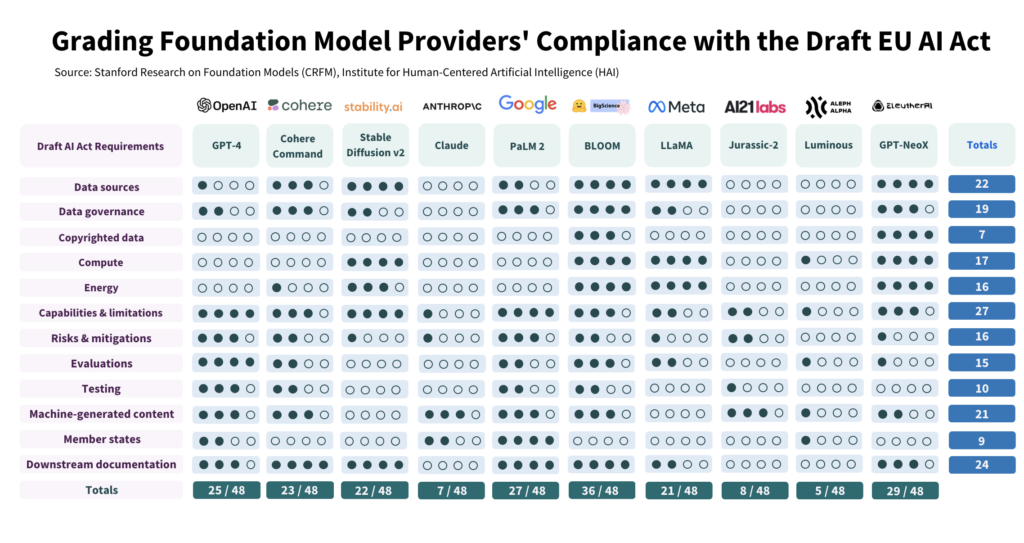

Des chercheurs en IA de Stanford ont évalué la conformité de 10 grands modèles d'IA à la proposition de loi européenne sur l'IA et ont constaté de grandes variations, avec des résultats généralement médiocres.

L'étude a examiné de manière critique 10 modèles d'IA au regard de 12 critères définis dans le projet de législation de l'UE et a mis en évidence de grandes différences dans la conformité, aucun modèle ne cochant toutes les cases.

L'étude met en évidence l'écart entre les attentes de la loi sur l'IA et les efforts de gouvernance actuellement déployés par les principaux développeurs d'IA.

Pour se conformer à la loi, les promoteurs doivent améliorer considérablement leur transparence et leurs stratégies d'atténuation des risques, qui sont presque totalement absentes dans certains cas.

Comment l'étude a été menée

Les auteurs ont procédé à une étude détaillée de la loi sur l'IA, dont ils ont extrait 22 exigences.

Parmi celles-ci, ils en ont sélectionné 12 qui pouvaient être évaluées de manière significative à l'aide d'informations publiques. Ils ont ensuite créé une grille d'évaluation en 5 points pour chacune de ces 12 exigences.

Le modèle d'IA open-source BLOOM, produit par Hugging Face, a obtenu le meilleur score avec un total de 36 points sur un total potentiel de 48.

À l'inverse, Anthropic, soutenue par Google, et la société allemande Aleph Alpha, spécialisée dans l'IA, ont obtenu des résultats nettement moins bons, avec des notes respectives de 7 et 5. ChatGPT se situe en milieu de peloton avec 25/48.

Les quatre principaux domaines de non-conformité sont les données protégées par le droit d'auteur, l'énergie, l'atténuation des risques et l'évaluation/le test.

L'un des auteurs, Kevin Klyman, chercheur au Centre de recherche sur les modèles de fondation de Stanford, a noté que la plupart des développeurs ne divulguent pas leurs stratégies d'atténuation des risques, ce qui pourrait être un facteur de rupture. Les fournisseurs ne divulguent souvent pas l'efficacité de leurs mesures d'atténuation des risques, ce qui signifie que nous ne pouvons pas dire à quel point certains modèles de fondation sont risqués", explique Kevin Klyman.

En outre, les données d'entraînement utilisées pour former les modèles varient considérablement. L'UE exigera des développeurs d'IA qu'ils soient plus transparents en ce qui concerne leurs sources de données, ce que 4/10 des développeurs ne font pas. ChatGPT n'a obtenu qu'un point dans ce domaine.

Modèles open source ou propriétaires

Le rapport a également mis en évidence une nette dichotomie en matière de conformité selon qu'il s'agit d'un modèle à source ouverte ou d'un modèle propriétaire.

Les modèles à source ouverte ont obtenu d'excellents résultats en ce qui concerne la divulgation des ressources et les exigences en matière de données, mais les risques qu'ils présentent sont en grande partie non documentés.

Les modèles propriétaires sont à l'opposé : ils sont fortement testés et très documentés, avec de solides stratégies d'atténuation des risques, mais ils ne sont pas transparents en ce qui concerne les données et les paramètres liés à la technologie.

Ou, pour être plus précis, les développeurs de logiciels libres n'ont pas autant de secrets de fabrication à protéger, mais leurs produits sont intrinsèquement plus risqués, car ils peuvent être utilisés et modifiés par presque tout le monde.

À l'inverse, les développeurs privés garderont probablement certains aspects de leurs modèles sous clé, mais pourront faire la preuve de leur sécurité et de l'atténuation des risques. Même Microsoft, le principal investisseur d'OpenAI, n'est pas totalement convaincu de l'efficacité de ses modèles. comprendre le fonctionnement des modèles de l'OpenAI.

Que recommande l'étude ?

Les auteurs de l'étude reconnaissent que l'écart entre les attentes de l'UE et la réalité est alarmant et formulent plusieurs recommandations à l'intention des décideurs politiques et des concepteurs de modèles.

L'étude recommande aux décideurs politiques de l'UE

- Affiner et préciser les paramètres de la loi européenne sur l'IA: Les chercheurs affirment que le langage technique et les paramètres de la loi sur l'IA ne sont pas assez précis.

- Promouvoir la transparence et la responsabilité: Les chercheurs affirment que les règles les plus strictes devraient être ultra ciblées sur les développeurs les plus importants et les plus dominants, ce qui devrait conduire à une application plus efficace.

- Fournir des ressources suffisantes pour l'application de la législation: Pour que la loi européenne sur l'IA soit effectivement appliquée, les ressources techniques et les talents doivent être mis à la disposition des agences chargées de l'application de la loi.

L'étude recommande aux décideurs politiques mondiaux

- Priorité à la transparence: Les chercheurs soulignent que la transparence est essentielle et qu'elle devrait être au centre des efforts politiques. Ils affirment que les leçons tirées de la réglementation des médias sociaux révèlent les conséquences néfastes d'un manque de transparence, qui ne devraient pas être répétées dans le contexte de l'IA.

- Clarifier les questions de droits d'auteur: Les limites du droit d'auteur pour les données d'apprentissage et les résultats de l'IA font l'objet d'un débat animé. Compte tenu de la faible conformité observée dans la divulgation des données d'entraînement protégées par le droit d'auteur, les chercheurs soutiennent que les lignes directrices juridiques doivent préciser comment le droit d'auteur interagit avec les procédures d'entraînement et les résultats des modèles génératifs. Il s'agit notamment de définir les conditions dans lesquelles les droits d'auteur ou les licences doivent être respectés pendant la formation et de déterminer comment le contenu généré par la machine peut enfreindre les droits d'auteur.

L'étude recommande aux développeurs de modèles de fondations :

- S'efforcer de s'améliorer en permanence: Les fournisseurs devraient toujours s'efforcer d'améliorer leur conformité. Les grands fournisseurs, comme OpenAI, devraient montrer l'exemple et diffuser des ressources aux clients en aval qui accèdent à leurs modèles par l'intermédiaire de l'API.

- Défendre les normes du secteur: Les fournisseurs de modèles devraient contribuer à l'établissement de normes sectorielles, ce qui peut conduire à un écosystème de l'IA plus transparent et responsable.

Si les normes de risque et de contrôle établies par des développeurs de premier plan comme OpenAI présentent certains aspects positifs, les lacunes dans des domaines tels que le droit d'auteur sont loin d'être idéales.

Quant à l'application de la réglementation à l'IA en tant que catégorie globale - cela pourrait s'avérer très délicat - car les modèles commerciaux et open-source sont structurellement distincts et difficiles à mettre dans le même sac.