Alibaba ha publicado más de 100 modelos de IA de código abierto, entre ellos Qwen 2.5 72B, que supera a otros modelos de código abierto en pruebas matemáticas y de codificación.

Gran parte de la atención de la industria de la IA en modelos de código abierto se ha centrado en los esfuerzos de Meta con Llama 3, pero Qwen 2.5 de Alibaba ha acortado distancias de forma significativa. La recién estrenada familia de modelos Qwen 2.5 tiene un tamaño que va de 0,5 a 72.000 millones de parámetros, con modelos base generalizados y modelos centrados en tareas muy específicas.

Alibaba afirma que estos modelos vienen con "conocimientos mejorados y capacidades más sólidas en matemáticas y codificación", con modelos especializados centrados en la codificación, las matemáticas y múltiples modalidades, como el lenguaje, el audio y la visión.

Alibaba Cloud también ha anunciado una actualización de su modelo insignia Qwen-Max, que no ha publicado como código abierto. Los benchmarks de Qwen 2.5 Max tienen buena pinta, pero es el modelo Qwen 2.5 72B el que ha generado más expectación entre los aficionados al código abierto.

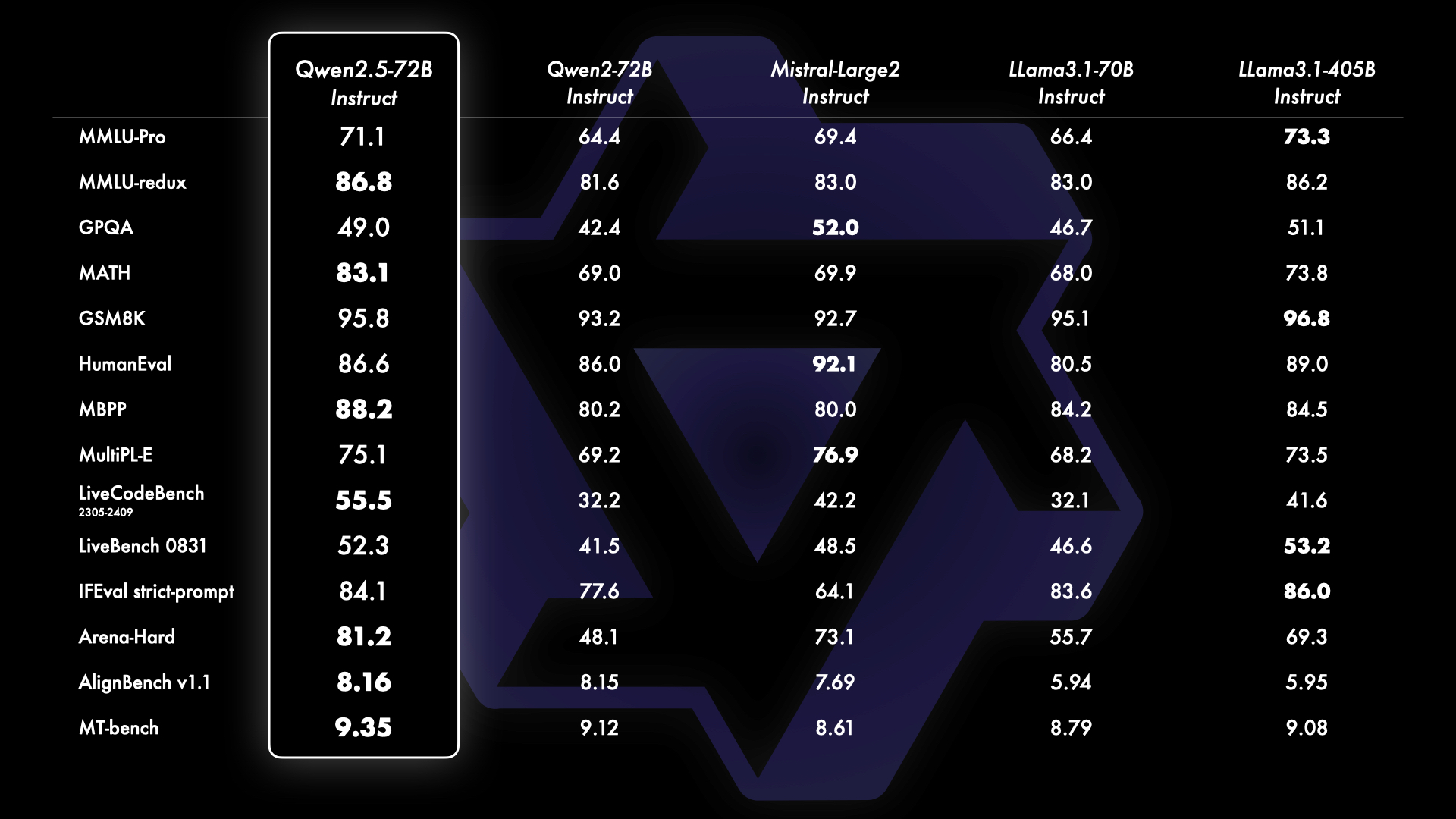

Las pruebas muestran que Qwen 2.5 72B supera al buque insignia de Meta, mucho más grande. Llama 3.1 405B en varios frentes, especialmente en matemáticas y codificación. La brecha entre los modelos de código abierto y los propietarios, como los de OpenAI y Google, también se está cerrando rápidamente.

Los primeros usuarios de Qwen 2.5 72B muestran que el modelo se sitúa justo por debajo de Sonnet 3.5 e incluso supera a OpenAImodelos o1 en codificación.

El código abierto Qwen 2.5 supera a los modelos o1 en codificación 🤯🤯

Qwen 2.5 supera a los modelos o1 en codificación en Livebench AI

Qwen está justo por debajo de Sonnet 3.5, y para un modo de código abierto, ¡¡¡eso es impresionante!!!

o1 es bueno en codificación difícil pero terrible en problemas de completado de código y... pic.twitter.com/iazam61eP9

- Bindu Reddy (@bindureddy) 20 de septiembre de 2024

Alibaba afirma que estos nuevos modelos se han entrenado con su conjunto de datos a gran escala, que abarca hasta 18 billones de tokens. Los modelos Qwen 2.5 vienen con una ventana de contexto de hasta 128k y pueden generar resultados de hasta 8k tokens.

El paso a modelos libres más pequeños, más capaces y de código abierto tendrá probablemente un mayor impacto en muchos usuarios que los modelos más avanzados como o1. Las capacidades de borde y en el dispositivo de estos modelos significan que se puede obtener una gran cantidad de kilometraje de un modelo libre que se ejecuta en su ordenador portátil.

El modelo Qwen 2.5, más pequeño, ofrece codificación de nivel GPT-4 por una fracción del coste, o incluso gratis si tienes un portátil decente para ejecutarlo localmente.

¡Tenemos GPT-4 para codificar en casa! He buscado OpenAI?ref_src=twsrc%5Etfw”>@OpenAI GPT-4 0613 para varios puntos de referencia y los comparó con @Alibaba_Qwen 2,5 7B codificador. 👀

> 15 meses después del lanzamiento de GPT-0613, tenemos un LLM abierto bajo Apache 2.0, que rinde igual de bien. 🤯

> GPT-4 precios... pic.twitter.com/2szw5kwTe5

- Philipp Schmid (@_philschmid) 22 de septiembre de 2024

Además de los LLM, Alibaba ha lanzado una importante actualización de su modelo de lenguaje de visión con la introducción de Qwen2-VL. Qwen2-VL puede comprender vídeos de más de 20 minutos y responder a preguntas en vídeo.

Está diseñado para su integración en teléfonos móviles, automóviles y robots con el fin de permitir la automatización de operaciones que requieren comprensión visual.

Alibaba también presentó un nuevo modelo de texto a vídeo como parte de su generador de imágenes, la gran familia de modelos Tongyi Wanxiang. Tongyi Wanxiang AI Video puede producir contenidos de vídeo de calidad cinematográfica y animación 3D con diversos estilos artísticos a partir de indicaciones de texto.

Las demostraciones son impresionantes y la herramienta es gratuita, aunque se necesita un número de móvil chino para acceder a ella. inscríbase aquí. Sora va a tener una seria competencia cuando, o si, OpenAI finalmente lo lance.