Cuando ChatGPT le da la respuesta correcta a su pregunta, ¿razona la petición o simplemente recuerda la respuesta a partir de sus datos de entrenamiento?

Los investigadores del Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL) del MIT diseñaron una serie de pruebas para comprobar si los modelos de IA "piensan" o simplemente tienen buena memoria.

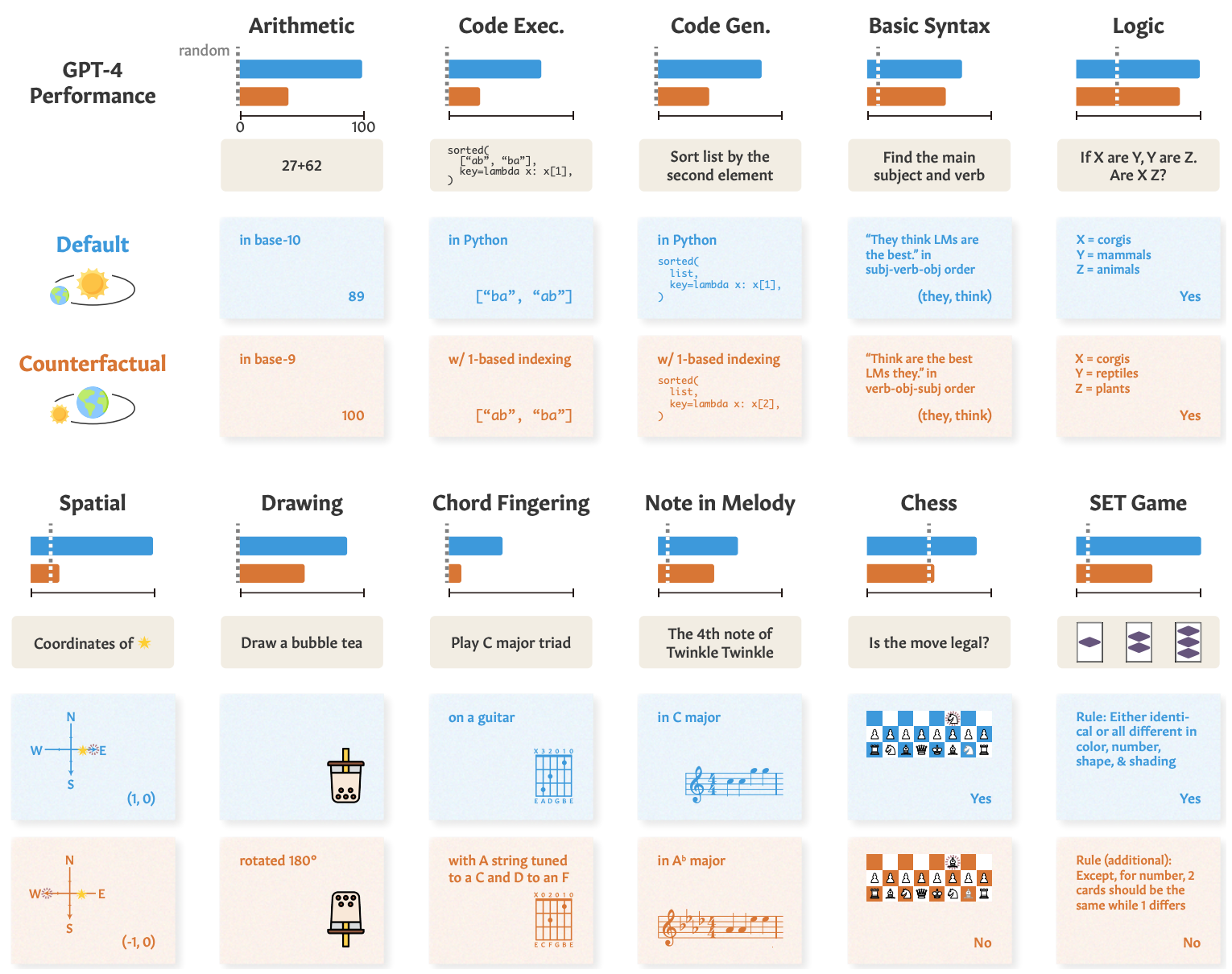

Cuando le pides a un modelo de IA que resuelva un problema matemático como "¿Cuánto es 27+62?", responde rápidamente con la respuesta correcta: 89. Cómo podemos saber si entiende la aritmética subyacente o simplemente vio el problema en sus datos de entrenamiento?

En su papel, los investigadores probaron GPT-4, GPT-3.5 Turbo, Claude 1.3 y PaLM2 para ver si podían "generalizar no sólo a instancias no vistas de tareas conocidas, sino a tareas nuevas".

Diseñaron una serie de 11 tareas que diferían ligeramente de las tareas estándar en las que los LLM suelen rendir bien.

Los LLM deberían rendir igual de bien con las "tareas contrafactuales" si emplean procedimientos de resolución de tareas generales y transferibles.

Si un LLM "entiende" de matemáticas, entonces debería dar la respuesta correcta a un problema matemático en base-10 y en la poco utilizada base-9, por ejemplo.

He aquí algunos ejemplos de las tareas y el rendimiento de GPT-4.

El rendimiento de la GPT-4 en pruebas estándar (línea azul) es bueno, pero sus capacidades matemáticas, de razonamiento lógico y espacial, entre otras (línea naranja), se degradan significativamente cuando se altera ligeramente la tarea.

Los demás modelos mostraron una degradación similar, con GPT-4 a la cabeza.

A pesar de la degradación, el rendimiento en las tareas contrafácticas seguía siendo mejor que el azar. Los modelos de IA intentan razonar estas tareas, pero no lo hacen muy bien.

Los resultados muestran que el impresionante rendimiento de los modelos de IA en tareas como los exámenes universitarios se basa en un excelente recuerdo de los datos de entrenamiento, no en el razonamiento. Esto pone aún más de relieve que los modelos de IA no pueden generalizarse a tareas no vistas,

Zhaofeng Wu, estudiante de doctorado en Ingeniería Eléctrica e Informática del MIT, afiliado al CSAIL y autor principal del artículo, afirma: "Hemos descubierto un aspecto fascinante de los grandes modelos lingüísticos: destacan en escenarios familiares, casi como un camino trillado, pero tienen dificultades cuando el terreno se vuelve desconocido. Este dato es crucial para mejorar la adaptabilidad de estos modelos y ampliar sus horizontes de aplicación".

Vimos una demostración similar de esta incapacidad para generalizar cuando exploramos lo malos que son los modelos de IA en resolver un rompecabezas simplificado para cruzar un río.

Los investigadores concluyeron que, cuando los desarrolladores analizan sus modelos, deben "considerar la capacidad abstracta de la tarea como algo independiente del rendimiento observado en la tarea."

El enfoque "entrenar para probar" puede hacer que un modelo ascienda en los puntos de referencia, pero no ofrece una medida real de cómo se comportará el modelo cuando se le presente una nueva tarea para razonar.

Los investigadores sugieren que parte del problema radica en que estos modelos sólo se entrenan con texto de forma superficial.

Si los LLM están expuestos a más datos contextualizados del mundo real y a una representación semántica, podrían ser capaces de generalizar cuando se les presenten variaciones de la tarea.