Los grandes modelos lingüísticos como el GPT-4o pueden realizar tareas increíblemente complejas, pero incluso los modelos más avanzados se enfrentan a algunos retos básicos de razonamiento que los niños pueden resolver.

En una entrevista con la CBS, el "padrino de la IA", Geoffrey Hinton, afirmó que los sistemas de IA podrían ser más inteligentes de lo que creemos y que existe la posibilidad de que las máquinas tomen el control.

Cuando se le preguntó por el nivel de la tecnología de IA actual, Hinton afirmó: "Creo que estamos entrando en un periodo en el que, por primera vez, podemos tener cosas más inteligentes que nosotros".

Yann LeCun, científico jefe de IA de Meta, nos quiere hacer creer que estamos muy lejos de ver que la IA alcance incluso una inteligencia "de nivel canino".

Entonces, ¿cuál es?

Esta semana, los usuarios de X han publicado ejemplos de la increíble capacidad de codificación de Anthropic. nuevo Claude modelo exposiciones. Otros realizaron experimentos para poner de manifiesto que los modelos de IA siguen teniendo dificultades para razonar de forma muy básica.

Puzzle del cruce del río

El clásico rompecabezas del cruce de ríos tiene múltiples variantes, pero Versión de Wikipedia lo resume así:

Un granjero con un lobo, una cabra y una col debe cruzar un río en barca. La barca sólo puede transportar al granjero y un único objeto. Si se quedan juntos sin vigilancia, el lobo se comería a la cabra, o la cabra se comería la col. ¿Cómo pueden cruzar el río sin que se coman nada?

Encontrar la solución requiere algo de planificación básica y razonamiento sobre distintos escenarios, pero no es un problema especialmente difícil de resolver. Si eres humano.

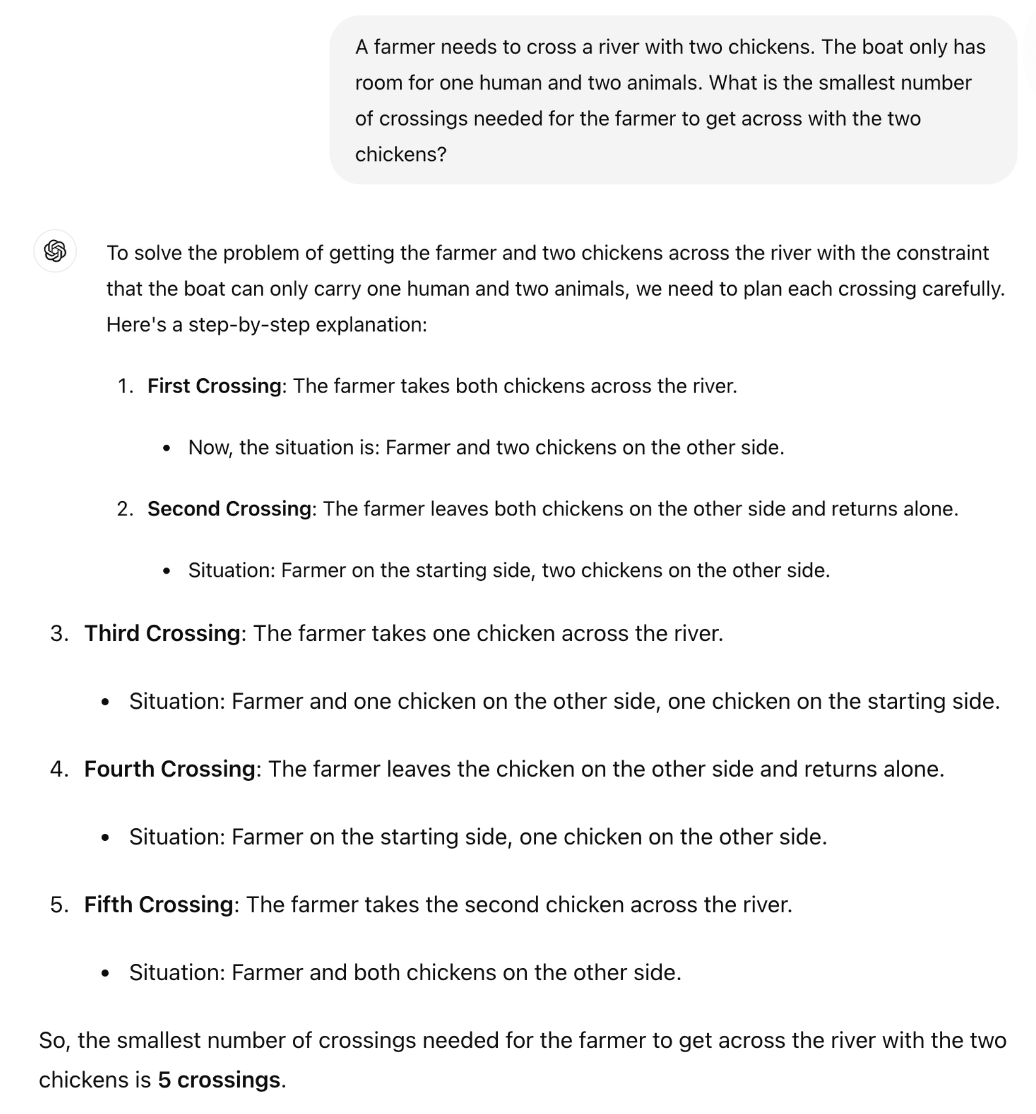

¿Puede GPT-4o resolverlo? Si copias y pegas el puzzle en ChatGPT te da la respuesta correcta, pero esa página de Wikipedia estaba casi seguro en sus datos de entrenamiento.

¿Y si simplificáramos mucho el puzzle y lo cambiáramos ligeramente para que el LLM no pudiera confiar en sus datos de entrenamiento?

El catedrático británico de Matemáticas Sir William Timothy Gowers mostró cómo la incapacidad de los LLM para aplicar la lógica queda fácilmente al descubierto.

La respuesta correcta al enigma es que sólo se necesita un viaje. Pero parece que ChatGPT está intentando recordar una respuesta en lugar de simplemente razonar el enigma.

¿Es mejor el Soneto 3.5 de Claude?

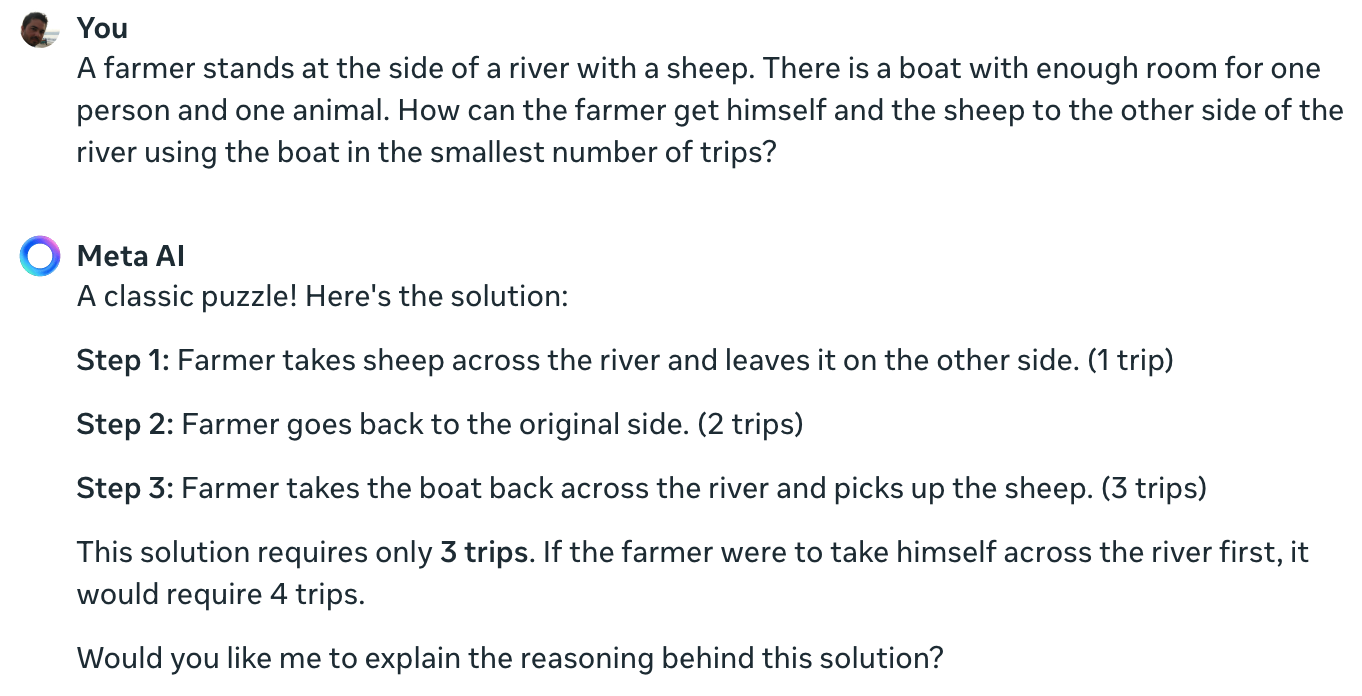

El experimento del científico de metadatos Colin Fraser confirma que ni siquiera el principal modelo de IA disponible en la actualidad puede resolver este sencillo rompecabezas.

Claude sigue sin poder resolver el problema imposible de un granjero, una oveja, un barco pic.twitter.com/TU13wermLZ

- Colin Fraser (@colin_fraser) 20 de junio de 2024

Puede que haya sido poco sincero por parte de un científico de datos de Meta no mostrar sus resultados utilizando Llama 3.

Hice la misma pregunta a Meta AI y también se equivoca por completo.

Yann LeCun explicó la razón de estos resultados diciendo: "La cuestión es que los LLM no tienen sentido común, ni comprensión del mundo, ni capacidad para planificar (y razonar)".

¿Es eso cierto, o hay algo más en juego?

Lo que estas interacciones podrían revelar no es una falta de capacidad de razonamiento, sino hasta qué punto el resultado de un LLM está influido por sus datos de entrenamiento. La respuesta de Meta AI, que llama a esto un "rompecabezas clásico", insinúa que esto podría ser lo que está sucediendo.

Las variaciones del rompecabezas del cruce del río a menudo hacen referencia a la cantidad de "viajes" necesarios. Cuando planteas el puzle sin usar esa palabra, el LLM lo resuelve.

Efectivamente. Cuando no aparece la pregunta "viajes", que me trae recuerdos de las soluciones anteriores de tantos problemas similares, sino la pregunta "la forma más rápida posible" junto con COT, responde correctamente pic.twitter.com/E27vBv2y2R

- AnKo (@anko_979) 21 de junio de 2024

Estos experimentos fueron interesantes, pero no responden definitivamente a la discusión sobre si los modelos de IA son realmente inteligentes o simplemente máquinas de predicción casi simbólicas.

Sin embargo, los resultados ponen de manifiesto lo susceptibles que son los LLM a los datos de entrenamiento. Cuando GPT-4o supera los exámenes del LSAT, ¿está "pensando" para encontrar las respuestas a los problemas o las está recordando?

Hasta que los ingenieros no entiendan lo que ocurre dentro de las cajas negras de IA que han creado, las discusiones sobre X seguirán sin resolverse.