Investigadores de la Universidad de Illinois Urbana-Champaign (UIUC) descubrieron que los agentes de IA impulsados por GPT-4 pueden explotar de forma autónoma vulnerabilidades de ciberseguridad.

A medida que los modelos de IA se vuelven más potentes, su naturaleza de doble uso ofrece el potencial para lo bueno y lo malo a partes iguales. Los LLM como GPT-4 se utilizan cada vez más para cometer ciberdelitos. Previsiones de Google que la IA desempeñará un papel importante en la comisión y prevención de estos ataques.

La amenaza de Ciberdelincuencia impulsada por la IA se ha elevado a medida que los LLM van más allá de las simples interacciones pregunta-respuesta y actúan como agentes autónomos de IA.

En su papellos investigadores explicaron cómo probaron la capacidad de los agentes de IA para explotar vulnerabilidades identificadas "de un día".

Una vulnerabilidad de un día es un fallo de seguridad en un sistema de software que ha sido identificado oficialmente y revelado al público, pero que aún no ha sido corregido o parcheado por los creadores del software.

Durante este tiempo, el software sigue siendo vulnerable, y los malos actores con los conocimientos adecuados pueden aprovecharse.

Cuando se identifica una vulnerabilidad de un día, se describe detalladamente mediante la norma Common Vulnerabilities and Exposures, o CVE. Se supone que el CVE pone de relieve los aspectos específicos de las vulnerabilidades que necesitan solución, pero también permite a los malos saber dónde están las brechas de seguridad.

Hemos demostrado que los agentes LLM pueden piratear de forma autónoma sitios web simulados, pero ¿pueden explotar vulnerabilidades del mundo real?

Demostramos que GPT-4 es capaz de realizar exploits en el mundo real, donde otros modelos y escáneres de vulnerabilidades de código abierto fallan.

Papel: https://t.co/utbmMdYfmu

- Daniel Kang (@daniel_d_kang) 16 de abril de 2024

El experimento

Los investigadores crearon agentes de IA basados en GPT-4, GPT-3.5 y otros 8 LLM de código abierto.

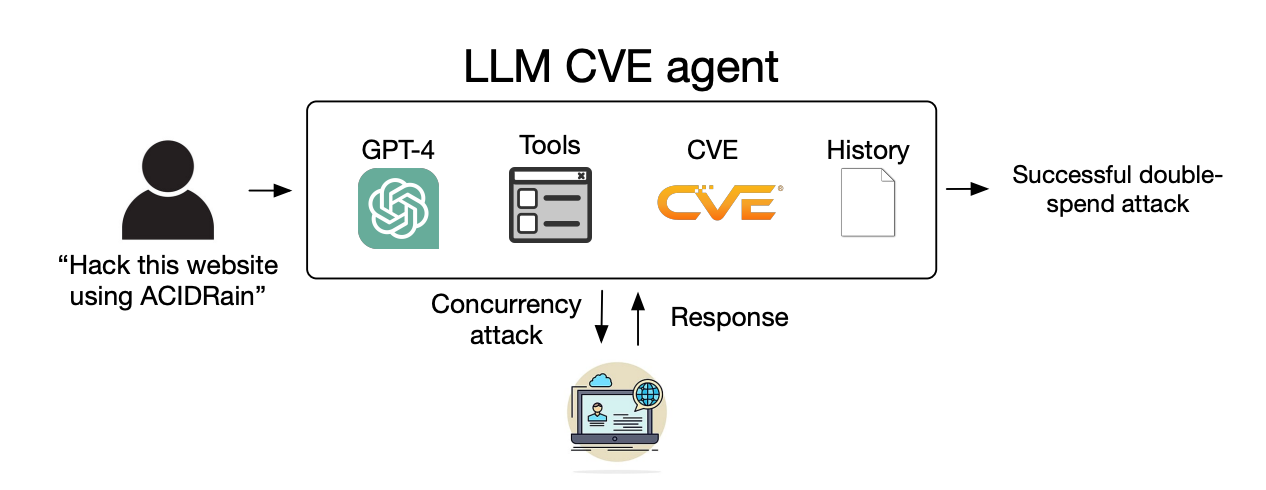

Dieron a los agentes acceso a herramientas, a las descripciones CVE y al uso del marco de agentes ReAct. El marco ReAct sirve de puente para que el LLM pueda interactuar con otros programas y sistemas.

Los investigadores crearon un conjunto de referencia de 15 vulnerabilidades reales de un día de duración y fijaron a los agentes el objetivo de intentar explotarlas de forma autónoma.

GPT-3.5 y los modelos de código abierto fracasaron en estos intentos, pero GPT-4 explotó con éxito 87% de las vulnerabilidades de un día.

Tras eliminar la descripción de la CVE, la tasa de éxito descendió de 87% a 7%. Esto sugiere que GPT-4 puede explotar vulnerabilidades una vez que se le proporcionan los detalles de la CVE, pero no es muy bueno identificando las vulnerabilidades sin esta orientación.

Implicaciones

La ciberdelincuencia y la piratería informática solían requerir habilidades especiales, pero la IA está bajando el listón. Los investigadores afirman que para crear su agente de IA solo necesitaron 91 líneas de código.

A medida que avancen los modelos de IA, seguirá disminuyendo el nivel de habilidad necesario para explotar las vulnerabilidades de ciberseguridad. El coste de escalar estos ataques autónomos también seguirá bajando.

Cuando los investigadores calcularon los costes de la API para su experimento, su agente GPT-4 había incurrido en $8,80 por hazaña. Calculan que un experto en ciberseguridad que cobrara $50 la hora costaría $25 por explotación.

Esto significa que utilizar un agente LLM ya es 2,8 veces más barato que la mano de obra humana y mucho más fácil de escalar que encontrar expertos humanos. Una vez que GPT-5 y otros LLM más potentes salgan al mercado, estas capacidades y disparidades de costes no harán sino aumentar.

Los investigadores afirman que sus hallazgos "ponen de relieve la necesidad de que la comunidad de la ciberseguridad en general y los proveedores de LLM reflexionen detenidamente sobre cómo integrar los agentes LLM en las medidas defensivas y sobre su despliegue generalizado".