La carrera por un hardware de inteligencia artificial más potente y eficiente se ha acelerado esta semana con el anuncio por parte de Intel y Google de nuevos chips que les ayudarán a depender menos de la tecnología de NVIDIA.

Parece que cada semana se publican nuevos modelos de IA. Detrás de cada lanzamiento hay semanas de entrenamiento en centros de datos de computación en la nube, la mayoría de los cuales funcionan con GPU NVIDIA.

Intel y Google han anunciado nuevos chips internos de IA que pueden entrenar y desplegar grandes modelos de IA con mayor rapidez y menor consumo de energía.

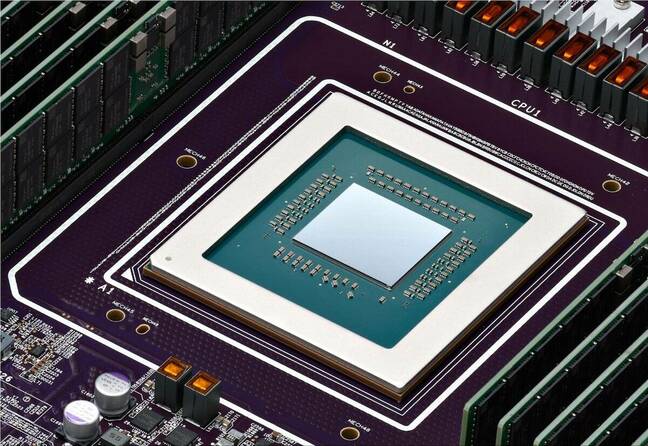

Chip acelerador de IA Gaudi 3 de Intel

Intel es probablemente más conocida por los chips que hacen funcionar su PC, pero el martes la empresa anunciado su nuevo chip de IA llamado Gaudí 3.

H100 de NVIDIA Las GPU han formado el grueso de los centros de datos de IA, pero Intel afirma que Gaudi 3 ofrece "50% de media mejor inferencia y 40% de media mejor eficiencia energética que Nvidia H100, a una fracción del coste".

Un factor que contribuye en gran medida a la eficiencia energética de Gaudí 3 es que Intel ha utilizado el proceso de 5 nm de Taiwan Semiconductor Manufacturing Co para fabricar los chips.

Intel no dio información sobre precios, pero cuando se le preguntó cómo se comparaba con los productos de NVIDIA, Das Kamhout, vicepresidente de software Xeon en Intel, dijo: "Esperamos que sea muy competitivo."

Dell Technologies, Hewlett Packard Enterprise, Lenovo y Supermicro serán las primeras en implantar Gaudí 3 en sus centros de datos de IA.

El CEO de Intel, Pat Gelsinger, resumió las ambiciones de IA de la compañía diciendo que "Intel está llevando la IA a todas partes en la empresa, desde el PC hasta el centro de datos y la periferia."

En #IntelGaudí 3 #AI ofrece una alternativa altamente competitiva al H100 de NVIDIA con mayor rendimiento, mayor escalabilidad e integración de PyTorch. Explora más ventajas clave del producto. https://t.co/sXdQKjYFw0 pic.twitter.com/iJSndBQkvT

- Intel AI (@IntelAI) 9 de abril de 2024

Actualizaciones de Google Arm y TPU

Google anunció el martes su primer CPU basadas en Arm que planea utilizar para alimentar sus centros de datos. El nuevo chip, denominado Axion, es un competidor directo de las CPU de Intel y AMD.

Google afirma que Axion ofrece "30% más de rendimiento que las instancias de propósito general basadas en Arm más rápidas disponibles actualmente en la nube, hasta 50% más de rendimiento y hasta 60% más de eficiencia energética que las instancias comparables basadas en x86 de generación actual".

Google ha trasladado varios de sus servicios, como YouTube y Google Earth, a su actual generación de servidores basados en Arm, que pronto se actualizarán con los chips Axion.

Disponer de una potente opción basada en Arm facilita a los clientes la migración de sus aplicaciones de entrenamiento, inferencias y otras aplicaciones de IA basadas en CPU a la plataforma en la nube de Google sin tener que rediseñarlas.

Para el entrenamiento de modelos a gran escala, Google ha confiado en gran medida en sus chips TPU como alternativa al hardware de NVIDIA. Estos también se actualizarán con un nuevo TPU v5p que ahora contiene más del doble de chips que el actual TPU v4.

TPU v5p, nuestra TPU más potente y escalable, ya está disponible. #GoogleCloudNext pic.twitter.com/mmfWlzHeqs

- Google Cloud Tech (@GoogleCloudTech) 9 de abril de 2024

Google no busca vender ni sus nuevos chips Arm ni las TPU. La compañía busca impulsar sus servicios de computación en la nube en lugar de convertirse en un competidor directo de NVIDIA en hardware.

Las TPU mejoradas supondrán un impulso para la tecnología de Google. Hiperordenador de IA que permite entrenar modelos de IA a gran escala. El hiperordenador de IA también utiliza GPUs NVIDIA H100 que, según Google, pronto serán sustituidas por las nuevas GPU Blackwell.

La demanda de chips de inteligencia artificial no parece que vaya a ralentizarse a corto plazo, y la carrera de NVIDIA ya no parece tan reñida como antes.