Los investigadores de Google desarrollaron una técnica llamada Infini-attention, que permite a los LLM manejar textos infinitamente largos sin aumentar los requisitos de computación y memoria.

La arquitectura Transformer de un LLM es lo que le permite prestar atención a todos los tokens de un prompt. La complejidad de las multiplicaciones matriciales y de productos de puntos que realiza es cuadrática.

Esto significa que duplicar los tokens de tu prompt supone una necesidad cuatro veces mayor de memoria y potencia de procesamiento. Por eso es tan difícil hacer LLM con grandes ventanas contextuales sin que se disparen los requisitos de memoria y computación.

En un LLM "estándar", la información del principio del contenido del prompt se pierde una vez que el prompt se hace más grande que la ventana contextual. Google trabajo de investigación explica cómo Infini-attention puede retener datos más allá de la ventana contextual.

Google presenta Leave No Context Behind: Transformadores eficientes de contexto infinito con Infini-atención

El modelo 1B, ajustado a secuencias de hasta 5.000 claves de paso, resuelve el problema de las secuencias de 1M de longitud.https://t.co/zyHMt3inhi pic.twitter.com/ySYEMET9Ef

- Aran Komatsuzaki (@arankomatsuzaki) 11 de abril de 2024

¿Cómo funciona Infini-attention?

Infini-attention combina técnicas de memoria compresiva con mecanismos de atención modificados para que no se pierda la información relevante más antigua.

Una vez que la solicitud de entrada crece más allá de la longitud de contexto del modelo, la memoria compresiva almacena la información en un formato comprimido en lugar de descartarla.

Esto permite almacenar información más antigua y menos relevante de forma inmediata sin que los requisitos de memoria y computación aumenten indefinidamente a medida que crece la entrada de datos.

En lugar de intentar retener toda la información de entrada más antigua, la memoria compresiva de Infini-attention pondera y resume la información que se considera relevante y digna de ser retenida.

Infini-attention toma entonces un mecanismo de atención "vainilla" pero reutiliza los estados de valor clave (KV) de cada segmento posterior del modelo en lugar de descartarlos.

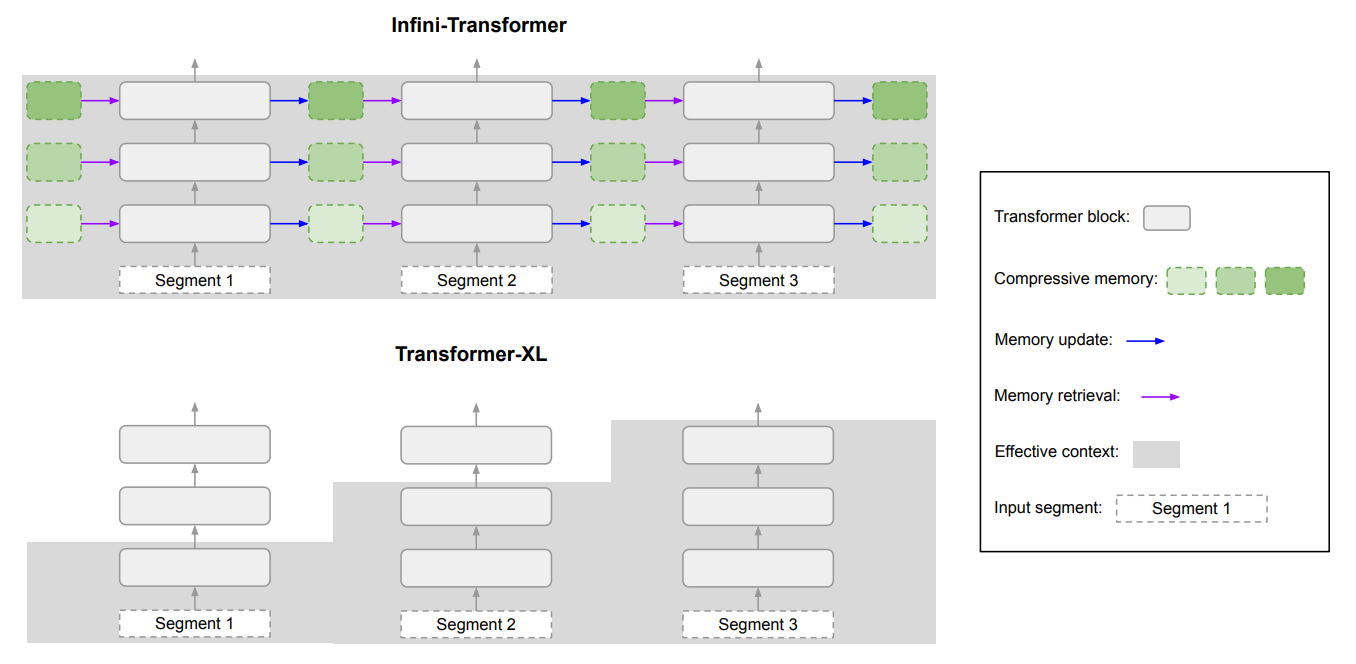

He aquí un diagrama que muestra la diferencia entre Infini-attention y otro modelo de contexto ampliado Transformer XL.

El resultado es un LLM que presta atención local a los datos de entrada recientes, pero que también lleva continuamente destilados datos históricos comprimidos a los que puede aplicar atención a largo plazo.

El artículo señala que "esta sutil pero crítica modificación de la capa de atención permite a las LLM procesar contextos infinitamente largos con recursos limitados de memoria y computación."

¿Es bueno?

Google realizó pruebas comparativas utilizando modelos Infini-attention más pequeños de 1B y 8B parámetros. Se compararon con otros modelos de contexto ampliado, como Transformer-XL y Memorizing Transformers.

El Infini-Transformer obtuvo puntuaciones de perplejidad significativamente más bajas que los demás modelos al procesar contenidos de texto largo. Una puntuación de perplejidad más baja significa que el modelo está más seguro de sus predicciones de salida.

En las pruebas de "recuperación de claves de acceso", los modelos Infini-attention encontraron sistemáticamente el número aleatorio oculto en un texto de hasta 1 millón de fichas.

Otros modelos a menudo consiguen recuperar la clave de acceso hacia el final de la entrada, pero tienen dificultades para encontrarla en medio o al principio de contenidos largos. Infini-attention no tuvo problemas en esta prueba.

Las pruebas comparativas son muy técnicas, pero la conclusión es que Infini-attention superó a los modelos de referencia a la hora de resumir y gestionar secuencias largas, manteniendo el contexto durante periodos prolongados.

Y lo que es más significativo, mantuvo esta capacidad de retención superior al tiempo que requería 114 veces menos memoria.

Los resultados de las pruebas de referencia convencen a los investigadores de que Infini-attention podría escalarse para manejar secuencias de entrada extremadamente largas manteniendo limitados los recursos de memoria y computación.

La naturaleza plug-and-play de Infini-attention significa que podría utilizarse para el preentrenamiento continuo y la puesta a punto de los modelos Transformer existentes. De este modo se podrían ampliar eficazmente sus ventanas contextuales sin necesidad de volver a entrenar completamente el modelo.

Las ventanas de contexto seguirán creciendo, pero este enfoque demuestra que una memoria eficiente podría ser una solución mejor que una gran biblioteca.