Los ingenieros de Apple han desarrollado un sistema de IA que resuelve referencias complejas a entidades en pantalla y conversaciones de usuario. Este modelo ligero podría ser una solución ideal para los asistentes virtuales en los dispositivos.

Los humanos somos buenos resolviendo referencias en las conversaciones entre nosotros. Cuando utilizamos términos como "el de abajo" o "él" entendemos a qué se refiere la persona basándonos en el contexto de la conversación y en cosas que podemos ver.

Para un modelo de inteligencia artificial es mucho más difícil. Los LLM multimodales, como GPT-4, responden bien a preguntas sobre imágenes, pero son caros de entrenar y requieren una gran carga computacional para procesar cada consulta sobre una imagen.

Los ingenieros de Apple adoptaron un enfoque diferente con su sistema, llamado ReALM (Reference Resolution As Language Modeling). El periódico para más detalles sobre su proceso de desarrollo y pruebas.

ReALM utiliza un LLM para procesar entidades conversacionales, en pantalla y de fondo (alarmas, música de fondo) que conforman las interacciones de un usuario con un agente virtual de IA.

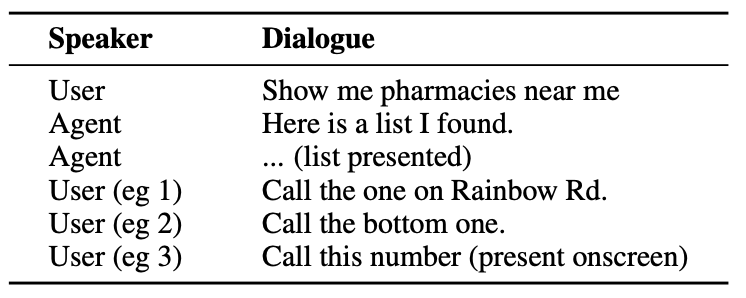

He aquí un ejemplo del tipo de interacción que un usuario podría tener con un agente de IA.

El agente necesita entender entidades conversacionales como el hecho de que cuando el usuario dice "el uno" se está refiriendo al número de teléfono de la farmacia.

También necesita entender el contexto visual cuando el usuario dice "el de abajo", y aquí es donde el enfoque de ReALM difiere de modelos como GPT-4.

ReALM se basa en codificadores anteriores para analizar primero los elementos de la pantalla y sus posiciones. A continuación, ReALM reconstruye la pantalla en representaciones puramente textuales de izquierda a derecha y de arriba abajo.

En términos sencillos, utiliza el lenguaje natural para resumir la pantalla del usuario.

Ahora, cuando un usuario hace una pregunta sobre algo que aparece en la pantalla, el modelo lingüístico procesa la descripción textual de la pantalla en lugar de tener que utilizar un modelo de visión para procesar la imagen en pantalla.

Los investigadores crearon conjuntos de datos sintéticos de entidades conversacionales, en pantalla y de fondo, y probaron ReALM y otros modelos para comprobar su eficacia a la hora de resolver referencias en sistemas conversacionales.

La versión más pequeña de ReALM (80M parámetros) obtuvo resultados comparables a los de GPT-4 y su versión más grande (3B parámetros) supera sustancialmente a GPT-4.

ReALM es un modelo diminuto en comparación con GPT-4. Su resolución de referencia superior lo convierte en la opción ideal para un asistente virtual que pueda existir en el dispositivo sin comprometer el rendimiento.

ReALM no funciona tan bien con imágenes más complejas o peticiones de usuario más matizadas, pero podría funcionar bien como asistente virtual en el coche o en el dispositivo. Imagina que Siri pudiera "ver" la pantalla de tu iPhone y responder a referencias a elementos en pantalla.

Apple ha tardado un poco en despegar, pero los últimos avances, como su Modelo MM1 y ReALM muestran que ocurren muchas cosas a puerta cerrada.