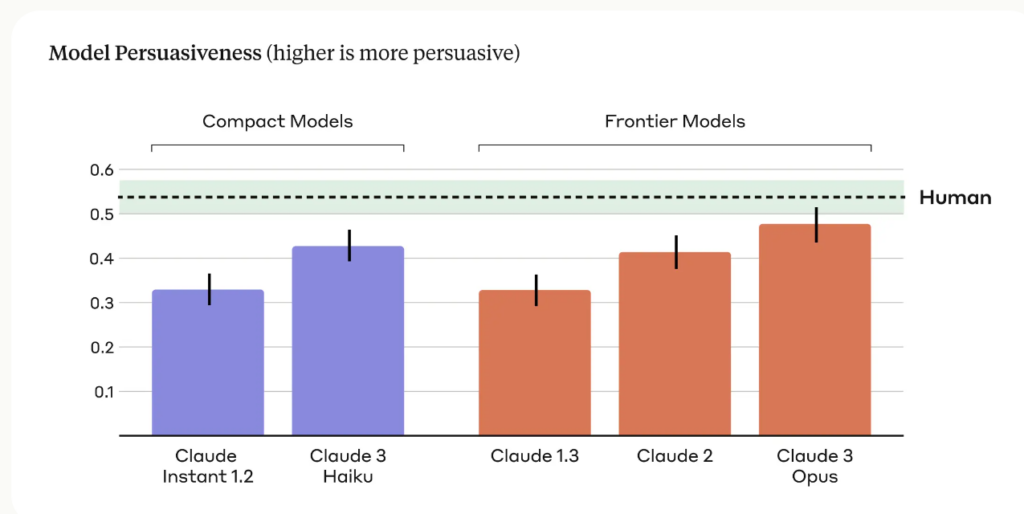

La investigación antrópica reveló que su último modelo de IA, Claude 3 Opus, puede generar argumentos tan persuasivos como los creados por humanos.

En investigacióndirigido por Esin Durmus, explora la relación entre la escala del modelo y su capacidad de persuasión en distintas generaciones de modelos lingüísticos antrópicos.

Se centró en 28 temas complejos y emergentes, como la moderación de contenidos en línea y las directrices éticas para la exploración espacial, en los que es menos probable que la gente tenga opiniones concretas o arraigadas.

Los investigadores compararon la capacidad de persuasión de los argumentos generados por varios modelos antrópicos, incluidos Claude 1, 2 y 3, con los escritos por participantes humanos.

Las principales conclusiones del estudio son las siguientes:

- En el estudio se emplearon cuatro preguntas distintas para generar argumentos generados por IA, lo que permitió captar una gama más amplia de estilos y técnicas de escritura persuasiva.

- Claude 3 Opus, el modelo más avanzado de Anthropic, produjo argumentos que eran estadísticamente indistinguibles de los argumentos escritos por humanos en términos de persuasión.

- Se observó una clara tendencia al alza en todas las generaciones de modelos, demostrando cada generación sucesiva una mayor capacidad de persuasión tanto en los modelos compactos como en los fronterizos.

El equipo de Anthropic admite sus limitaciones: "La persuasión es difícil de estudiar en un laboratorio; nuestros resultados pueden no trasladarse al mundo real."

Aun así, la capacidad de persuasión de Claude es impresionante, y no es el único estudio que lo demuestra.

En marzo de 2024, un equipo de la EPFL en Suiza y del Instituto Bruno Kessler en Italia descubrió que cuando GPT-4 tenía acceso a información personal sobre su oponente en el debate, era 81,7% más probable para convencer a su oponente que un humano.

Los investigadores concluyeron que "estos resultados demuestran que el microtargeting basado en LLM supera con creces tanto a los LLM normales como al microtargeting basado en humanos, siendo GPT-4 capaz de explotar la información personal de forma mucho más eficaz que los humanos".

Inteligencia artificial persuasiva para la ingeniería social

Los riesgos más evidentes de los LLM persuasivos son la coacción y la ingeniería social.

Como afirma Anthropic, "la capacidad de persuasión de los modelos lingüísticos suscita legítimas preocupaciones sociales en torno a su despliegue seguro y su posible uso indebido. La capacidad de evaluar y cuantificar estos riesgos es crucial para desarrollar salvaguardias responsables."

También debemos ser conscientes de cómo la creciente capacidad de persuasión de los modelos lingüísticos de IA podría combinarse con una tecnología puntera de clonación de voz como el motor de voz de OpenAI, que OpenAI consideró arriesgado publicar.

VoiceEngine sólo necesita 15 segundos para clonar de forma realista una voz, que podría utilizarse para casi cualquier cosa, incluidos sofisticados fraudes o estafas de ingeniería social.

Estafas profundas y falsas ya están muy extendidas y subirá de nivel si los actores de la amenaza empalman la tecnología de clonación de voz con las técnicas persuasivas de la IA, aterradoramente competentes.