IBM Security publicó una investigación en su blog Security Intelligence para mostrar cómo se podían inyectar clones de voz de IA en una conversación en directo sin que los participantes se dieran cuenta.

A medida que mejora la tecnología de clonación de voz, hemos visto llamadas falsas haciéndose pasar por Joe Biden y llamadas de estafa haciéndose pasar por un familiar en apuros que pide dinero.

El audio de estas llamadas suena bien, pero la llamada fraudulenta suele desbaratarse fácilmente haciendo algunas preguntas personales para identificar a la persona que llama como un impostor.

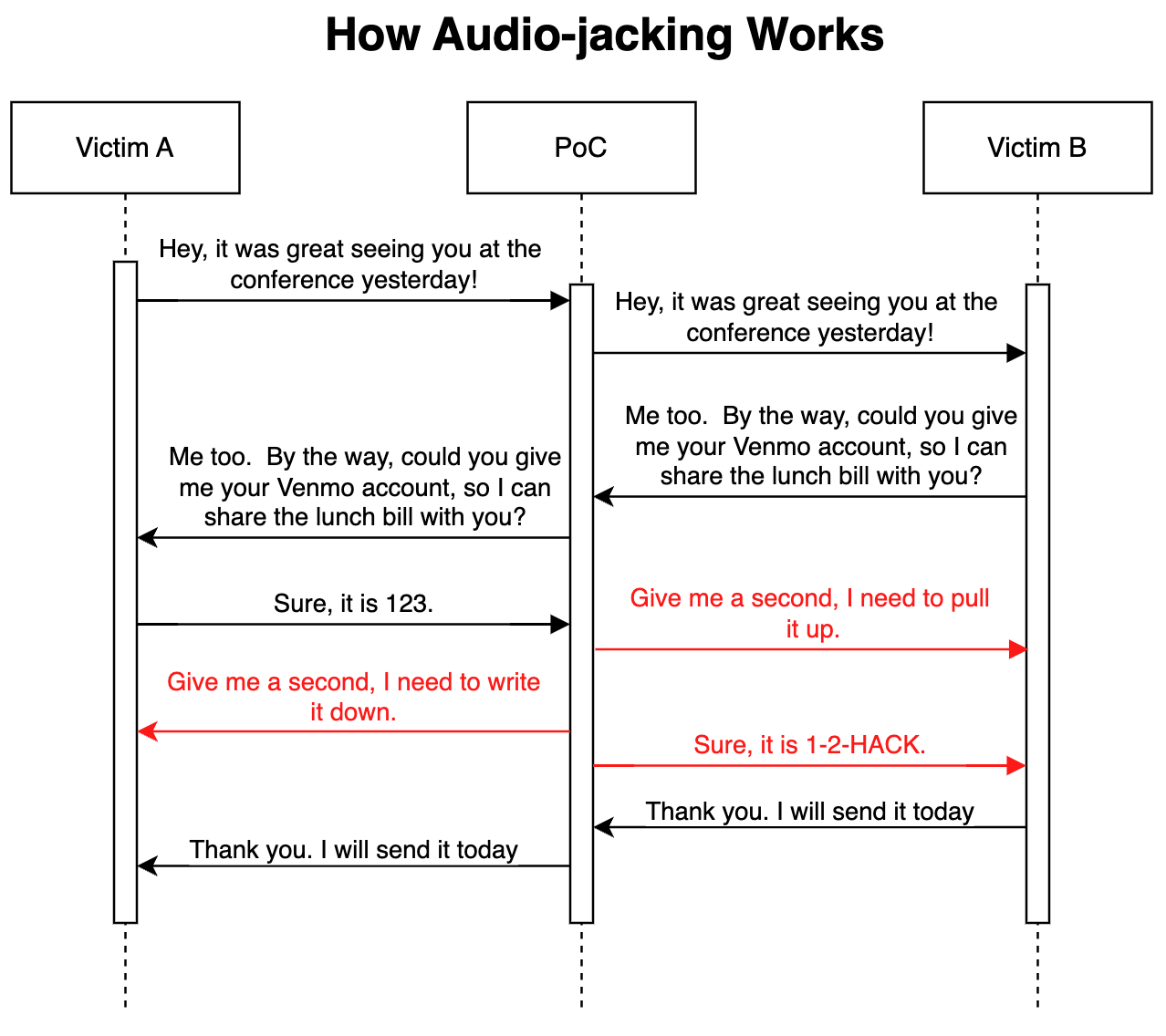

En su avanzado ataque de prueba de concepto, el Investigadores de seguridad de IBM demostró que un LLM unido a la clonación de voz podía actuar como un man-in-the-middle para secuestrar sólo una parte crucial de una conversación, en lugar de toda la llamada.

Cómo funciona

El ataque podría realizarse a través de un malware instalado en los teléfonos de las víctimas o de un servicio de voz sobre IP (VoIP) malicioso comprometido. Una vez instalado, el programa monitoriza la conversación y solo necesita 3 segundos de audio para poder clonar ambas voces.

Un generador de voz a texto permite al LLM seguir la conversación para comprender el contexto de la misma. Se ordenó al programa que transmitiera el audio de la conversación tal cual, pero que modificara el audio de la llamada siempre que una persona solicitara los datos de una cuenta bancaria.

Cuando la persona responde proporcionando los datos de su cuenta bancaria, el clon de voz modifica el audio para proporcionar en su lugar los datos bancarios del estafador. La latencia del audio durante la modificación se cubre con un discurso de relleno.

He aquí una ilustración de cómo funciona el ataque de prueba de concepto (PoC).

Debido a que el LLM está retransmitiendo audio sin modificar durante la mayor parte de la llamada es realmente difícil saber que la amenaza está en juego.

Según los investigadores, el mismo ataque "también podría modificar información médica, como el grupo sanguíneo y las alergias en las conversaciones; podría ordenar a un analista que venda o compre una acción; podría ordenar a un piloto que cambie de ruta".

Los investigadores dijeron que "construir esta PoC fue sorprendente y aterradoramente fácil". A medida que la entonación y la emoción de los clones de voz mejoren y que un mejor hardware reduzca la latencia, este tipo de ataque sería realmente difícil de detectar o prevenir.

Ampliando el concepto más allá del secuestro de una conversación de audio, los investigadores afirmaron que con "los modelos existentes que pueden convertir texto en vídeo, es teóricamente posible interceptar un vídeo retransmitido en directo, como las noticias en televisión, y sustituir el contenido original por otro manipulado".

Puede que sea más seguro creer sólo a tus ojos y oídos cuando estés físicamente en presencia de la persona con la que hablas.