El entrenamiento de modelos de IA como GPT-4 se ha basado principalmente en conjuntos de datos formados por texto e imágenes. El conjunto de datos de percepción multimodal Ego-Exo4D de Meta ofrece a los científicos de datos un nuevo y rico conjunto de datos de entrenamiento.

Puedes aprender una nueva habilidad leyendo un libro, pero es mucho más fácil cuando alguien te muestra cómo hacer algo mientras te lo explica. Este es el objetivo que el equipo FAIR (Fundamental Artificial Intelligence Research) de Meta tiene para Ego-Exo4D.

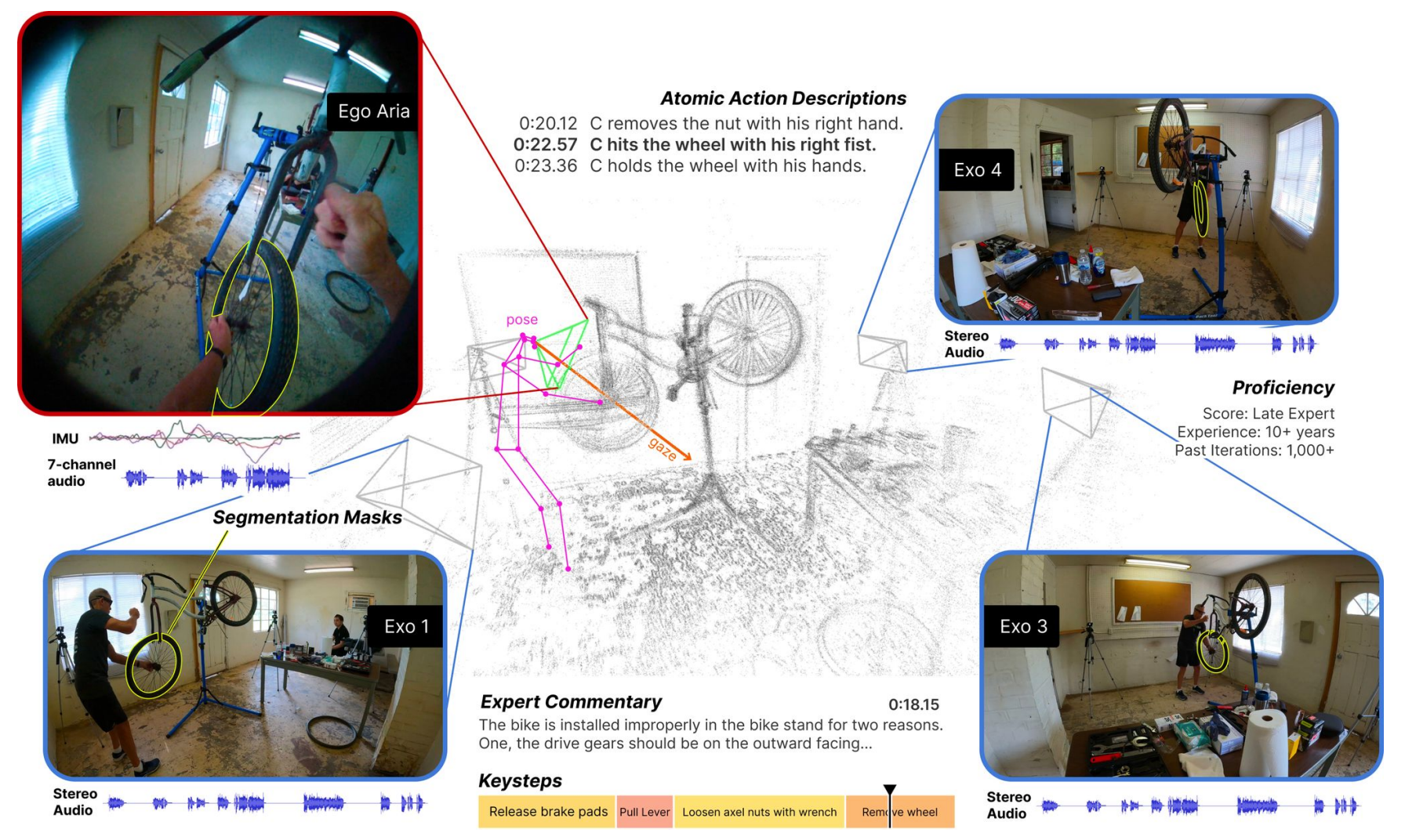

El conjunto de datos consta de vídeos en primera persona (Ego) y en tercera persona (Exo) de personas que realizan distintas actividades humanas. Por ejemplo, cocinar, bailar, tocar música o reparar una bicicleta. Los datos fueron recogidos en 13 ciudades de todo el mundo por 839 usuarios de cámaras, que capturaron 1.422 horas de vídeo.

Los vídeos, que se graban simultáneamente, se complementan con otras modalidades de datos gracias a las gafas Project Aria de Meta.

Las gafas Project Aria son ordenadores portátiles en forma de gafas. Captan el vídeo y el audio del usuario, así como su seguimiento ocular e información sobre su ubicación. También detectan la postura de la cabeza y nubes de puntos 3D del entorno.

El resultado es un conjunto de datos de vídeos simultáneos de una tarea realizada, con narraciones en primera persona de los usuarios de la cámara describiendo sus acciones, y seguimiento de la cabeza y los ojos de la persona que realiza la tarea.

Presentamos Ego-Exo4D, un conjunto de datos fundamentales y de referencia centrado en actividades humanas cualificadas para apoyar la investigación sobre el aprendizaje por vídeo y la percepción multimodal. Es el mayor conjunto de datos público de su clase.

Más información ➡️ https://t.co/82OR4msehv pic.twitter.com/NTI1kdj1RN

- AI en Meta (@AIatMeta) 4 de diciembre de 2023

A continuación, Meta añadió descripciones en tercera persona de las acciones de cada usuario de la cámara. Meta también contrató a expertos en múltiples campos para que añadieran comentarios hablados en tercera persona criticando la forma en que la persona del vídeo realizaba la tarea.

Al recoger vistas egocéntricas y exocéntricas, el conjunto de datos Ego-Exo4D puede mostrar a los investigadores cómo son las actividades desde distintas perspectivas. Esto podría ayudarles a desarrollar algoritmos de visión por ordenador capaces de reconocer lo que hace una persona desde cualquier perspectiva.

Ego-Exo4D abre nuevas oportunidades de aprendizaje

Uno de los principales obstáculos para lograr la AGI o entrenar robots de forma más eficiente es la falta de percepción sensorial que tienen los ordenadores. Como humanos, tenemos muchas percepciones sensoriales de nuestro entorno que a menudo damos por sentadas cuando aprendemos nuevas habilidades.

Ego-Exo4D será un recurso extremadamente útil para ayudar a salvar esta brecha.

El Dr. Gedas Bertasius, profesor adjunto del Departamento de Informática de la Universidad de Carolina del Norte, ha declarado: "Ego-Exo4D no se limita a recopilar datos, sino que trata de cambiar la forma en que la IA entiende, percibe y aprende. Con un aprendizaje y una perspectiva centrados en el ser humano, la IA puede ser más útil en nuestra vida cotidiana, ayudándonos de formas que sólo hemos imaginado."

Meta afirma que espera que Ego-Exo4D "permita a los robots del futuro comprender las complejas manipulaciones de destreza observando a expertos humanos en acción".

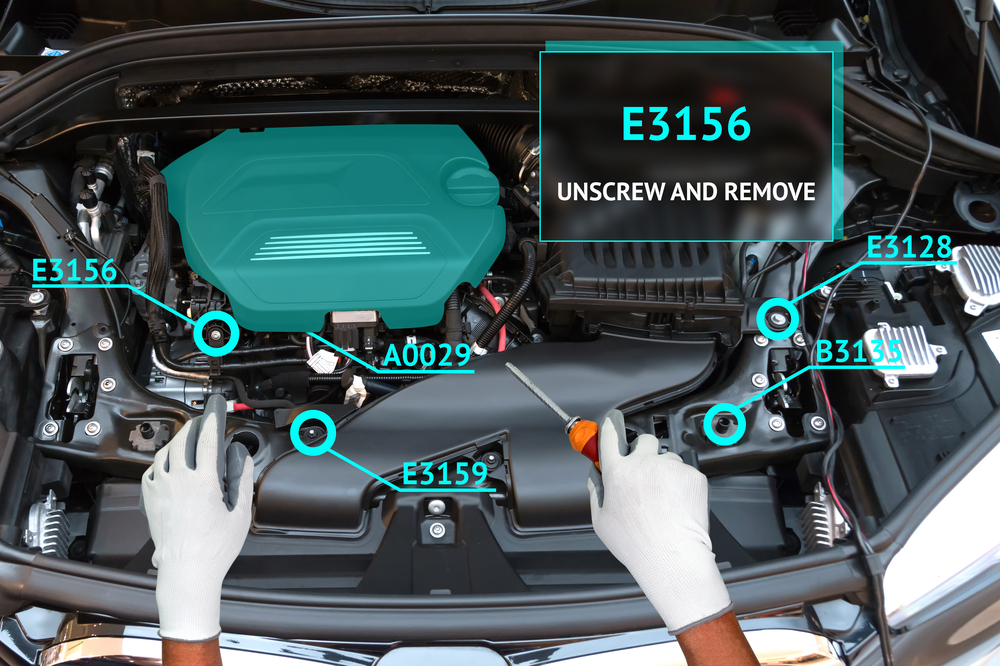

Este conjunto de datos, combinado con las gafas del Proyecto Aria, pronto hará posible una experiencia de aprendizaje realmente envolvente para los seres humanos. Imagina realizar una tarea mientras tus gafas utilizan la realidad aumentada (RA) para superponer un vídeo tutorial o guiarte a través de la tarea.

Podrías aprender a tocar el piano y tener una superposición visual que te muestre dónde debes mover las manos con consejos de audio en tiempo real mientras lo haces. O puedes abrir el capó de tu coche y que te guíen en la localización y reparación de un problema en el motor.

Será interesante ver si Meta Concepto de aprendizaje Ego How-To impulsará una mayor adopción de las gafas Project Aria que la que experimentó el fallido producto Google Glass. Aún no se sabe cuándo estarán a la venta.

Meta hará que el conjunto de datos Ego-Exo4D disponible para descargar antes de finales de diciembre.