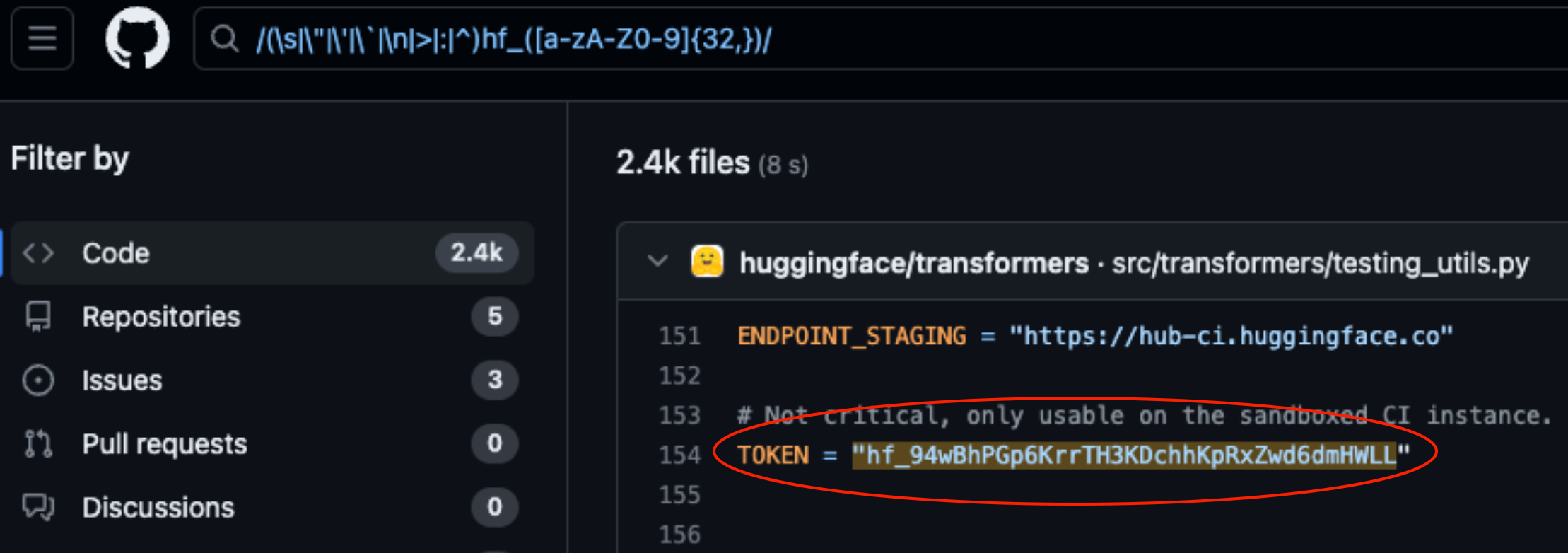

Lasso Security expuso vulnerabilidades de seguridad en HuggingFace y GitHub tras encontrar 1681 tokens de API expuestos codificados de forma rígida en código almacenado en las plataformas.

HuggingFace y GitHub son dos de los repositorios más populares donde los desarrolladores pueden proporcionar acceso a sus modelos y código de IA. Piense en ellos como carpetas en la nube gestionadas por las organizaciones propietarias.

HuggingFace y GitHub facilitan a los usuarios la interacción con cientos de miles de modelos y conjuntos de datos de IA a través de API. También permite a las organizaciones propietarias de los modelos y conjuntos de datos utilizar el acceso a la API para leer, crear, modificar y eliminar repositorios o archivos.

Los permisos asociados a su token de API determinan el nivel de acceso que tiene. Lazo encontrado que con un poco de investigación, pudieron encontrar muchos tokens en código almacenado en repositorios de las plataformas.

De los 1681 tokens válidos que encontraron, 655 tokens de usuarios tenían permisos de escritura, 77 de los cuales tenían permisos de cuenta completos.

¿Por qué es tan importante?

Piense en un token API como si fuera la llave de la puerta de su casa. Puede que le resulte cómodo dejar la llave debajo del felpudo, pero si alguien la encuentra podrá entrar en su casa.

Cuando los desarrolladores escriben una pieza de código que necesita interactuar con su modelo de IA o conjunto de datos, a veces se vuelven un poco perezosos. Pueden codificar los tokens en su código en lugar de utilizar formas más seguras de gestionarlos.

Algunos de los tokens encontrados por Lasso les daban permisos completos de lectura y escritura en Meta. Llama 2BigScience Workshop y EleutherAI. Todas estas organizaciones tienen modelos de IA que se han descargado millones de veces.

Si Losso fueran los malos, podrían haber modificado los modelos o conjuntos de datos de los repositorios expuestos. Imagina que alguien añadiera algún código furtivo en el repositorio de Meta y luego millones de personas lo descargaran.

Cuando Meta, Google, Microsoft y otros se enteraron de los tokens de API expuestos, los revocaron rápidamente.

El robo de modelos, el envenenamiento de datos de entrenamiento y la combinación de conjuntos de datos de terceros y modelos preentrenados son grandes riesgos para las empresas de IA. El hecho de que los desarrolladores dejen los tokens de API expuestos en el código no hace más que facilitar que los malos actores se aprovechen de ellos.

Cabe preguntarse si los ingenieros de Lasso fueron los primeros en encontrar estas vulnerabilidades.

Si ciberdelincuentes encontrado estas fichas sin duda habrían guardado mucho silencio mientras abrían la puerta principal.