Nvidia ha escalado y optimizado su superordenador de IA Eos para establecer nuevos récords de referencia de entrenamiento de IA MLPerf.

Cuando Nvidia encendió su superordenador de IA Eos en mayo, 10.752 GPUs NVIDIA H100 Tensor Core cobraron vida y acaban de someterse a algunas pruebas en el mundo real.

Esta potencia de procesamiento sin precedentes, junto con las nuevas optimizaciones de software, ha permitido a Eos impulsar el MLPerf referencia en territorio récord.

El banco de pruebas de código abierto MLPerf es un conjunto de pruebas de entrenamiento e inferencia diseñado para medir el rendimiento de las cargas de trabajo de aprendizaje automático en conjuntos de datos del mundo real.

Uno de los resultados más destacados fue que Eos fue capaz de entrenar un modelo GPT-3 con 175.000 millones de parámetros en mil millones de fichas en sólo 3,9 minutos.

Cuando Nvidia estableció el récord en esta prueba hace menos de 6 meses, tardó casi 3 veces más, con un tiempo de 10,9 minutos.

Nvidia también fue capaz de alcanzar un índice de eficiencia de 93% durante las pruebas, lo que significa que utilizó casi toda la potencia de cálculo teóricamente disponible en Eos.

Microsoft Azure, que utiliza prácticamente la misma configuración H100 que Eos en su máquina virtual ND H100 v5, se quedó a 2% de los resultados de Nvidia en sus pruebas MLPerf.

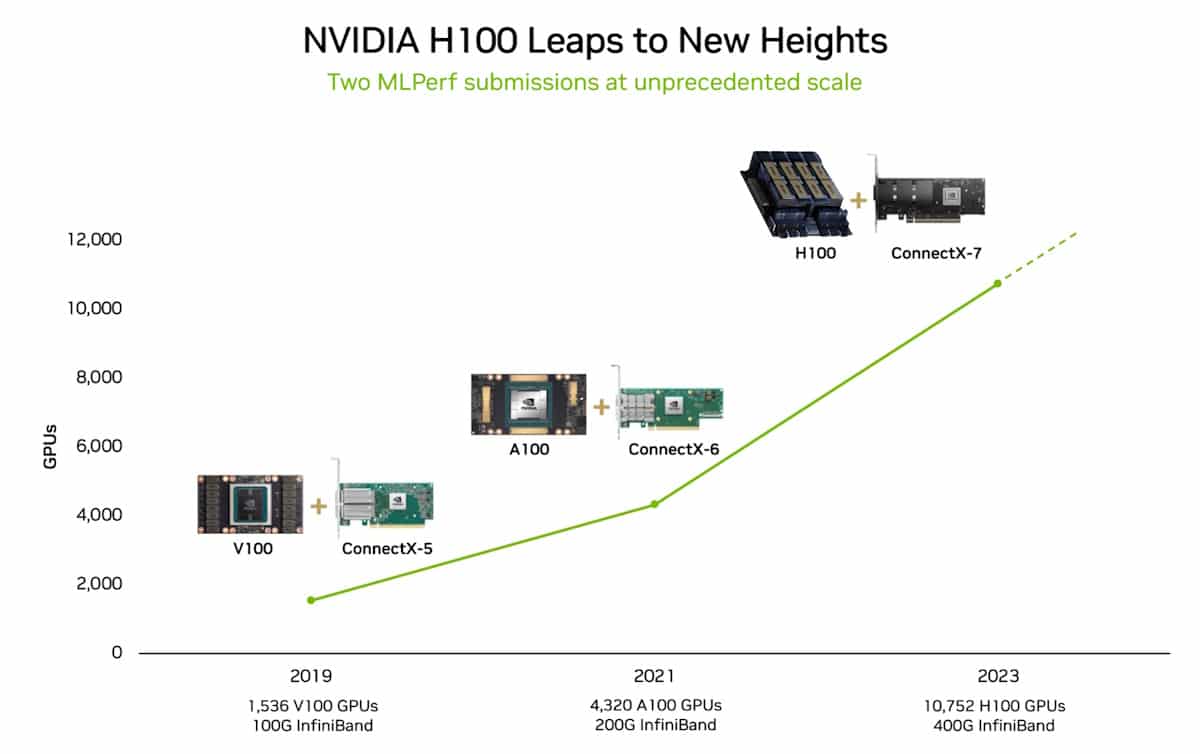

En 2018 Jensen Huang, CEO de Nvidia, afirmó que el rendimiento de las GPU se duplicará con creces cada dos años. Esta afirmación fue acuñada como la Ley de Haung y ha demostrado ser cierta ya que deja La Ley de Moore desaparece en el retrovisor informático.

¿Y qué?

La prueba de entrenamiento MLPerf que superó Nvidia utiliza sólo una parte del conjunto de datos completo con el que se entrenó GPT-3. Si se toma el tiempo establecido por Eos en la prueba MLPerf y se extrapola al conjunto de datos completo de GPT-3, se podría entrenar el modelo completo en tan solo 8 días.

Si se intentara hacerlo con su anterior sistema de última generación compuesto por 512 GPU A100, se tardaría unos 170 días.

Si estuvieras entrenando un nuevo modelo de IA, ¿te imaginas la diferencia en tiempo de comercialización y coste que representan 8 días frente a 170 días?

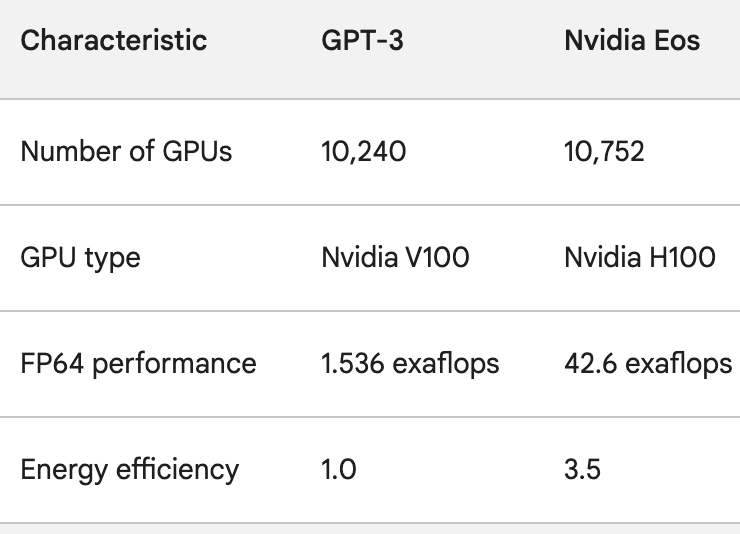

Las GPU H100 no sólo son mucho más potentes que las GPU A100, sino que además son hasta 3,5 veces más eficientes desde el punto de vista energético. Uso de la energía y La huella de carbono de la IA son problemas reales que hay que abordar.

Para hacernos una idea de lo rápido que está mejorando el procesamiento de la IA, pensemos en ChatGPT, que se puso en marcha hace poco menos de un año. El modelo subyacente, GPT-3, se entrenó en 10.240 GPU Nvidia V100.

Menos de un año después, Eos tiene 28 veces la potencia de procesamiento de esa configuración con una mejora de la eficiencia de 3,5 veces.

Cuando Sam Altman de OpenAI concluyó el reciente DevDay dijo que los proyectos en los que OpenAI estaba trabajando harían que sus últimas versiones parecieran pintorescas.

Teniendo en cuenta el salto en potencia de procesamiento que están logrando empresas como Nvidia, la afirmación de Altman probablemente resume el futuro de la industria de la IA en su conjunto.