Los modelos multilingües multimodales (MLLM) como el GPT-4V son realmente buenos analizando y describiendo imágenes, pero a veces alucinan y se equivocan. Un nuevo enfoque llamado Woodpecker podría solucionarlo.

Si se le pide a un MLLM que describa una foto, normalmente puede identificar los objetos y describir la escena con precisión. Pero, al igual que ocurre con las respuestas a preguntas textuales, el modelo a veces hace suposiciones basadas en elementos o conceptos que a menudo aparecen juntos.

Como resultado, un MLLM podría describir una foto de la escena de un escaparate y decir que hay personas en la escena cuando en realidad no las hay.

Corregir las alucinaciones en los LLM basados en texto es un proceso continuo, pero resulta mucho más fácil cuando el modelo está conectado a Internet. El LLM puede generar una respuesta textual a una pregunta, comprobar su veracidad basándose en datos relevantes de Internet y autocorregirse cuando sea necesario.

Científicos del laboratorio YouTu de Tencent y de la Universidad de Ciencia y Tecnología de China adoptaron este enfoque y lo plasmaron en una solución visual llamada Woodpecker.

En términos sencillos, Woodpecker construye un corpus de conocimiento a partir de la imagen y luego un LLM puede utilizarlo como referencia para corregir la descripción inicial generada por el MLLM.

He aquí una breve descripción de su funcionamiento:

- Un LLM como GPT-3.5 Turbo analiza la descripción generada por el MLLM y extrae conceptos clave como objetos, cantidades y atributos. Por ejemplo, en la frase "El hombre lleva un sombrero negro", se extraen los objetos "hombre" y "sombrero".

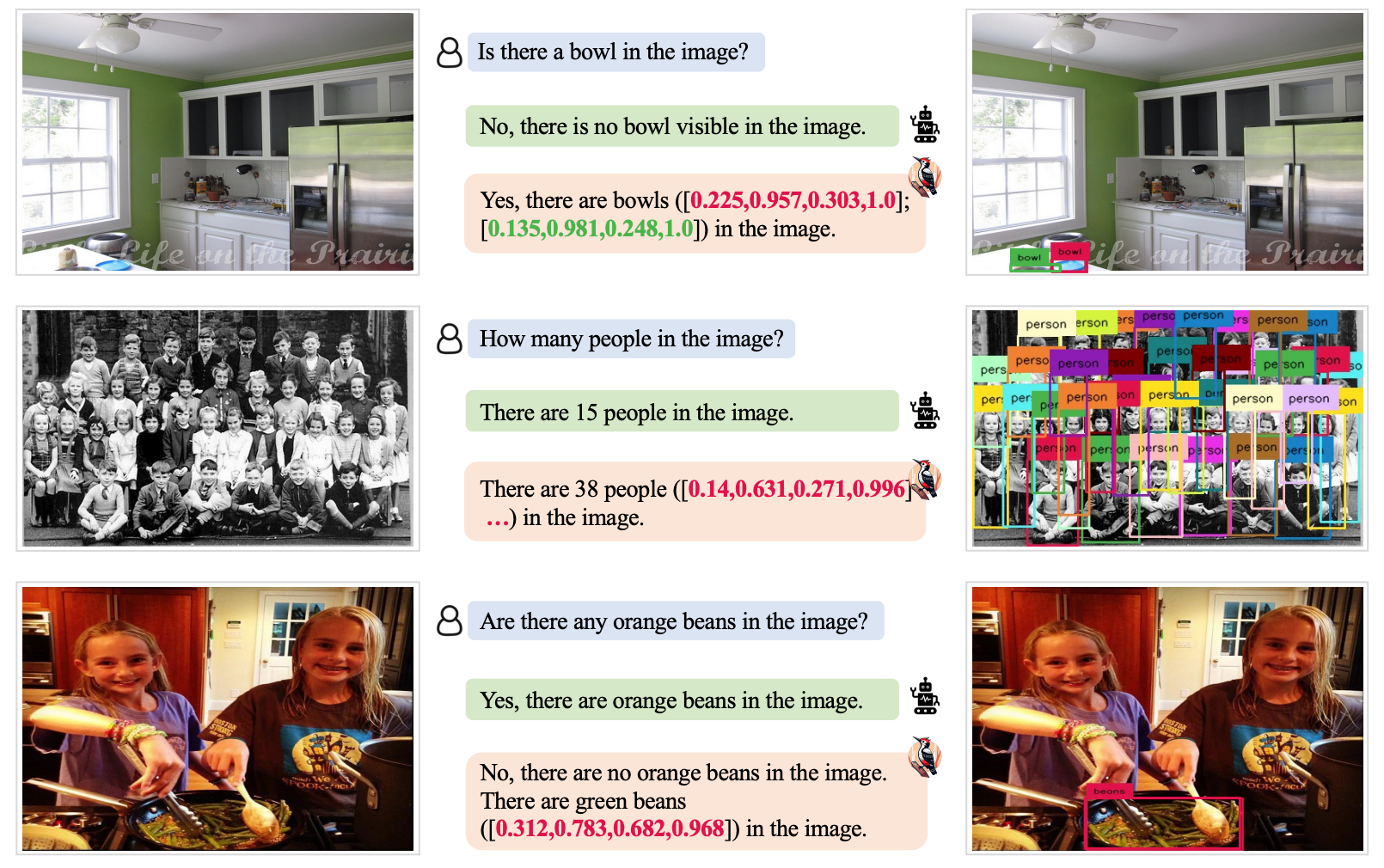

- A continuación, se pide a un LLM que genere preguntas relacionadas con estos conceptos como "¿Hay un hombre en la imagen?" o "¿Qué lleva puesto el hombre?".

- Estas preguntas se envían a un modelo de respuesta a preguntas visuales (VQA). Grounding DINO realiza la detección y el recuento de objetos, mientras que BLIP-2-FlanT5 VQA responde a las preguntas relacionadas con atributos tras analizar la imagen.

- Un LLM combina las respuestas a las preguntas en una base de conocimiento visual de la imagen.

- Un LLM utiliza este corpus de conocimientos de referencia para corregir cualquier alucinación en la descripción del MLLM original y añade detalles que se le pasaron por alto.

Los investigadores bautizaron su método con el nombre de "pájaro carpintero", en referencia al modo en que este pájaro recoge insectos de los árboles.

Los resultados de las pruebas mostraron que Woodpecker consiguió una mejora de la precisión de 30,66% para MiniGPT4 y de 24,33% para los modelos mPLUG-Owl.

La naturaleza genérica de los modelos requeridos en este enfoque significa que el enfoque del Pájaro Carpintero podría integrarse fácilmente en varios MLLM.

Si OpenAI integra Woodpecker en ChatGPT, podríamos ver una notable mejora en el ya impresionante rendimiento visual. Una reducción de la alucinación MLLM también podría mejorar la toma de decisiones automatizada por parte de los sistemas que utilizan descripciones visuales como entradas.